阿里云开发者社区

大家在互动

大家在关注

综合

最新

有奖励

免费用

让你的文档从静态展示到一键部署可操作验证

通过函数计算的能力让阿里云的文档从静态展示升级为动态可操作验证,用户在文档中单击一键部署可快速完成代码的部署及测试。这一改变已在函数计算的活动沙龙中得到用户的认可。

一键生成视频!用 PAI-EAS 部署 AI 视频生成模型 SVD 工作流

本教程将带领大家免费领取阿里云PAI-EAS的免费试用资源,并且带领大家在 ComfyUI 环境下使用 SVD的模型,根据任何图片生成一个小短视频。

倚天使用|YODA倚天应用迁移神器,让跨架构应用迁移变得简单高效

YODA(Yitian Optimal Development Assistant,倚天应用迁移工具)旨在帮助用户更加高效、便捷地实现跨平台、跨结构下的应用迁移,大幅度缩短客户在新平台上端到端性能验

Paimon 与 Spark 的集成(二):查询优化

通过一系列优化,我们将 Paimon x Spark 在 TpcDS 上的性能提高了37+%,已基本和 Parquet x Spark 持平,本文对其中的关键优化点进行了详细介绍。

ECS实例选型最佳实践

本课程主要讲解在客户明确自身业务功能、性能、稳定性需求,以及成本成本约束后去了解各规格族/规格特性,匹配自身需求选择所需服务器类型。实例规格选型最佳实践,就是为了帮助用户结合自身业务需求中性能、价格、

创建to do list应用教程

阿里云讲师手把手带你部署to do list,本实验支持使用 个人账号资源 或 领取免费试用额度 进行操作,建议优先选用通过已领取的云工开物高校计划学生300元优惠券购买个人账号资源的方案,如您具备免

conda数据源在昨天失效返回404,当前依赖的包无法安装和使用

问题描述conda数据源在失效返回404当前依赖的包无法安装和使用失效的镜像通道地址conda-forge: http://mirrors.aliyun.com/anaconda/cloud

阿里云百炼大模型产品实践

PAI-EAS 一键启动ComfyUI!SVD 图片一键生成视频 stable video diffusion 教程 SVD工作流

PAI-EAS 一键启动ComfyUI!SVD 图片一键生成视频 stable video diffusion 教程 SVD工作流

阿里云产品手册2024版

阿里云作为数字经济的重要建设者,不断加深硬核科技实力,通过自身能力助力客户实现高质量发展,共创数字新世界。阿里云产品手册 2024 版含产品大图、关于阿里云、引言、安全合规等内容,覆盖人工智能与机器学

加载ModelScope模型以后,为什么调用,model.chat()会提示错误?

加载ModelScope模型以后为什么调用model.chat()会提示错误AttributeError: Qwen2ForCausalLM object has no attribute chat

深入探究Java微服务架构:Spring Cloud概论

**摘要:** 本文深入探讨了Java微服务架构中的Spring Cloud,解释了微服务架构如何解决传统单体架构的局限性,如松耦合、独立部署、可伸缩性和容错性。Spring Cloud作为一个基于

访问控制(RAM)|云上安全使用AccessKey的最佳实践

集中管控AK/SK的生命周期,可以极大降低AK/SK管理和使用成本,同时通过加密和轮转的方式,保证AK/SK的安全使用,本次分享为您介绍产品原理,以及具体的使用步骤。

All in One:Prometheus 多实例数据统一管理最佳实践

当管理多个Prometheus实例时,阿里云Prometheus托管版相比社区版提供了更可靠的数据采集和便捷的管理。本文比较了全局聚合实例与数据投递方案,两者在不同场景下各有优劣。

Higress 全新 Wasm 运行时,性能大幅提升

本文介绍 Higress 将 Wasm 插件的运行时从 V8 切换到 WebAssembly Micro Runtime (WAMR) 的最新进展。

更高效准确的数据库内部任务调度实践,阿里云数据库SelectDB 内核 Apache Doris 内置 Job Scheduler 的实现与应用

Apache Doris 2.1 引入了内置的 Job Scheduler,旨在解决依赖外部调度系统的问题,提供秒级精确的定时任务管理。

云效流水线智能排查功能实测:AI赋能DevOps,精准定位与高效修复实战评测

云效持续集成流水线Flow是阿里云提供的企业级CICD工具,免费且注册即用。它具备高可用性、免运维、深度集成阿里云服务、多样化发布策略及丰富的企业级特性。产品亮点包括智能排查功能,能快速定位问题,提高

【活动推荐】Alibaba Cloud Linux实践操作学习赛,有电子证书及丰厚奖品!

参与开放原子基金会的[龙蜥社区Alibaba Cloud Linux实践操作学习赛](https://competition.atomgit.com/competitionInfo),获取电子证书。报

Higress 基于自定义插件访问 Redis

本文介绍了Higress,一个支持基于WebAssembly (WASM) 的边缘计算网关,它允许用户使用Go、C++或Rust编写插件来扩展其功能。文章特别讨论了如何利用Redis插件实现限流、缓存

第十三期乘风伯乐奖--寻找百位乘风者伯乐,邀请新博主入驻即可获奖

乘风伯乐奖,面向阿里云开发者社区已入驻乘风者计划的博主(技术/星级/专家),邀请用户入驻乘风者计划即可获得乘风者定制周边等实物奖励。本期面向阿里云开发者社区寻找100位乘风伯乐,邀请人数月度TOP 1

开源开发者沙龙北京站 | 微服务安全零信任架构

讲师/嘉宾简介 刘军(陆龟)|Apache Member 江河清(远云)|Apache Dubbo PMC 孙玉梅(玉梅)|阿里云技术专家 季敏(清铭)|Higress Maintainer 丁双喜(

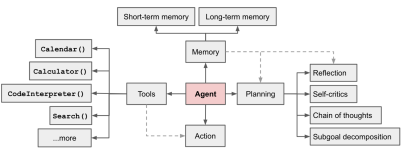

智能体(Agent)平台介绍

2023年11月9日,比尔盖茨先生发布了《人工智能即将彻底改变你使用计算机的方式》文章,详尽阐明了Agent(智能体)这个新一代智能应用的技术理念。在个人助理、卫生保健、教育、生产率、娱乐购物、科技等

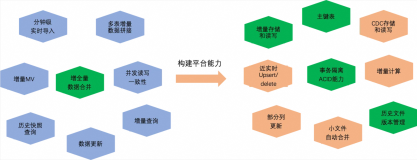

MaxCompute 近实时增全量处理一体化新架构和使用场景介绍

本文主要介绍基于 MaxCompute 的离线近实时一体化新架构如何来支持这些综合的业务场景,提供近实时增全量一体的数据存储和计算(Transaction Table2.0)解决方案。

Agent平台快速体验

通过《智能体(Agent)平台介绍》您了解到Agent及其构建平台的价值,通过《在函数计算上部署专属的Agent平台》你获得了专属的Agent平台,本篇进入更加激动人心的使用阶段,一起探索Agent的

[软件自动化测试] selenium java环境配置

介绍了包括选择Gradle构建,关闭Gradle Wrapper的默认下载,修改`gradle-wrapper.properties`以使用腾讯云镜像,以及更新`build.gradle`文件添加国内

20行代码,Serverless架构下用Python轻松搞定图像分类和预测

本文将AI项目与Serverless架构进行结合,在Serverless架构下用20行Python代码搞定图像分类和预测。

探索移动应用开发的未来:跨平台工具与原生系统之争

【4月更文挑战第19天】 在本文中,我们将深入探讨移动应用开发领域的两个关键趋势:跨平台开发工具的兴起和移动操作系统的最新进展。文章将分析如何通过使用如Flutter、React Native等流行的

移动应用开发的未来:跨平台框架与原生系统协同进化

【4月更文挑战第19天】 随着移动互联网的迅猛发展,移动应用(App)成为日常生活和商业活动不可或缺的组成部分。本文深入探讨了移动应用开发领域的最新趋势,特别是跨平台开发框架与原生操作系统之间的相互作

构建未来:移动应用中的增强现实技术

【4月更文挑战第19天】随着移动技术的飞速发展,增强现实(AR)技术在移动应用中的作用日益凸显。本文将探讨增强现实技术如何改变移动应用的交互方式,提升用户体验,并推动商业价值的最大化。我们将分析当前市

Java中的多线程并发编程实践

【4月更文挑战第19天】 在现代软件开发中,多线程技术是实现高效并发处理的关键技术之一。Java语言提供了丰富的API和机制来支持多线程编程,允许开发者创建和管理多个执行线程,以提升程序的性能和响应性

移动应用开发的未来:跨平台框架与原生系统之争

【4月更文挑战第19天】随着移动互联网的飞速发展,移动应用已成为日常生活中不可或缺的一部分。本文探讨了移动应用开发领域的两大趋势:跨平台应用框架的兴起和原生操作系统的持续创新。分析了Flutter、R

构建高效微服务架构:从理论到实践

【4月更文挑战第19天】 在现代软件开发中,微服务架构已经成为实现模块化、可伸缩和灵活部署的一种流行方案。本文将深入探讨如何构建一个高效的微服务系统,涵盖从基本理念的阐述到具体技术选型,再到实践中可能

构建未来:云原生架构在企业数字化转型中的关键作用

【4月更文挑战第19天】 随着企业加速其数字化转型的步伐,云原生架构已成为实现敏捷性、可扩展性和创新的关键驱动力。本文将探讨云原生技术如何助力企业优化资源配置,加速产品上市时间,并提高服务的可靠性与安

深入理解操作系统:进程管理与调度策略

【4月更文挑战第19天】 在现代计算机系统中,操作系统扮演着至关重要的角色。它负责管理硬件资源、提供用户接口以及执行程序。其中,进程管理是操作系统的核心职能之一,它涉及到进程的创建、执行、监控和终止等

利用深度学习优化图像识别系统

【4月更文挑战第19天】随着人工智能的不断发展,深度学习技术在图像识别领域取得了显著成果。本文将探讨如何利用深度学习技术优化图像识别系统,提高识别准确率和效率。我们将介绍卷积神经网络(CNN)的原理,

查看pod资源使用情况

使用`kubectl top pod -n $namespace|grep online`检查Kubernetes pod资源使用,例如CPU和内存。同样,通过`kubectl top nodes`查

浙江电网ERP系统运维手册

`浙江电网ERP系统`的运维手册强调日常巡检以确保系统稳定。每天早上九点进行检查,包括技术中台(如kube-apiserver, kube-controller-manager, kube-sched

iOS 中的并发编程模式:理解 GCD 和 Operation Queues

【4月更文挑战第19天】 在现代 iOS 应用开发中,有效地管理线程和并发是至关重要的。为了确保用户界面的流畅性和后台任务的高效运行,开发者需要掌握并发编程技术。本文深入探讨了两种主要的并发模式:Gr

网络防线构建:洞悉安全漏洞与加密技术的融合之道

【4月更文挑战第19天】在数字化时代,网络安全与信息安全已成为维护网络空间主权和数据完整性的基石。本文探讨了网络安全漏洞的成因、加密技术的重要性以及提升安全意识的必要性,旨在为读者提供全面的安全防护策

深度学习驱动下的智能监控革新:图像识别技术的前沿应用

【4月更文挑战第19天】 在数字时代,智能监控系统作为城市安全和效率的守护者,正经历着前所未有的技术变革。本文深入探讨了基于深度学习的图像识别技术如何重塑智能监控领域,通过算法创新提升识别准确率,实时

网络安全与信息安全:防范漏洞、加密技术与提升安全意识

【4月更文挑战第19天】 在数字化时代,网络安全与信息安全已成为维护个人隐私、企业数据和国家利益的关键。本文探讨了网络安全中的漏洞问题、加密技术的进展以及提升安全意识的重要性。通过对常见网络攻击手段的

深度学习在图像识别中的应用与挑战

【4月更文挑战第19天】 随着人工智能技术的飞速发展,深度学习已成为推动计算机视觉进步的核心技术之一。本文旨在探讨深度学习在图像识别领域的应用及其面临的挑战。通过回顾卷积神经网络(CNN)的发展历程、

构筑安全之盾:云计算环境下的网络安全策略与实践

【4月更文挑战第19天】 在数字化转型的浪潮中,云计算已成为企业IT架构的核心组成部分。然而,随着云服务使用的普及化,网络安全问题亦变得日益复杂和挑战性。本文将深入探讨如何在云计算环境中实施有效的网络

Java并发编程:深入理解Synchronized关键字

【4月更文挑战第19天】 在Java多线程编程中,为了确保数据的一致性和线程安全,我们经常需要使用到同步机制。其中,`synchronized`关键字是最为常见的一种方式,它能够保证在同一时刻只有一个

机器人飞船404页面模板HTML源码

机器人飞船404页面模板HTML源码,源码由HTML+CSS+JS组成,记事本打开源码文件可以进行内容文字之类的修改,双击html文件可以本地运行效果,也可以上传到服务器里面,重定向这个界面

深入白盒测试:代码级透视与质量保证

【4月更文挑战第18天】 在软件工程领域,白盒测试是一种重要的测试方法,通过深入分析程序内部结构、设计和编码实现来发现潜在缺陷。与传统的摘要不同,本文旨在探讨白盒测试的核心原理和实施策略,并着重于如何

网络安全与信息安全:防御前线的关键技术与意识

【4月更文挑战第18天】在数字化时代,数据成为了新的货币,而网络安全则是保护这些宝贵资产不受威胁的盾牌。本文深入探讨了网络安全的核心议题—漏洞管理、加密技术以及安全意识的重要性。通过分析当前网络环境中

qwen-vl-chat 自我认知微调最佳实践时报错,好像是编码错误!求解!

代码import osos.environ[CUDA_VISIBLE_DEVICES] 0 from swift.llm import DatasetName, ModelType, SftArg

云端守卫:融合云计算与网络安全的未来之路

【4月更文挑战第18天】 随着数字化转型的不断深入,云计算已成为支撑现代企业架构的关键基石。然而,伴随其发展的同时,网络威胁亦步步紧逼,使得安全成为云服务领域的核心议题。本文将探讨云计算环境中的网络安

外部中断的使用方法

这篇文章介绍了中断的概念,以一个生动的故事比喻,说明中断是如何打断主程序执行并调用中断函数的。文章提到了Arduino控制器和"吃货"模型,展示了如何编写处理吃和开门的代码,并介绍