阿里云开发者社区

大家在互动

大家在关注

综合

最新

有奖励

免费用

社区供稿 | FunASR 语音大模型在 Arm Neoverse 平台上的优化实践

Arm 架构的服务器通常具备低功耗的特性,能带来更优异的能效比。相比于传统的 x86 架构服务器,Arm 服务器在相同功耗下能够提供更高的性能。这对于大模型推理任务来说尤为重要,因为大模型通常需要大量

让你的文档从静态展示到一键部署可操作验证

通过函数计算的能力让阿里云的文档从静态展示升级为动态可操作验证,用户在文档中单击一键部署可快速完成代码的部署及测试。这一改变已在函数计算的活动沙龙中得到用户的认可。

一键生成视频!用 PAI-EAS 部署 AI 视频生成模型 SVD 工作流

本教程将带领大家免费领取阿里云PAI-EAS的免费试用资源,并且带领大家在 ComfyUI 环境下使用 SVD的模型,根据任何图片生成一个小短视频。

ECS实例选型最佳实践

本课程主要讲解在客户明确自身业务功能、性能、稳定性需求,以及成本成本约束后去了解各规格族/规格特性,匹配自身需求选择所需服务器类型。实例规格选型最佳实践,就是为了帮助用户结合自身业务需求中性能、价格、

Redis核心开发者的新征程:阿里云与Valkey社区的技术融合与创新

阿里云瑶池数据库团队后续将持续参与Valkey社区,如过往在Redis社区一样耕耘,为开源社区作出持续贡献。

PAI-EAS 一键启动ComfyUI!SVD 图片一键生成视频 stable video diffusion 教程 SVD工作流

PAI-EAS 一键启动ComfyUI!SVD 图片一键生成视频 stable video diffusion 教程 SVD工作流

阿里云产品手册2024版

阿里云作为数字经济的重要建设者,不断加深硬核科技实力,通过自身能力助力客户实现高质量发展,共创数字新世界。阿里云产品手册 2024 版含产品大图、关于阿里云、引言、安全合规等内容,覆盖人工智能与机器学

flinkcdc3.0整库同步mysql的数据到starrocks中全量能过去增量过不去怎么排查?

flinkcdc3.0整库同步mysql的数据到starrocks中 全量能过去增量过不去怎么排查?

阿里云百炼大模型产品实践

阿里云 ClickHouse 企业版商业化发布会

阿里云 ClickHouse 企业版是阿里云和ClickHouse原厂 ClickHouse. Inc 独家合作的存算分离的云原生版本,支持资源按需弹性 Serverless,帮助企业降低成本的同时,

宜搭:提交表单前,如何校验另一张表单的数据?

大神帮忙实现用宜搭实现一个功能写一个详细的操作步骤提交表单A前根据表单A上的限制条件C查询另一张表单B的数据D校验这个D是否小于等于0如果D小于等于0系统禁止用户提交并提示“没有了”

更高效准确的数据库内部任务调度实践,阿里云数据库SelectDB 内核 Apache Doris 内置 Job Scheduler 的实现与应用

Apache Doris 2.1 引入了内置的 Job Scheduler,旨在解决依赖外部调度系统的问题,提供秒级精确的定时任务管理。

访问控制(RAM)|云上安全使用AccessKey的最佳实践

集中管控AK/SK的生命周期,可以极大降低AK/SK管理和使用成本,同时通过加密和轮转的方式,保证AK/SK的安全使用,本次分享为您介绍产品原理,以及具体的使用步骤。

手把手教你捏一个自己的Agent

Modelscope AgentFabric是一个基于ModelScope-Agent的交互式智能体应用,用于方便地创建针对各种现实应用量身定制智能体,目前已经在生产级别落地。

Serverless 成本再优化:Knative 支持抢占式实例

Knative 是一款云原生、跨平台的开源 Serverless 应用编排框架,而抢占式实例是公有云中性价比较高的资源。Knative 与抢占式实例的结合可以进一步降低用户资源使用成本。本文介绍如何在

基于Ollama+AnythingLLM轻松打造本地大模型知识库

Ollama是开源工具,简化了在本地运行大型语言模型(ile优化模型运行,支持GPU使用和热加载。它轻量、易用,可在Mac和Linux上通过Docker快速部署。AnythingLLM是Mintple

云效流水线智能排查功能实测:AI赋能DevOps,精准定位与高效修复实战评测

云效持续集成流水线Flow是阿里云提供的企业级CICD工具,免费且注册即用。它具备高可用性、免运维、深度集成阿里云服务、多样化发布策略及丰富的企业级特性。产品亮点包括智能排查功能,能快速定位问题,提高

使用Redis实例搭建网上商城的商品相关性分析程序

本教程将指导您如何快速创建实例并搭建网上商城的商品相关性分析程序。(ApsaraDB for Redis)是兼容开源Redis协议标准的数据库服务,基于双机热备架构及集群架构,可满足高吞吐、低延迟及弹

号外号外!ClickHouse企业版正式商业化啦!

阿里云将于2024年4月23日14:00举办《ClickHouse企业版商业化发布会》直播,探讨阿里云ClickHouse企业版的架构、功能与优势,以及未来一年的产品规划。直播还将分享ClickHou

Llama 3开源!魔搭社区手把手带你推理,部署,微调和评估

Meta发布了 Meta Llama 3系列,是LLama系列开源大型语言模型的下一代。在接下来的几个月,Meta预计将推出新功能、更长的上下文窗口、额外的模型大小和增强的性能,并会分享 Llama

第十三期乘风伯乐奖--寻找百位乘风者伯乐,邀请新博主入驻即可获奖

乘风伯乐奖,面向阿里云开发者社区已入驻乘风者计划的博主(技术/星级/专家),邀请用户入驻乘风者计划即可获得乘风者定制周边等实物奖励。本期面向阿里云开发者社区寻找100位乘风伯乐,邀请人数月度TOP 1

PolarDB +AnalyticDB Zero-ETL :免费同步数据到ADB,享受数据流通新体验

Zero-ETL是阿里云瑶池数据库提供的服务,旨在简化传统ETL流程的复杂性和成本,提高数据实时性。降低数据同步成本,允许用户快速在AnalyticDB中对PolarDB数据进行分析,降低了30%的数

Flink CDC产品常见问题之look up hint 没有生效如何解决

Flink CDC(Change Data Capture)是一个基于Apache Flink的实时数据变更捕获库,用于实现数据库的实时同步和变更流的处理;在本汇总中,我们组织了关于Flink CDC

阿里云数据库内核 Apache Doris 兼容 Presto、Trino、ClickHouse、Hive 等近十种 SQL 方言,助力业务平滑迁移

阿里云数据库 SelectDB 内核 Doris 的 SQL 方言转换工具, Doris SQL Convertor 致力于提供高效、稳定的 SQL 迁移解决方案,满足用户多样化的业务需求。兼容 Pr

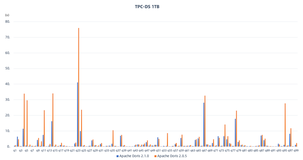

阿里云数据库 SelectDB 内核 Apache Doris 2.1.0 版本发布:开箱盲测性能大幅优化,复杂查询性能提升 100%

亲爱的社区小伙伴们,Apache Doris 2.1.0 版本已于 2024 年 3 月 8 日正式发布,新版本开箱盲测性能大幅优化,在复杂查询性能方面提升100%,新增Arrow Flight接口加

钱大妈生鲜如何利用 CCR 实现 Apache Doris 集群读写分离

钱大妈基于 阿里云 SelectDB 内核 Apache Doris 搭建了实时数仓,为业务提供实时精准分析的数据查询及分析服务。凭借 Apache Doris 强大的性能,钱大妈能够实时监控生鲜产品

Flink CDC在阿里云DataWorks数据集成应用实践

本文整理自阿里云 DataWorks 数据集成团队的高级技术专家 王明亚(云时)老师在 Flink Forward Asia 2023 中数据集成专场的分享。

亮数据:数据采集行业痛点的利器

在数据驱动的时代,企业需高效采集大量数据以作出明智决策,但面临IP限制、验证码识别和效率低下的挑战。BrightData应运而生,提供丰富的代理IP资源、高匿名性和稳定性保障,以及智能IP更换策略,有

一键开启 GPU 闲置模式,基于函数计算低成本部署 Google Gemma 模型服务

本文介绍如何使用函数计算 GPU 实例闲置模式低成本、快速的部署 Google Gemma 模型服务。

Serverless 应用引擎常见问题之改配置变慢如何解决

Serverless 应用引擎(Serverless Application Engine, SAE)是一种完全托管的应用平台,它允许开发者无需管理服务器即可构建和部署应用。以下是Serverless

Serverless 应用引擎常见问题之做的web服务计费如何解决

Serverless 应用引擎(Serverless Application Engine, SAE)是一种完全托管的应用平台,它允许开发者无需管理服务器即可构建和部署应用。以下是Serverless

「我在淘天做技术」迈步从头越-阿里妈妈广告智能决策技术的演进之路

随着智能化营销产品和机器学习的发展,阿里妈妈将深度学习和强化学习等AI技术越来越多地应用到广告智能决策领域。本文将以阿里妈妈广告智能决策技术的演进为例,分享我们工作和思考。

Docker从入门到精通:Docker 容器数据卷详解

Docker 数据卷是持久化容器数据的关键机制,允许跨容器或主机共享,即使容器删除数据仍保留。创建数据卷可通过命令行或容器启动时指定,挂载到容器目录以读写。使用 `docker volume` 命令可

构建高性能微服务架构:后端开发的终极指南

【4月更文挑战第24天】 在当今快速迭代和高并发的互联网环境中,构建一个高性能、可扩展且易于维护的后端系统显得至关重要。微服务架构作为解决复杂系统问题的有效方法,已经成为众多企业的首选架构模式。本文将

构筑未来:云原生架构在企业数字化转型中的关键作用

【4月更文挑战第24天】 随着企业加速其数字化进程,云原生技术已逐渐成为推动创新与维持竞争力的驱动力。本文将探讨云原生架构的核心概念、实施策略以及它如何助力企业在不断变化的市场环境中实现敏捷性和弹性。

在视觉智能平台中直接用人脸库的人脸图片去识别对比 1:n 但是识别不到这个图片的结果怎么办?

在视觉智能平台中直接用人脸库的人脸图片去识别对比 1:n 但是识别不到这个图片的结果怎么办?RequestId: 296C72C8-0319-59DE-B942-C6342423B854

npm命令完整使用指南

本文介绍了npm命令的使用,包括安装配置、镜像源设置、初始化配置文件和下载模块。在安装Node.js后,npm也随之配置好,可通过`npm -v`检查版本。更新npm使用`npm install np

[AI Microsoft VASA-1] 以音频驱动的逼真实时生成的对话脸部

微软VASA-1项目通过单张肖像照片和语音音频,生成具有精确唇音同步、栩栩如生的面部行为和自然头部运动的超逼真对话脸部视频。该技术展现了在实时效率、分布外泛化和解耦能力方面的显著优势,并强调了负责任的

![[AI Microsoft VASA-1] 以音频驱动的逼真实时生成的对话脸部](https://ucc.alicdn.com/pic/developer-ecology/tbo73ymmu5nmu_86473176526c42f0b08d58beeec3055d.jpg?x-oss-process=image/resize,h_160,m_lfit)

宜搭中,在表单里复选选项(搭建多选题)如何设置单行文本自动获取“你的答案”所选的选项如“AB”

宜搭中在表单里复选选项搭建多选题如何设置单行文本自动获取“你的答案”所选的选项如“AB”详情看下方图片请老师帮忙解决

CentOS 系统常用命令详解

本文介绍了CentOS中11个常用的命令,包括`ls`(列出文件和目录)、`cd`(切换目录)、`pwd`(显示当前目录)、`mkdir`(创建目录)、`rm`(删除文件/目录)、`cp`(复制文件/

如何在 Windows 上安装 SQL Server,保姆级教程来了!

在Windows上安装SQL Server的详细步骤包括:从官方下载安装程序(如Developer版),选择自定义安装,指定安装位置(非C盘),接受许可条款,选中Microsoft更新,忽略警告,取消

在视觉智能平台中如下问题为什么失败吗,是不是视频太大了?

在视觉智能平台中jobid: 695F74CB-E7F1-5022-A5DE-F46EE1321440 , 能看下这个任务为什么失败吗是不是视频太大了

每天一技:全面了解CC攻击和防范策略

CC攻击是一种模拟真实用户请求,导致服务器资源耗尽的网络攻击。攻击者利用工具生成木马,控制大量“肉鸡”对目标网站发起恶意请求,使服务器CPU过载,网站无法正常服务。特点是请求有效、IP分散、数据包真实

在视觉智能平台中如下问题如何解决?

在视觉智能平台中Caused by: java.lang.NoSuchMethodError: com.aliyun.openplatform20191219.Client.(Lcom/aliyun

CentOS 系统常用命令详解

本文介绍了CentOS中11个常用的命令,包括`ls`(列出文件和目录)、`cd`(切换目录)、`pwd`(显示当前目录)、`mkdir`(创建目录)、`rm`(删除文件或目录)、`cp`(复制文件或

在视觉智能平台中0C0C549F-8664-5963-997D-CB56B4B225DB这个是什么原

在视觉智能平台中0C0C549F-8664-5963-997D-CB56B4B225DB这个是什么原因呢