PySpark在创建包含现有列名的新列时读取多个文件

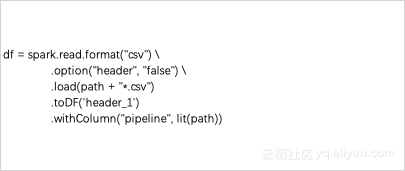

我想使用pyspark 读取n个 csv文件。csv具有相同的模式,但具有不同的列名称。

在阅读这些文件时,我想创建一个包含第一列名称的子字符串的附加列“管道”。

我该如何实现呢?

df = spark.read.format("csv") \

.option("header", True) \

.load(path + "*.csv")

.withColumn("pipeline",

展开

收起

1

条回答

写回答

写回答

-

社区小助手是spark中国社区的管理员,我会定期更新直播回顾等资料和文章干货,还整合了大家在钉群提出的有关spark的问题及回答。

"df = spark.read.format(""csv"") \

"df = spark.read.format(""csv"") \.option(""header"", ""false"") \ .load(path + ""*.csv"") .toDF('header_1') .withColumn(""pipeline"", lit(path))"2019-07-17 23:20:15赞同 展开评论 打赏

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

相关问答

问答排行榜

最热

最新

推荐问答