我们在进行大数据开发过程中,会遇到各种问题,本文将定期收集整理一些在使用阿里云数加 大数据开发套件 过程中遇到的常见问题,供大家参考~

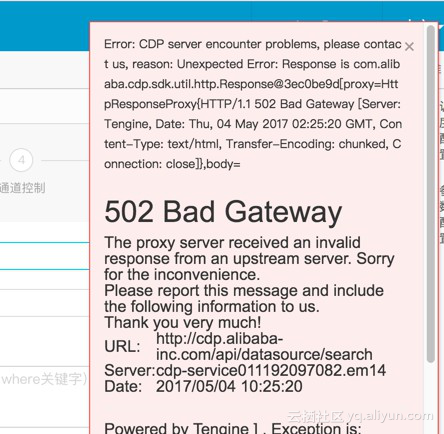

Q: 配置数据同步任务,在选择数据源时,出现下图中的错误,该怎么办?

A: 建议您刷新页面,清空缓存,重新登录。

Q:数据同步时,如何进行增量同步?

A: 具体操作可参考 数据增量同步 文档 。

Q:新增数据源时,RDS 数据源测试连通性不通怎么办?

A:当 RDS 数据源测试连通性不通时,需要到自己的 RDS 上添加数据同步机器 IP 白名单:

10.152.69.0/24,10.153.136.0/24,10.143.32.0/24,120.27.160.26,10.46.67.156,120.27.160.81,10.46.64.81,121.43.110.160,10.117.39.238,121.43.112.137,10.117.28.203,118.178.84.74,10.27.63.41,118.178.56.228,10.27.63.60,118.178.59.233,10.27.63.38,118.178.142.154,10.27.63.15,100.64.0.0/8

注意:若使用自定义资源组调度 RDS 的数据同步任务,必须把自定义资源组的机器 IP 也加到 RDS 的白名单中 ,同时要确保以下问题正常:

- 网络:确保网络和端口之间是能够联通,网络连接失败,可以再检查一下 ECS 的防火墙以及安全组设置;

- 确保添加的信息正确:用户名密码jdbcUrl 中的 IP 地址和端口必须确保正确;

- 确保自建的数据库涉及的安全访问限制,权限的限制和能否远程登录的情况;

- 在 VPC 的环境下购买的 ECS 只能用脚本模式运行任务,在添加数据源时测试连通性不能成功 。购买 ECS 可以添加自定义资源,将同步任务下发到相应的资源组运行 。

Q. 配置数据同步任务时,到字段映射步骤时页面一直处于跳转状态?

A. 为了防止缓存问题导致使用异常,请先清理缓存,若依旧有误,请确保数据源存在并有效。

Q. 为什么在浏览器和版本都正确的情况下,进入数据集成总是空白页?

A. 查看是否绑定了HOST。

Q. MaxCompute的数据怎么同步到MySql?

A. 可以使用大数据开发套件中的数据集成功能,请参见: 创建同步任务导出结果。

Q. 数据同步时报错,日志提示: Code:[Framework-13], Description:[DataX插件运行时出错, 具体原因请参看DataX运行结束时的错误诊断信息 .]. - java.lang.OutOfMemoryError: Java heap space at java.util.Arrays.copyOf(Arrays.java:3236)

A. 由于您的任务数据量稍大并且同步的速度太快,一般是接近10M每秒,导致调度服务器内存溢出报错。您可以通过以下几种方法进行调错:

- 在大数据开发套件->数据集成-查看数据同步任务的速度情况,一般出现内存溢出都是速度设置过大导致的,这里建议尝试把同步速度调小;

- 在大数据开发套件->数据开发-查看数据同步任务的同步速度是否太大,检查该调度资源是否有其他大的任务或有比较多的任务在执行;

- 先尝试把同步速度调小,查看其他任务执行状态,资源比较多的时候执行同步;

- 将数据任务分时间段来执行,不要在同一时间执行,另外同步速度不宜很大。如果有需求,可以考虑增加调度服务器的配置或者实例。

Q. MaxCompute 可以通过同步任务回流数据到用户自建的 mysql(非阿里云 mysql)吗?

A. 可以

Q. 对于大量数据,可以配置很长的任务间隔吗?比如千万级的数据,是否可以实现秒级同步?

A. 暂时不支持, 目前支持的最小的任务间隔是 5 分钟同步一次。

Q. 配置 MaxCompute 数据同步时,在脚本开发中,是否可以设置函数?

A. 目前不可以。

Q. maxcompute 数据同步到 sql sever 时, 是否可以留下原来的数据,没有清除脏数据?

A. 需要在配置数据同步任务时,配置 “导入前准备语句”。

Q. RDS 的 Mysql 数据库数据同步到 MaxCompute,源库中的 varbinary 字段在做数据同步时如何转化为 string 类型?

A. RDS _Mysql 的 varbinary 类型不能直接同步到 MaxCompute 中转化为 string 类型,但可以先将 varbinary 转化成 string 类型后再同步到 MaxCompute。