我觉得很荣幸来这样一个场合跟大家交流一些我们做的工作。我觉得在李院士后面讲是压力很大的事,我感觉像他做那个无人驾驶车,150公里的速度在我脑子里面来回的开。今天讲的题目,因为下午我拿到题目说要跟深度学习有关,我也想介绍一下IBM在这方面的工作。这个题目的内容叫脑启发计算。其实我觉得我们中国的文字很有意思,我们在翻译的时候,我们说computer翻译成计算机是很准确的,其实这个词进入中国的时候我们就对它就很强的工作,我们希望它跟脑一样,通过脑的工作原理我们从当中能提取什么内容。

那人工智能60年,实际上计算机发展也差不多是这样的时候。我们都知道计算机的整个架构,计算机是怎么工作的?是基于一种很简单的架构,输入输出,但最重要的一点是CPU和内存,这两点之间数据的交换。我们真正在实现这个架构的时候会构建很多的总线,比如控制的总线、地址的总线、数据的总线,最基本的原理就是希望内存和CPU之间有很好的交换。就是由于这样的构成造成了很大的瓶颈,我们知道深度学习有很多好的突破,今天早上我们也看到了他们做的显卡。为什么在深度学习里需要CPU的计算会有问题呢?就是因为总线的架构会阻碍内存和CPU之间信息的交流。不管你内存加多大,之间就像一个单路的信息通道。

我们再看脑的工作方式,脑是一个很有意思的构建。生物体在一开始的时候是没有大脑的,然后慢慢在一些神经的末端会有膨大的部分,然后再慢慢形成脑。我们现在对脑的解剖学上面已经有了很好的认识,这里面有两张图,是解剖图。脑里面最基本的单元就是神经元,神经元之间通过突触联接。我们想讲的是脑做的推理或者计算,都基于这样的构造。首先讲人的大脑有1000亿个神经元,也就是说我们现在一般的机器最多16核,但是我们的脑子里面是有1000亿个神经元的计算。第二点就是它是非常强的连接关系,有100万亿个突触的连接,平均每个神经元之间有1000个连接。这种连接造成了后面会讲的,比如说我们发现脑的频率或者是主频并不高,大约是10赫兹到100赫兹之间,但它能做很复杂的运算,也就是因为这样的连接。假定是1000个连接的话,两层就可以做到一兆,三层就可以做到1G。脑的工作是非常低频率的,而且是一个非常非常充分连接的计算系统。

我们另外看到脑里的信号,连接的速度也不是很快的。我们有些实验,大家也可以自己做一下实验。脑的信号在神经里面的传输速度大概是每秒钟1米到100米,你怎么来看呢?比如说你弯一下手指头,你再试一下脚指头,大概弯手指头的速度可以达到脚指头频率的两倍,原因很简单,大脑到手的距离是到脚距离的一半。

还有一个特征我们没有看到,就是脑是非常非常低功耗的系统,人大概是60瓦的功耗,脑是占据了人三分之一的能耗的销量,虽然脑的重量没有那么大,但是消耗了人体的三分之一的能量。脑也只有20瓦的功能,有时候我们在讲现在的人机大战,他对面的选手就是早晨起来喝牛奶,吃个面包就可以比赛了。这个角度来讲脑是非常非常有效率的机构。我们总结起来看一下,就是说实际上脑的主频并不快,达到就是10到100赫兹,信号传输的速度也不快,但它是高并发的。

另外一点,IBM的研究院做过的研究,这是猕猴的大脑,脑里面有很多的分层,但其实你会发现这些脑的各个功能分区之间也存在一些长线连接。举个例子说,你负责视觉的部分的大脑皮层和你负责听觉的部分也有连接在这边发生。我们对应现在的神经元网络构建分层的,早上微软的同事在介绍他们的工作,构建了深度学习网络跨层之间的反馈,这个方式其实跟脑的这种工作机理是有借鉴,他是非常非常充分连接而且有一些长线连接的构造。

总结下来,我们再看看今天做的这些深度学习的算法,其实本质上是用这种神经元的方式,我们叫做一个人工的神经元,实际上对大脑的神经元做了非常非常多的简化。刚刚如果大家看那张图,里面有很多的细节,里面做的不是一个简单的运算,也不是简单的电信号,在突触上面实际上做的是物质的传输,而且分很多种,有的物质传输是为它的信号增强,有的是为它的信号的抑制的作用。所以脑子里面发生了很多的化学或者生物变化,而我们现在这种人工的神经元实际上是很简单的物理模型,基本上可以看成说一个电线接个电灯泡的过程。即便是这样的过程当我们把层数变得很深的时候,当我们用大数据的办法用训练的时候,它仍然给我们带来很好的结果。过去几年在模式识别的问题上,这种深度学习的技术得到了很好的应用,仿造大脑构建这样一个简化的物理结构,当这个结构足够大的时候,在图像、视频,语音中取得了突破性的结果,我们也看到一些用循环神经元网络做一些在自然语言理解上,做机器翻译方面都有好的结果,当然还有最近的围棋。

我们把这个稍微总结一下,看了一下为什么讲现在的计算机或者计算体系架构跟脑还有很大的差异呢?计算机我们讲是摩尔定律,让计算机越来越强大。事实上如果你仔细想摩尔定律并没有让计算机的计算变得越来越快,是什么让计算机越来越快呢?是因为计算机的主频越来越高。这个图上从4004到最早的CPU,主频大概是10兆赫,现在可能到G,从左上角这张图来看,在早期1996年开始计算机的主频是一个线性的变化,往上在走,所以越来越快。但是我们可以看到大概在2004年到2005年的时候,计算机的主频出现了停滞,这是什么造成的呢?因为摩尔定律上芯片越来越小,那同时计算机的主频越来越快。造成了这个散热成了很大的问题,到2004年和2005年的时候,实际上在每平方厘米的功耗大概已经到了100瓦。我记得我们小时候家里头烤火的炉子,可能也就是1000瓦,面积有几百平方厘米,比CPU的功耗密度低一个数量级。有这么大功耗造成你的计算机真正在实现的时候,没法让主频越来越高。所以从那年开始以后,计算机开始在其他方面做得更快,把它变得更多核,所以多核是让计算机变得越来越多的一种方式。但是我们也有很多做计算的同事也说,不管你有多少核,总是把一个核累死。很多的计算和调度方面都会有问题。

所以从整个的发展趋势来看,实际上我们的计算和脑的结构是完全不一样的。因为我们如果把整个计算机发展,比如说按照主频,安全功耗画一条曲线的话,我们可以看到事实上整个计算机的芯片上的发展,实际上是在往右上角走的。从最早的80、86的CPU,到IBM和PowerCPU,只是增长率越走越慢,由于功耗的原因。

但是我们反看大脑,大脑是左下角,主频是10到100赫兹,主频是毫瓦的区间。可以讲现有的计算机体系架构不是很好的能帮助像脑一样的工作模式。

我们总结一下,可以看到其实计算机基于冯诺伊曼的架构,里面计算的单元、存储的单元、通信的单元是彼此分离的。在我们的大脑当中这几块内容是集成在一起的,因为我们很难去想象到大脑中哪一部分是存储器,哪一部分是计算器,然后哪一部分是做数据传输的。另外一点是说整个计算机是主频率很高,功耗非常高。脑是主频很低,功耗也非常低的。特别有一点,我们每一个神经元或者每一个计算单元的连接都是上千个连接,这跟我们的计算机里面很不一样。

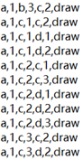

如果从这个角度来讲,从计算机体系架构最底层来看,有没有什么办法让计算机能更像脑这种方式工作。所以IBM这边有一个项目,取了“突触”作为项目的名字。一个很大的目标就是说希望我们让计算机不再像以前那样,是一个高功耗的,希望是一个很低功耗的,同时还可以很容易把这种规模做上去,比如说100个芯片就可以增加100倍的能力。这个项目的宏大目标是希望,因为我们知道人脑大概是1000亿个神经元,猫的大脑约有3亿神经元,当时有这样一个目标,人脑的容积那么大,大概是1升多。我们希望构建一个计算系统,可以在2升的空间里,人工神经元达到猫脑的数量级。这是过去几年的进展,最近可能大家也看到一些新闻,我们也有一些芯片出来,专门做一些跟神经元相关的计算。2011年的时候是256个神经元,前年我们已经能集成到100万个神经元,再一个单芯片上。但是这个单芯片上它的功耗只有70毫瓦,下面有一个图,用红外照相机拍的图,这是芯片真正工作的状态。左半边就是Synapse芯片,70毫瓦跟手机里面的芯片差不多。右边是一个附属的FPGA卡,做数据的输出输入的,红的发亮。这样的一种芯片是可以达到目标。右下角也做了很多的应用尝试,这是模式识别,多类的一个目标检测的系统,当时是这种一块芯片就可以做到实时的模式识别,比如说识别它是车还是人,是自行车还是建筑物的构思。大家可以想象一下,原来我们做这种模式的系统,如果做到实时的话,单CPU是不行的,做不到实时,在图像质量非常高的情况下,Synapse只需要70毫瓦就可以做到实时分析,如果我们用CPU做的话是几百瓦,这是功率上非常大的提升。这个目标做出来之后也基本实现了,我们能够让一个猫脑的计算能力的系统,放再一个大概2升的空间里。因为它功耗非常低,所以也不需要做很好的散热,整个系统可以很高密集的集成。

像这样的芯片技术能带来什么呢?我们也看比如说这种其他公司的同事也在讲AR和VR,这里面有很多新的应用。比如说眼镜上来说,有很多有视觉障碍的人,如果说他弱视或者是看不清楚东西。他戴眼镜有什么好处呢?这个眼镜就会相当于一个摄像头,实时采集周边的信息,做目标识别,告诉他前面有条路,左边有一个屋子,他耳朵上挂了一个耳麦,把图像的信息变成了语音的信息提示她。这样的一个技术是很有用的,因为它很低功耗。我们说手机上也就是几十毫瓦就到顶了,传统的模式识别的算法如果识别的话,可能是百瓦的功耗级别。

还有一个场景是说我们因为是低功耗,比如我们在做一些IOT的场景,因为很多的IOT的场景是森林防火,我们没有办法布一个很复杂的计算设备到远端,你的电和网络铺进去很难。低功耗的设备,本身是我这个设备有一些终端智能,可以做模式识别,比如可以识别周边温度的变化,识别周边环境的变化,可能就用一点点的太阳能就可以支撑他的工作。平时也不需要去用网络连接,当他发现问题的时候,比如说某些地方有异常的温度变化,或者是有些地方有禁区,这时候他做了识别以后把这个信号再传回他的服务器端。这样一个场景的话低功耗也是非常重要的。

其实在这个领域里面仍然有非常非常多的事情要做,因为大脑远比我们现在的计算系统要有效率的多。今年是人工智能的60周年,事实上远在2000多年前古希腊的亚里士多德,他在形式演绎推理上的工作构建了人工智能符号逻辑里面的一些理论基础,,从这个角度来讲人类对于智能的探索已经远远超过60年。智能的本质来源于脑的工作机理,我们对于脑不断的认识、不断的理解,把这些理解变成我们的技术,一点点的用到我们的现实生活当中,这也是我们想讲的脑启发计算,也是IBM认知计算中一个重要的方向。人工智能仍然有很长很远的路要走,所以在座的各位同仁一起把人工智能、认知计算的技术不断向前推进,造福我们每天的生活,衣食住行,谢谢。

本文来源于"中国人工智能学会",原文发表时间""