Flexvolume数据卷采集Metric说明

Flexvolume插件采集Metric数据依赖于Kubernetes的支持,有以下注意事项:

Kubernetes从1.13版本开始支持Flexvolume数据卷的监控数据采集;实现详情;阿里云ACK不支持Kubernetes 1.13版本,所以需要您的Kubernetes集群版本大于等于1.14;

Flexvolume要求版本大于等于v1.14.6.15-8d3b7e7-aliyun;

阿里云Flexvolume目前支持云盘卷的Metric采集;

Metric采集只支持PV、PVC数据卷,通过InlineVolume配置的数据卷不支持采集;

数据卷Metric采集默认没有打开,需要按照下面方法进行配置:

查看云盘卷Metric

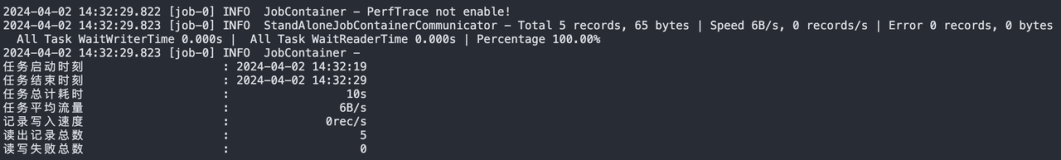

在集群、Flexvolume版本满足上述要求的情况下,通过下面命令启动云盘数据卷采集功能:

# kubectl set env ds/flexvolume ENABLE_METRICS_DISK=true -nkube-system

在上述配置前挂载的云盘卷Metric采集不到,需要重新挂载(重启Pod);

部署Pod挂载云盘数据卷,假设对应的PVC名为:pvc-disk;在节点上查看挂载情况:

# mount | grep disk

/dev/vdb on /var/lib/kubelet/plugins/kubernetes.io/flexvolume/alicloud/disk/mounts/d-wz97va7lc72bqxunllta type ext4 (rw,relatime,data=ordered)

/dev/vdb on /var/lib/kubelet/pods/7c00167c-f612-11e9-9073-00163e087786/volumes/alicloud~disk/d-wz97va7lc72bqxunllta type ext4 (rw,relatime,data=ordered)在云盘挂载节点上,通过下面命令可以获取Metric数据统计:

# curl -s localhost:10255/metrics | grep pvc-disk

kubelet_volume_stats_available_bytes{namespace="default",persistentvolumeclaim="pvc-disk"} 2.0940644352e+10

kubelet_volume_stats_capacity_bytes{namespace="default",persistentvolumeclaim="pvc-disk"} 2.1003583488e+10

kubelet_volume_stats_inodes{namespace="default",persistentvolumeclaim="pvc-disk"} 1.31072e+06

kubelet_volume_stats_inodes_free{namespace="default",persistentvolumeclaim="pvc-disk"} 1.310709e+06

kubelet_volume_stats_inodes_used{namespace="default",persistentvolumeclaim="pvc-disk"} 11

kubelet_volume_stats_used_bytes{namespace="default",persistentvolumeclaim="pvc-disk"} 4.616192e+07