更多精彩内容参见云栖社区大数据频道https://yq.aliyun.com/big-data;此外,通过Maxcompute及其配套产品,低廉的大数据分析仅需几步,详情访问https://www.aliyun.com/product/odps。

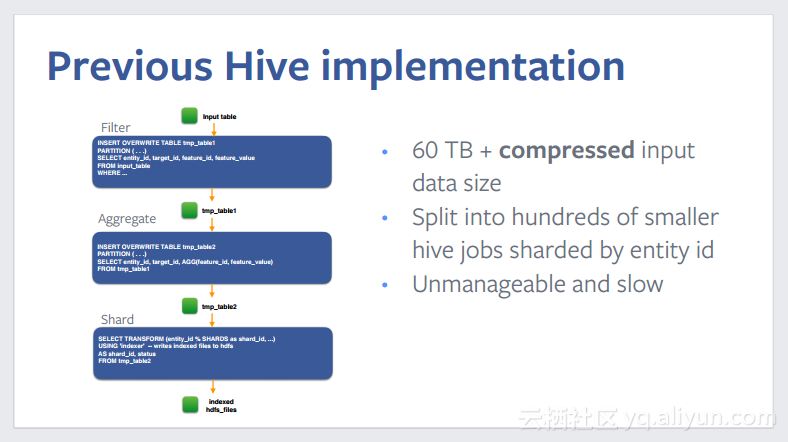

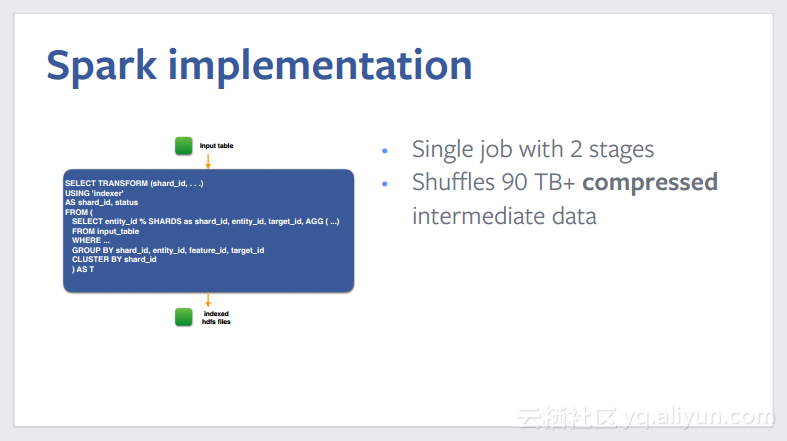

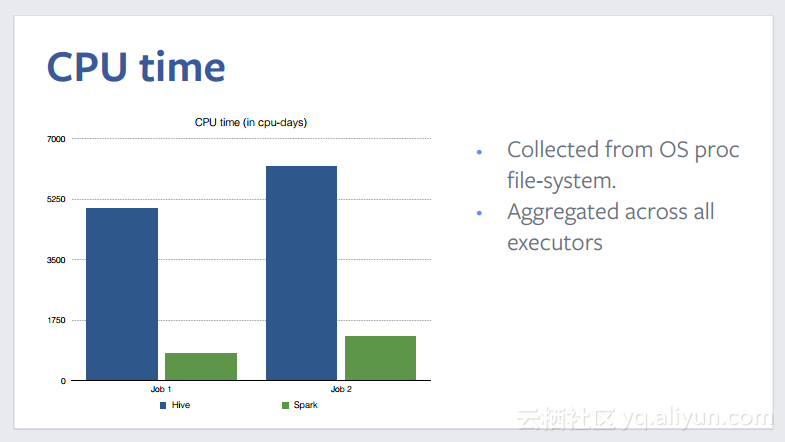

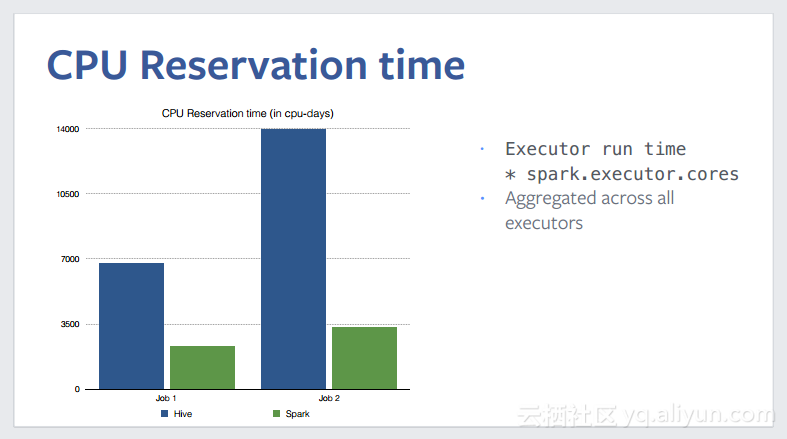

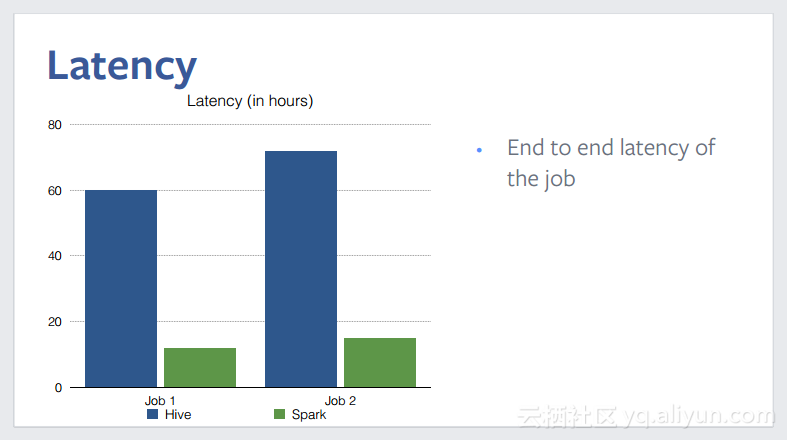

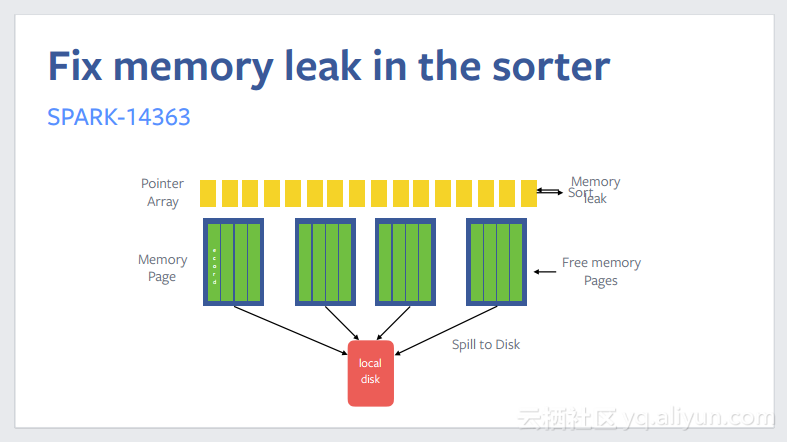

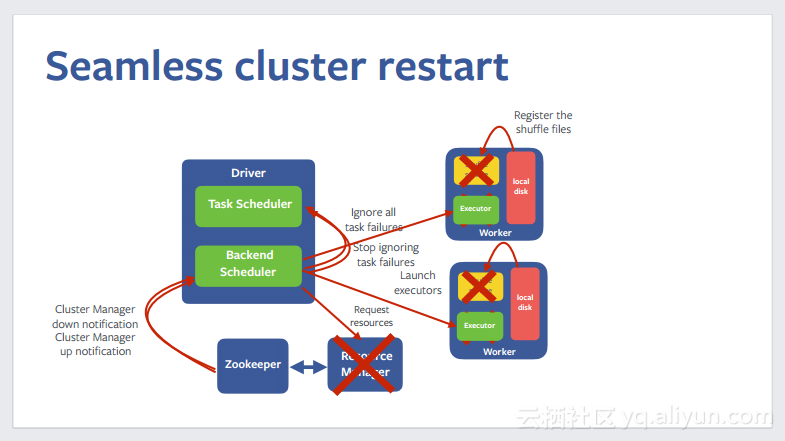

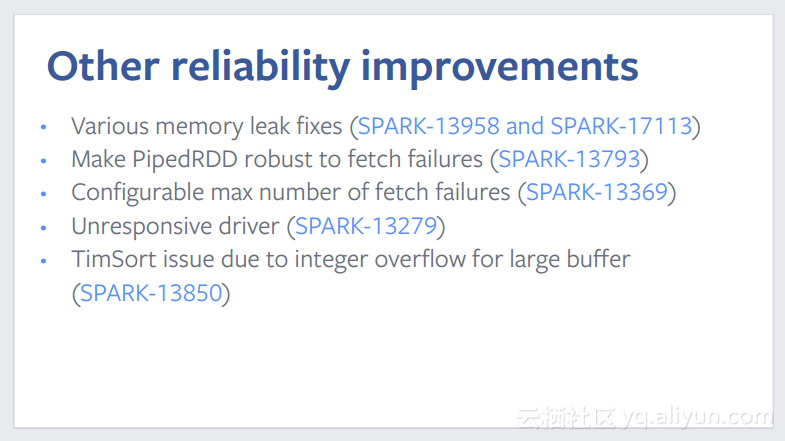

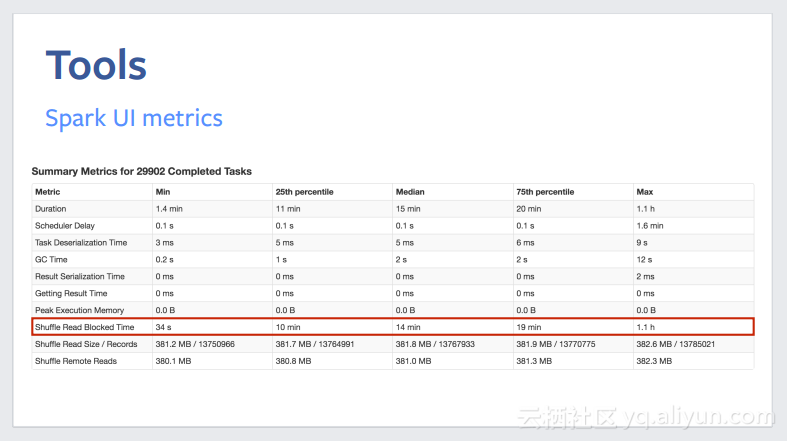

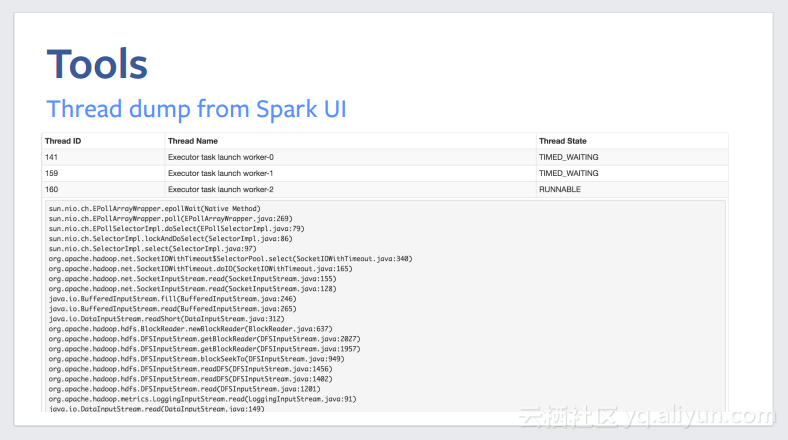

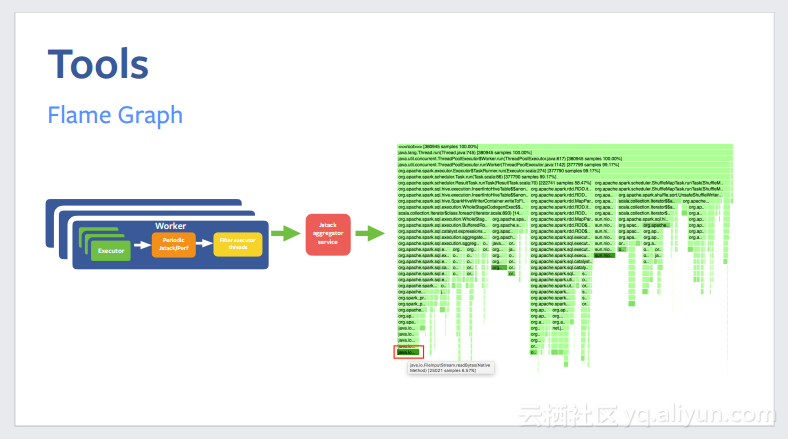

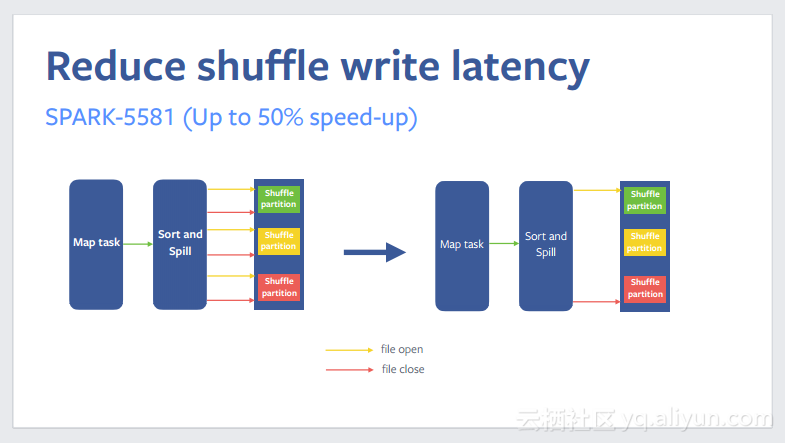

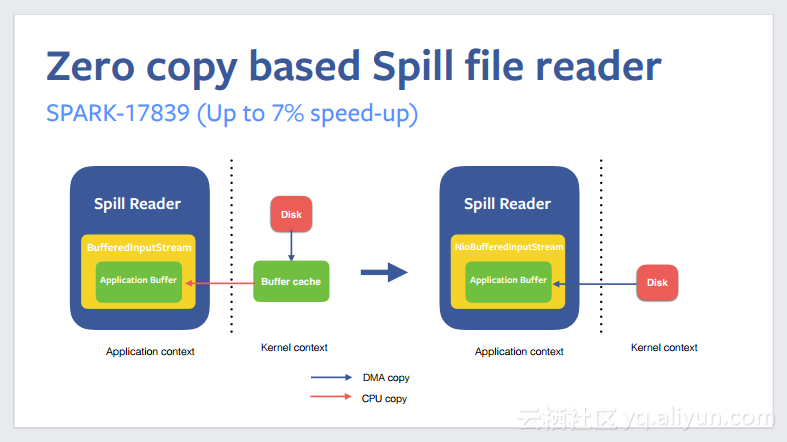

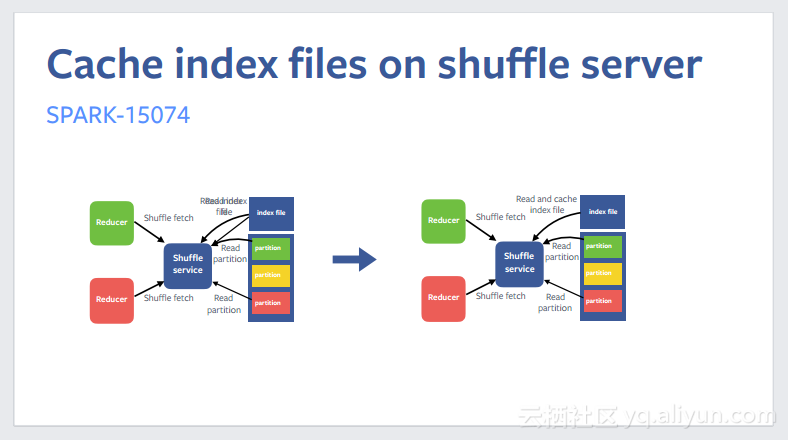

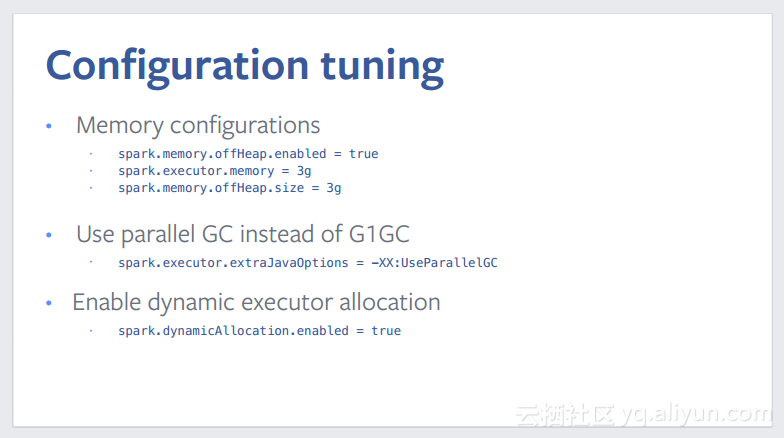

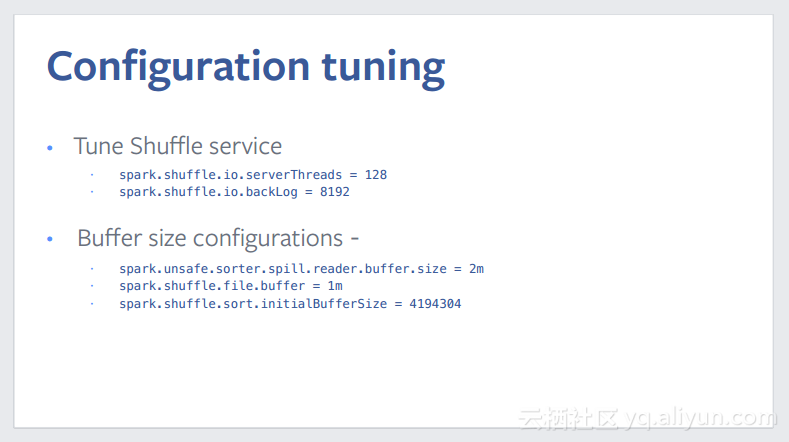

本讲义出自Sital Kedia在Spark Summit EU上的演讲,主要介绍了60 TB+数据规模的Spark产品用例,他在开始时首先介绍了实体排序的用例,然后介绍之前使用Hive进行的实现以及现在使用Spark的实现方式,并对于两种实现方式进行了对比。最后还分享了关于Spark的可靠性、性能的提升技巧以及配置调优技巧。