更多精彩内容参见云栖社区大数据频道https://yq.aliyun.com/big-data;此外,通过Maxcompute及其配套产品,低廉的大数据分析仅需几步,详情访问https://www.aliyun.com/product/odps。

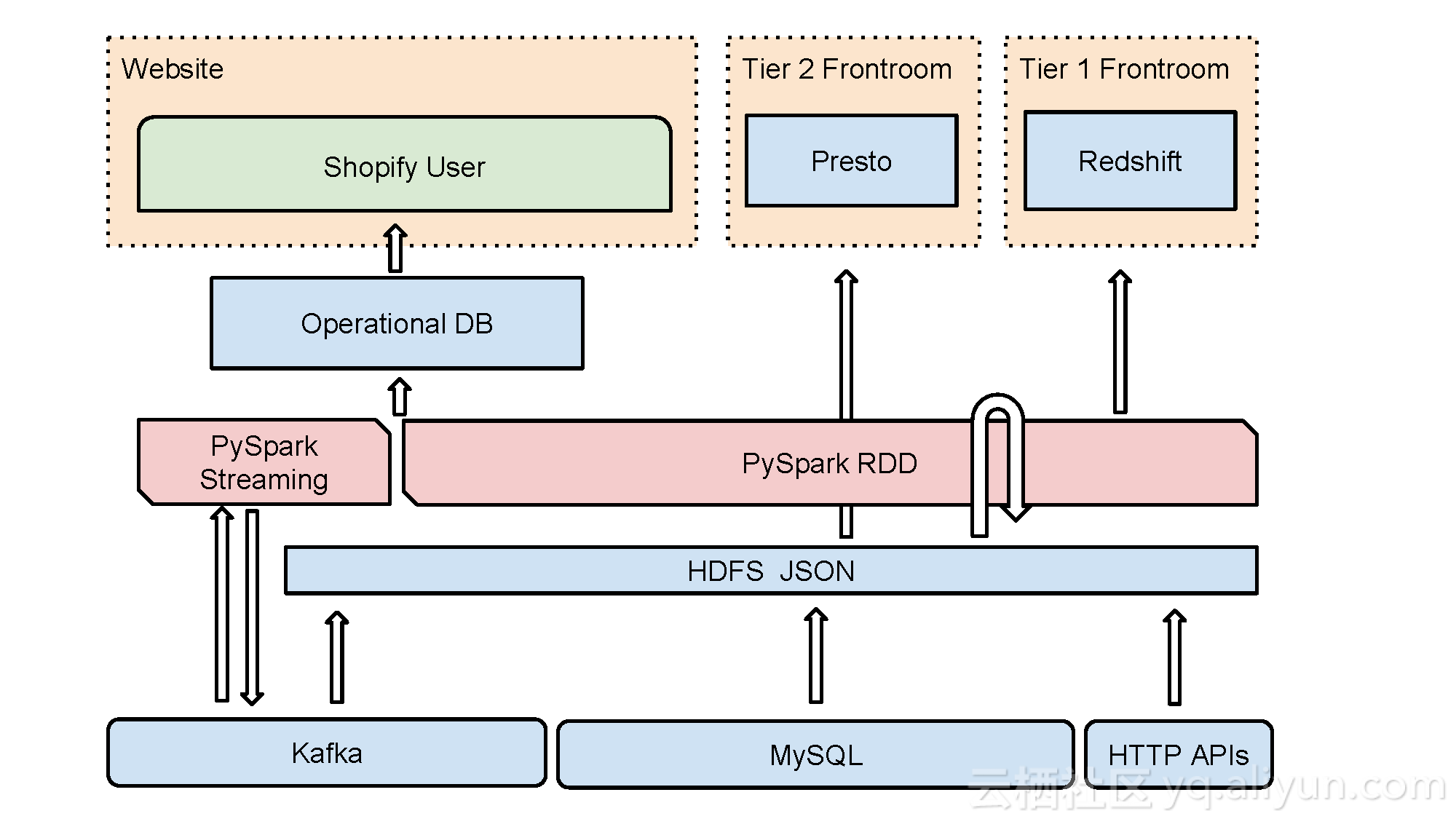

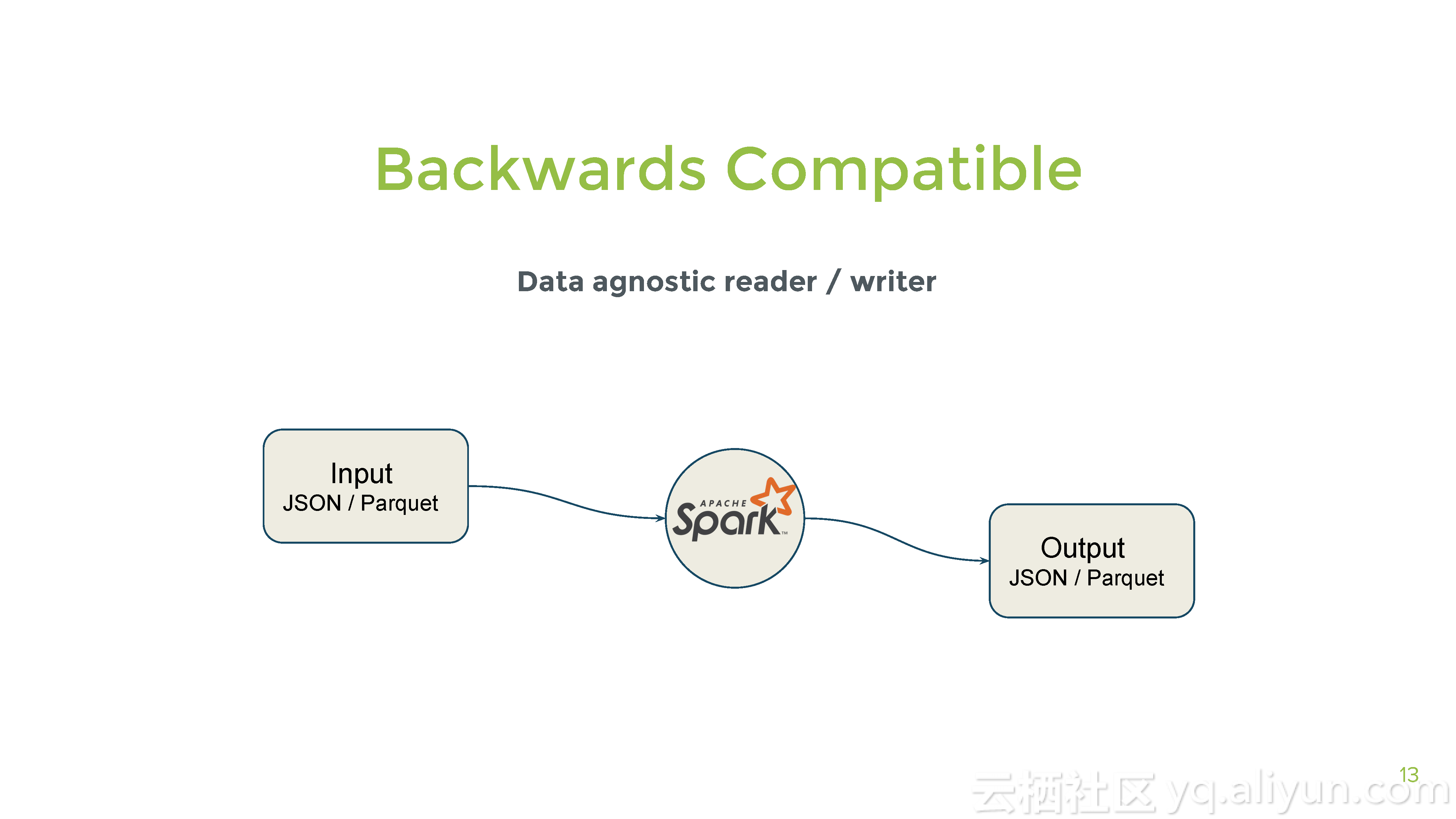

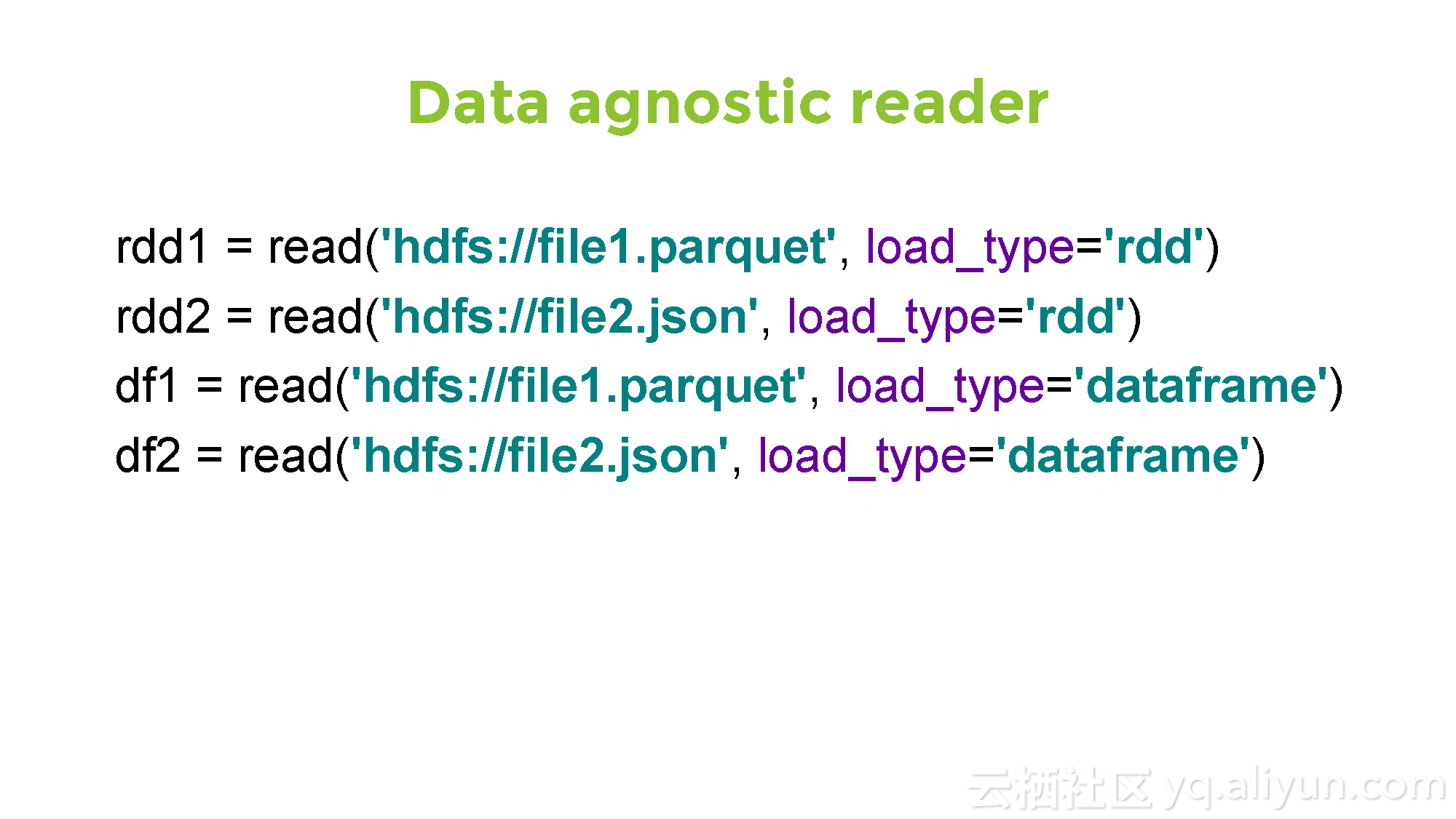

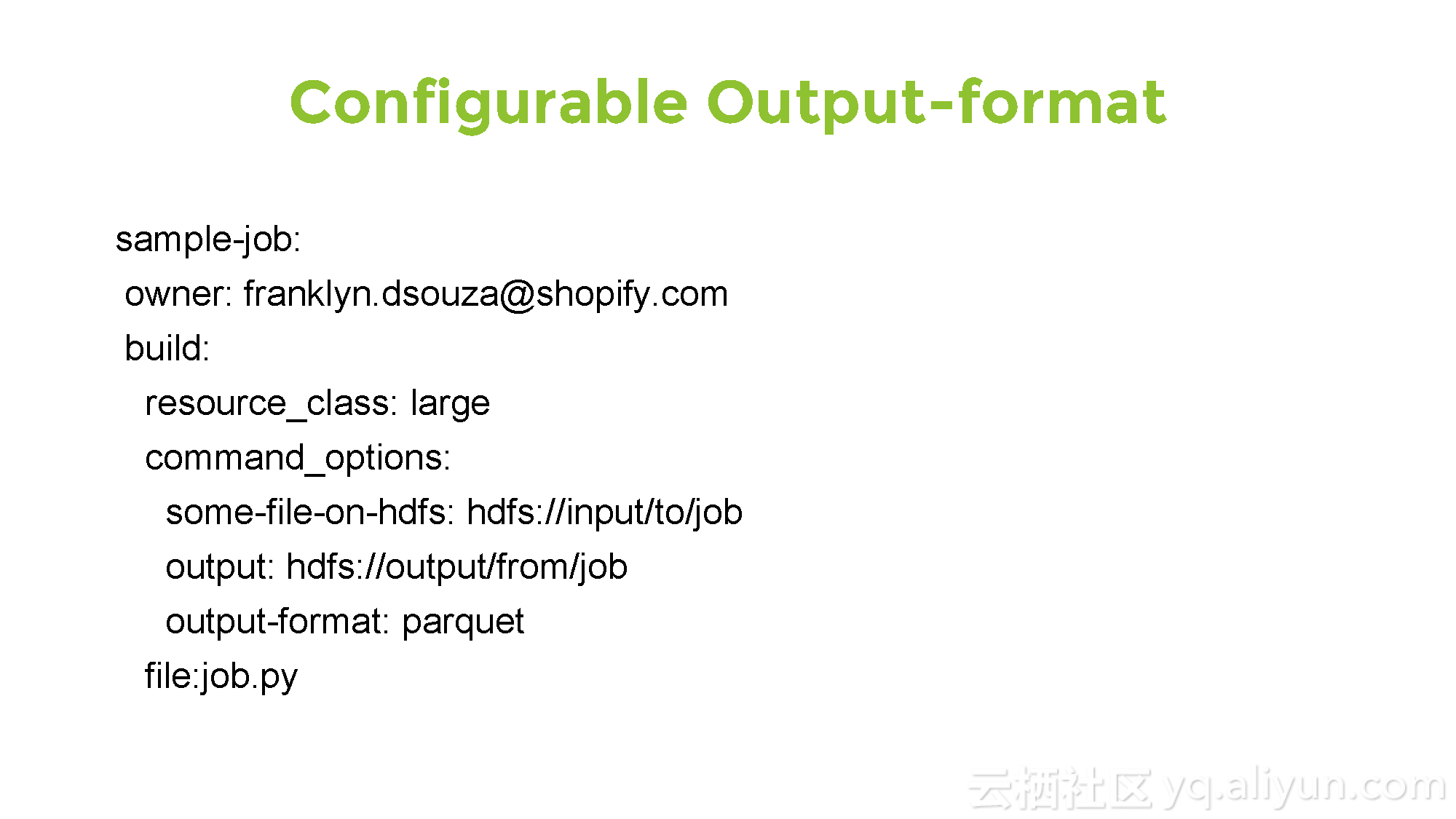

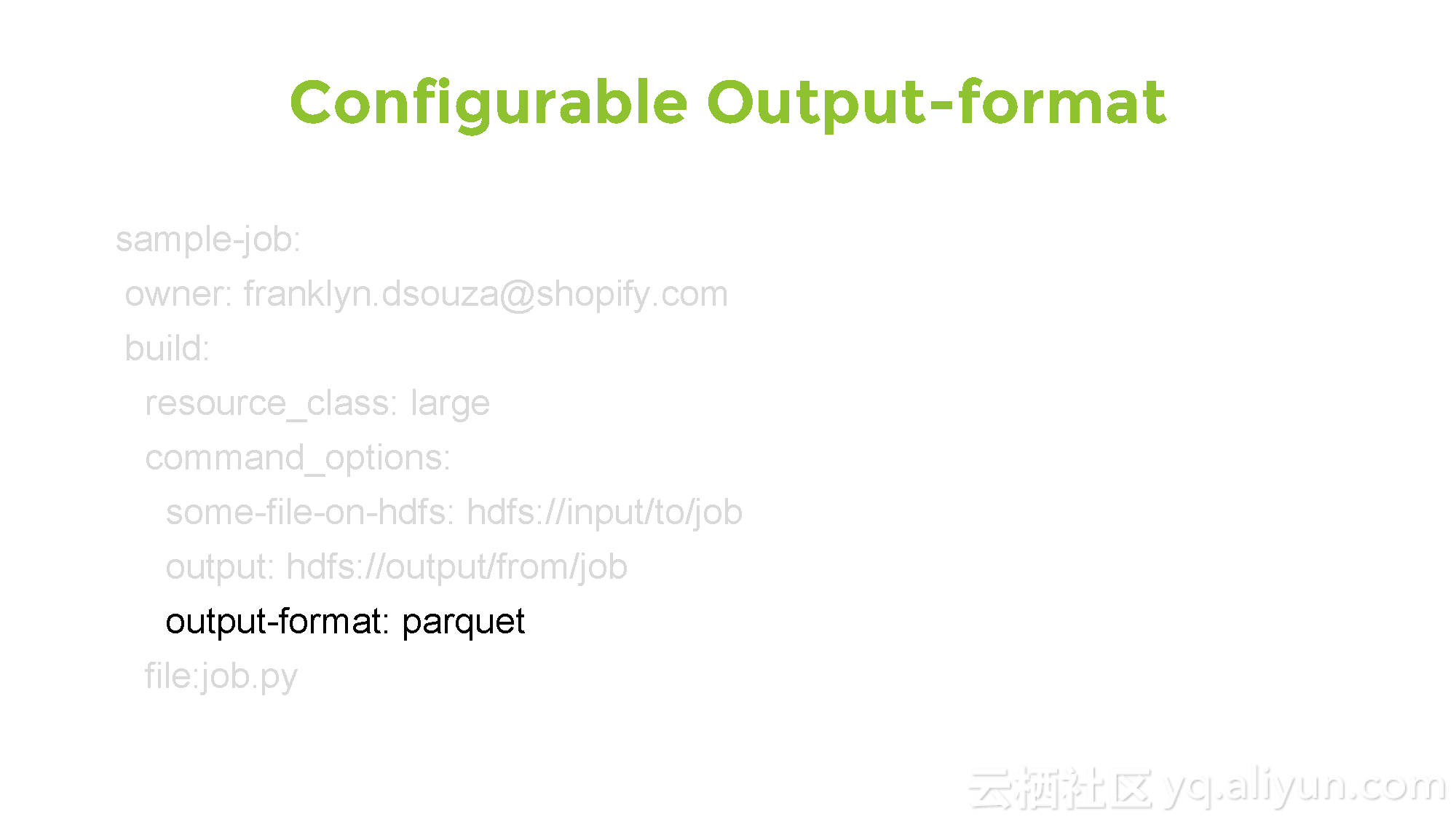

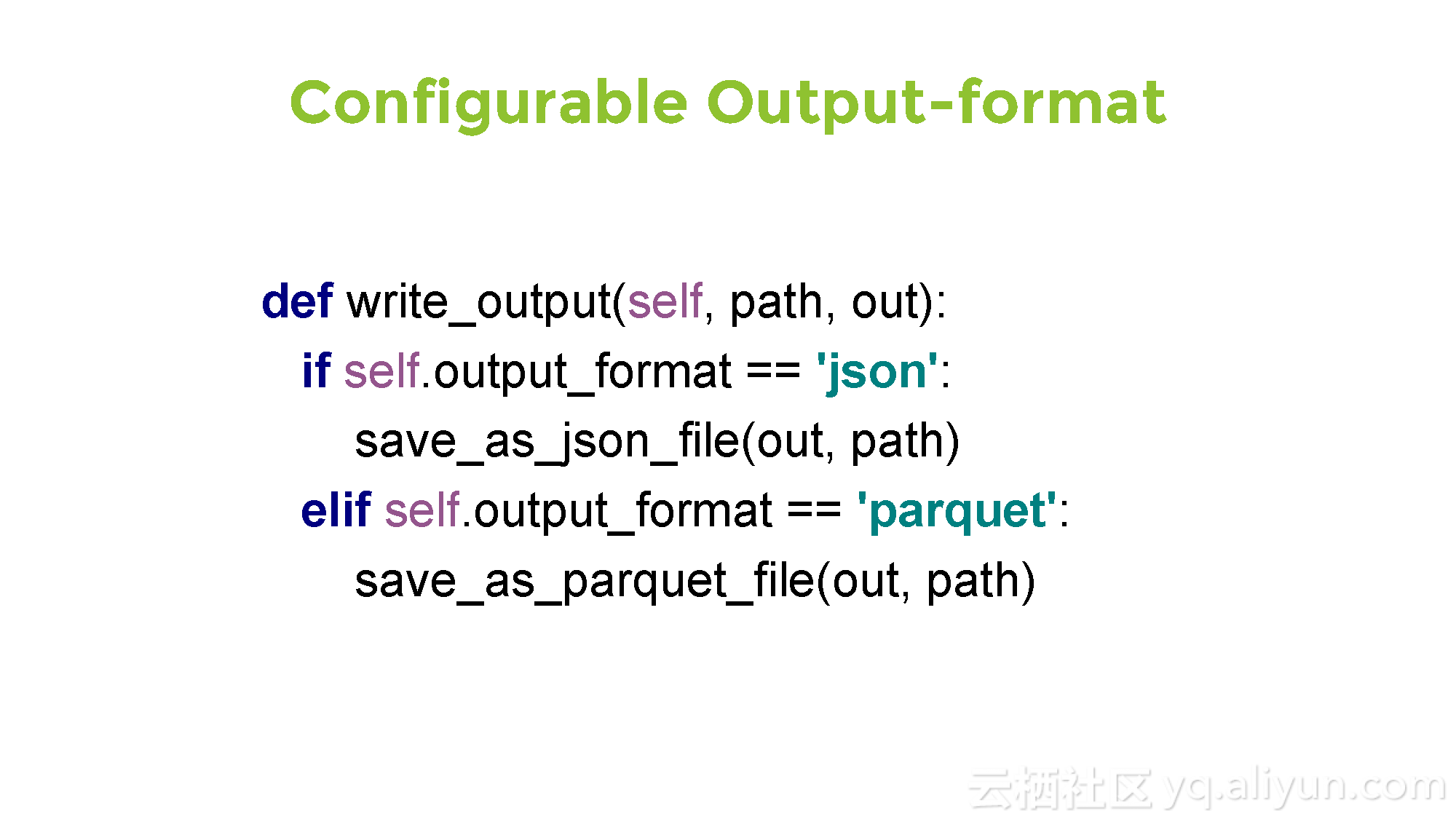

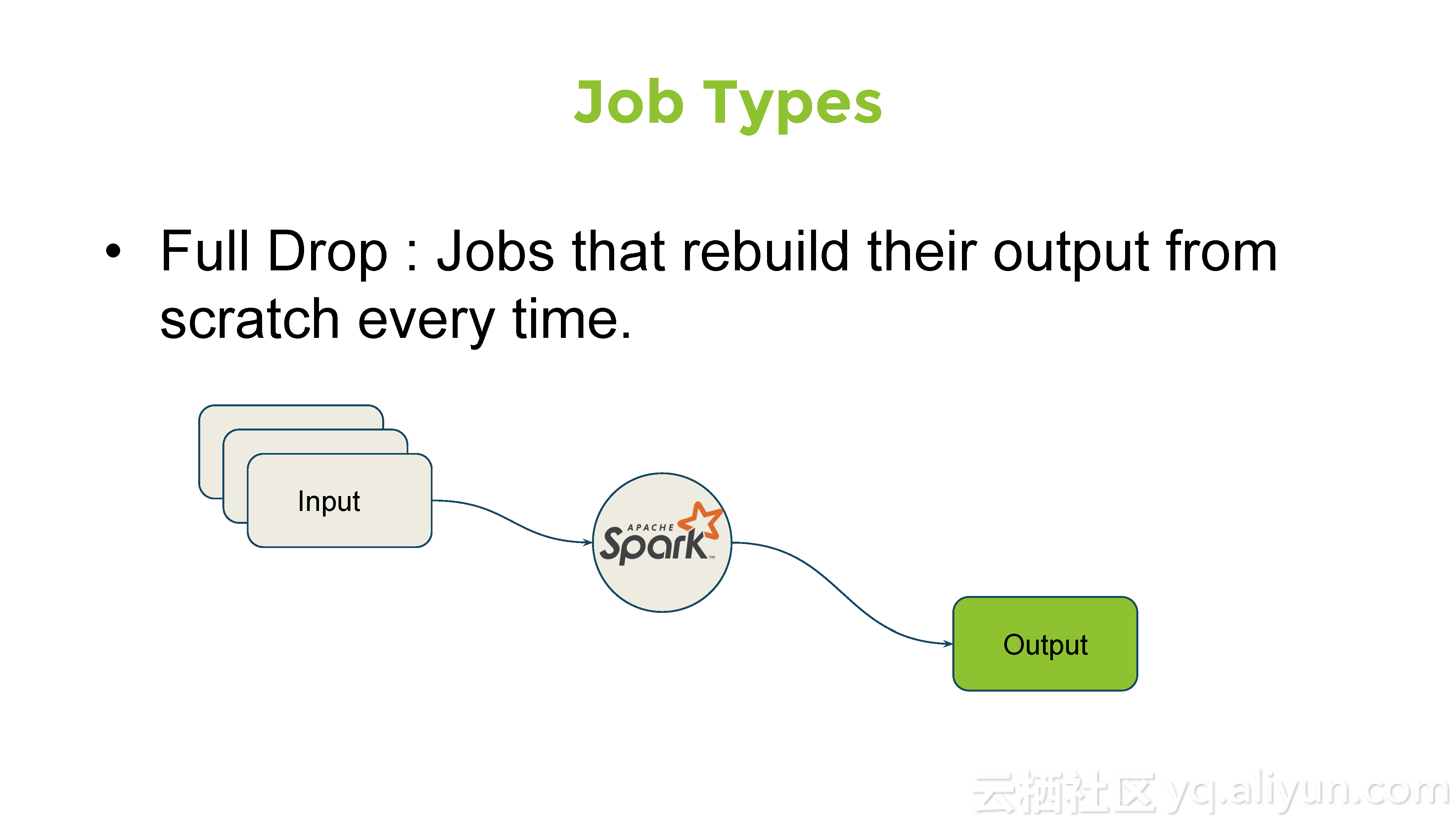

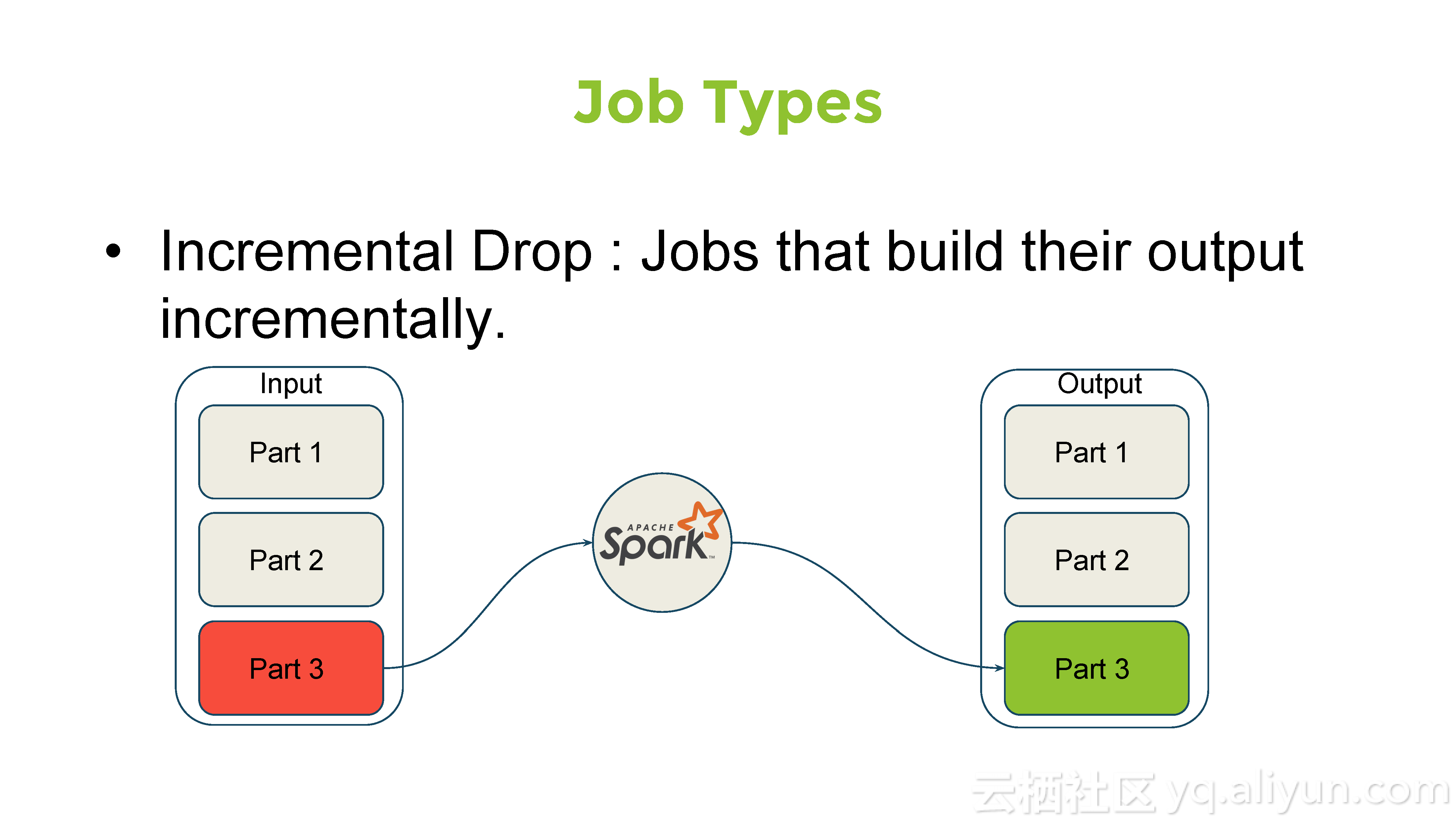

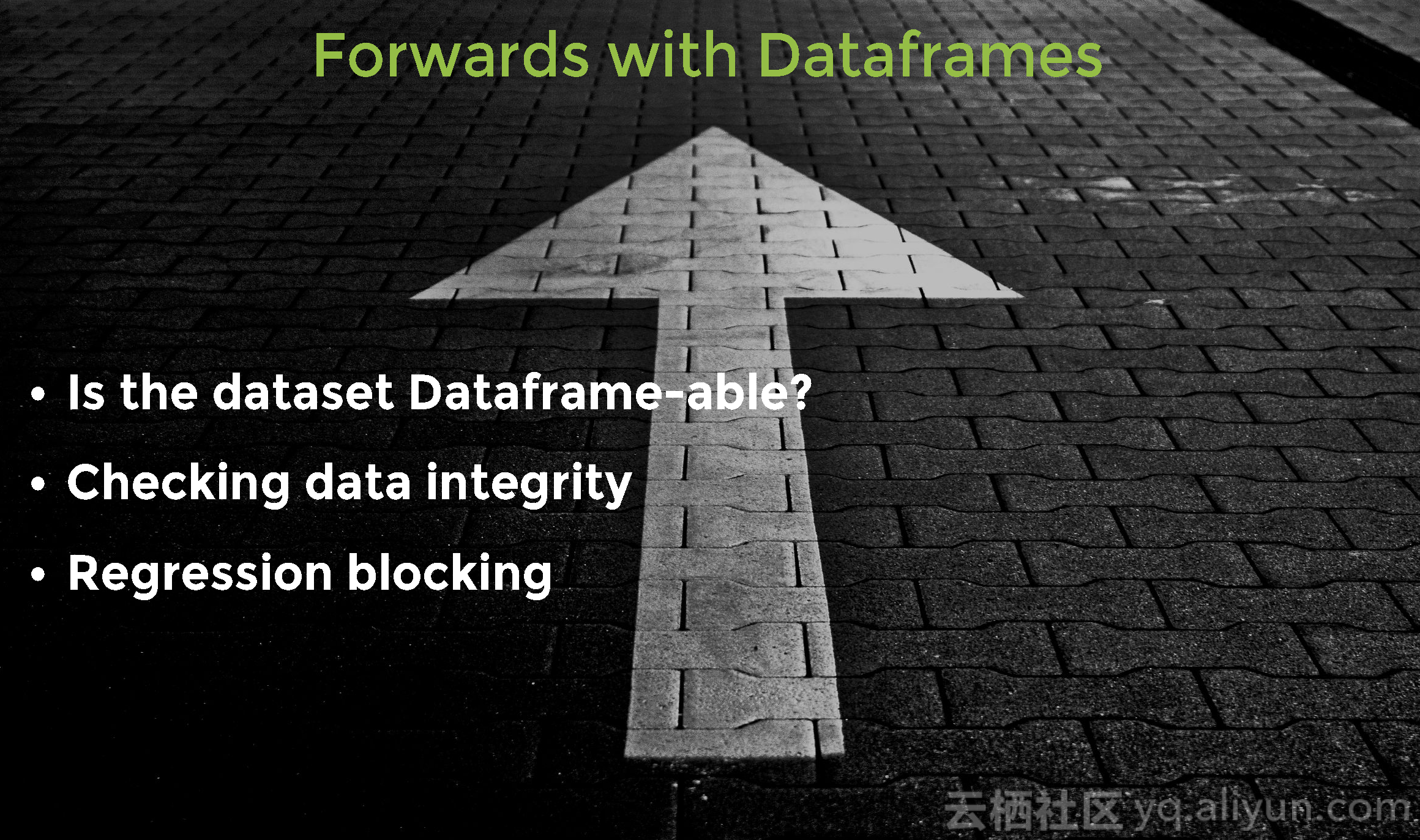

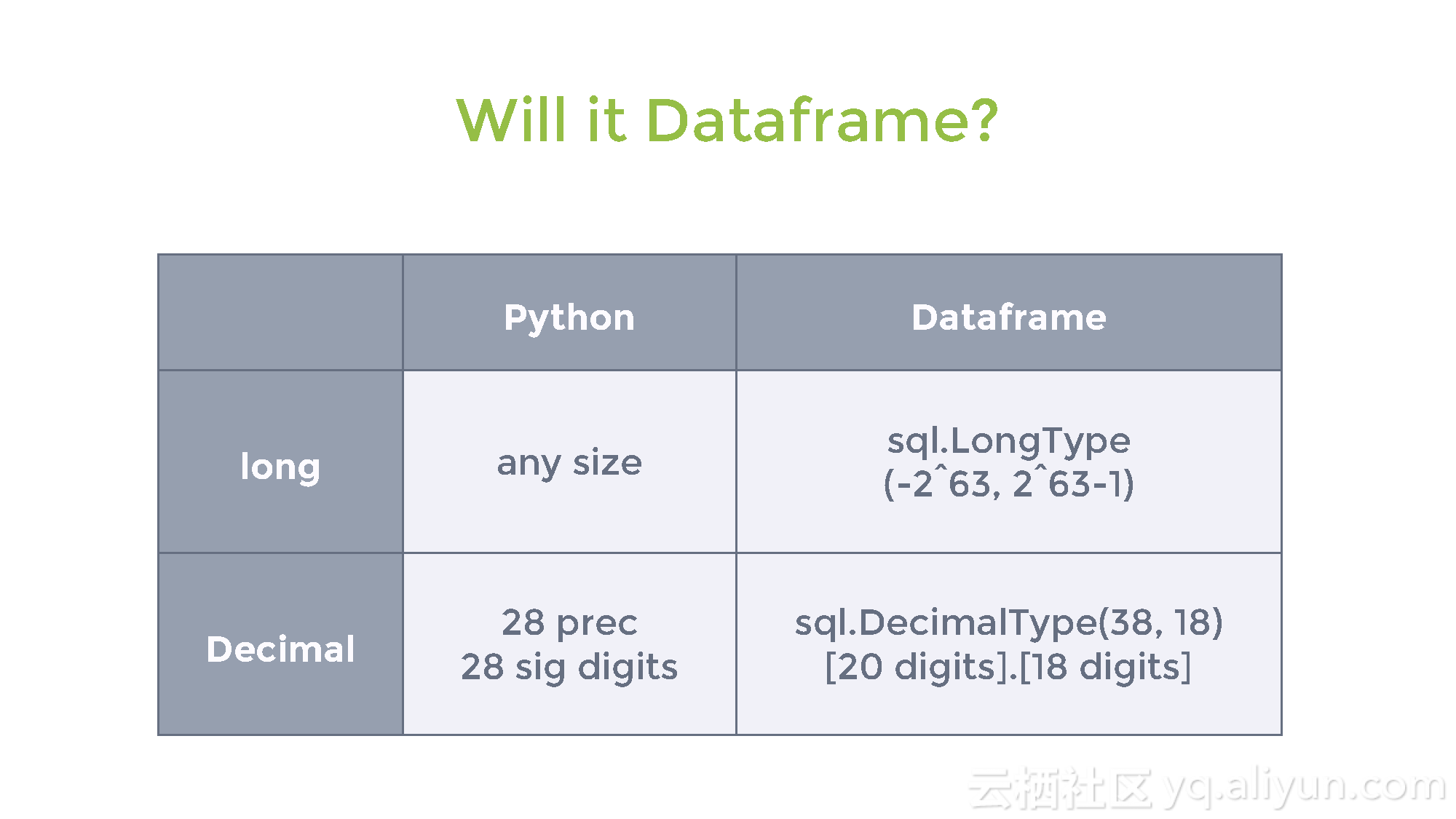

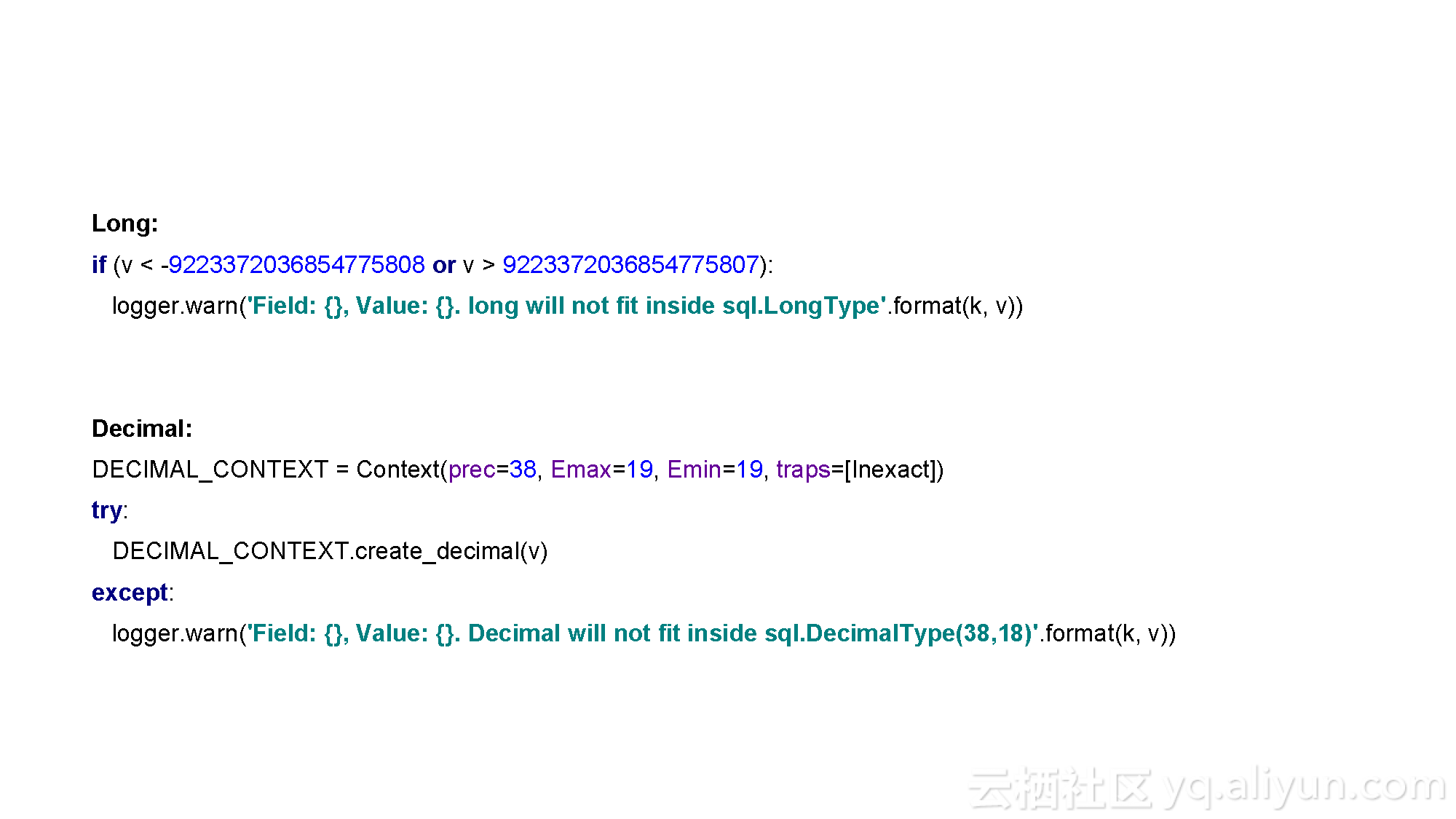

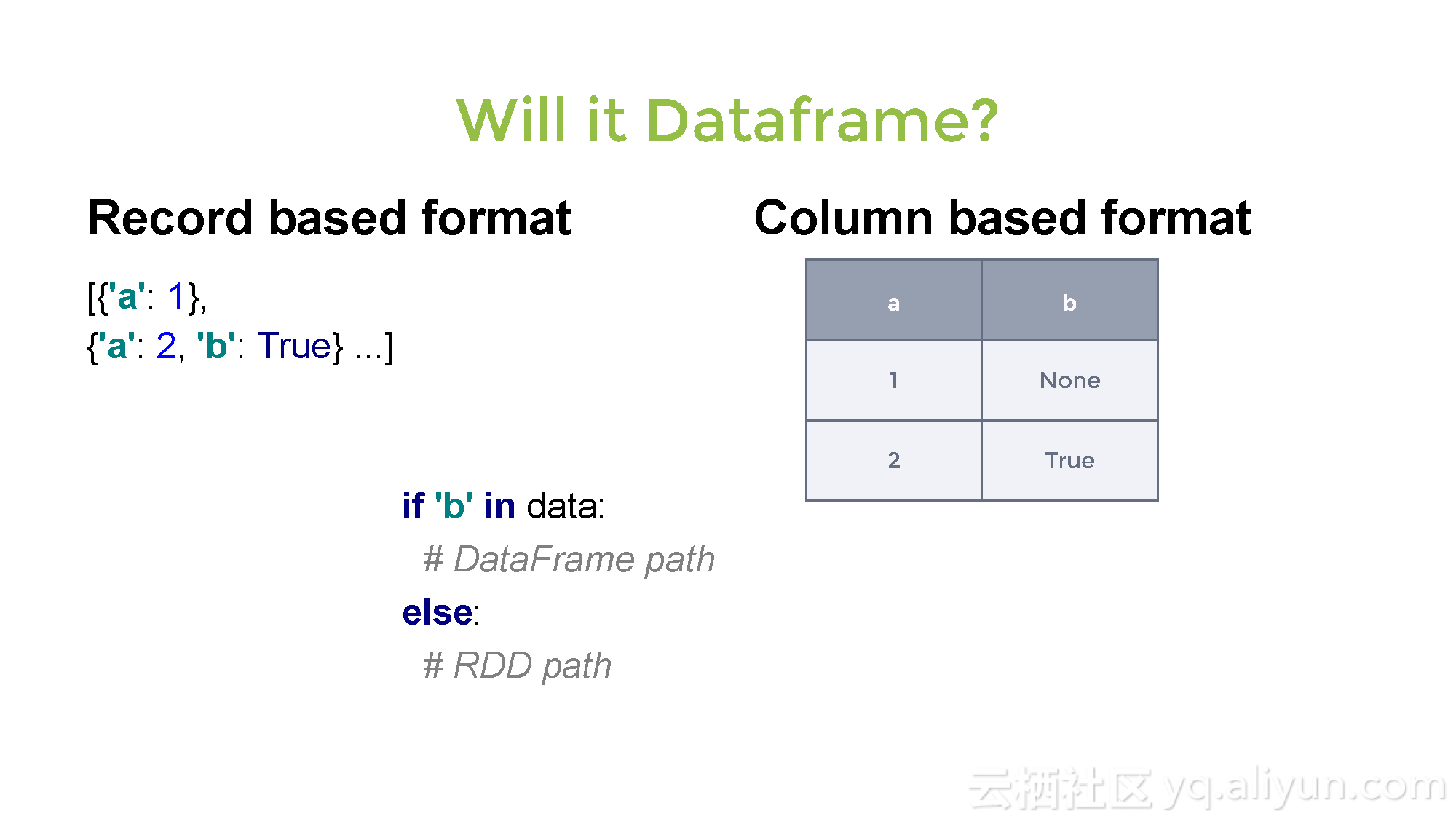

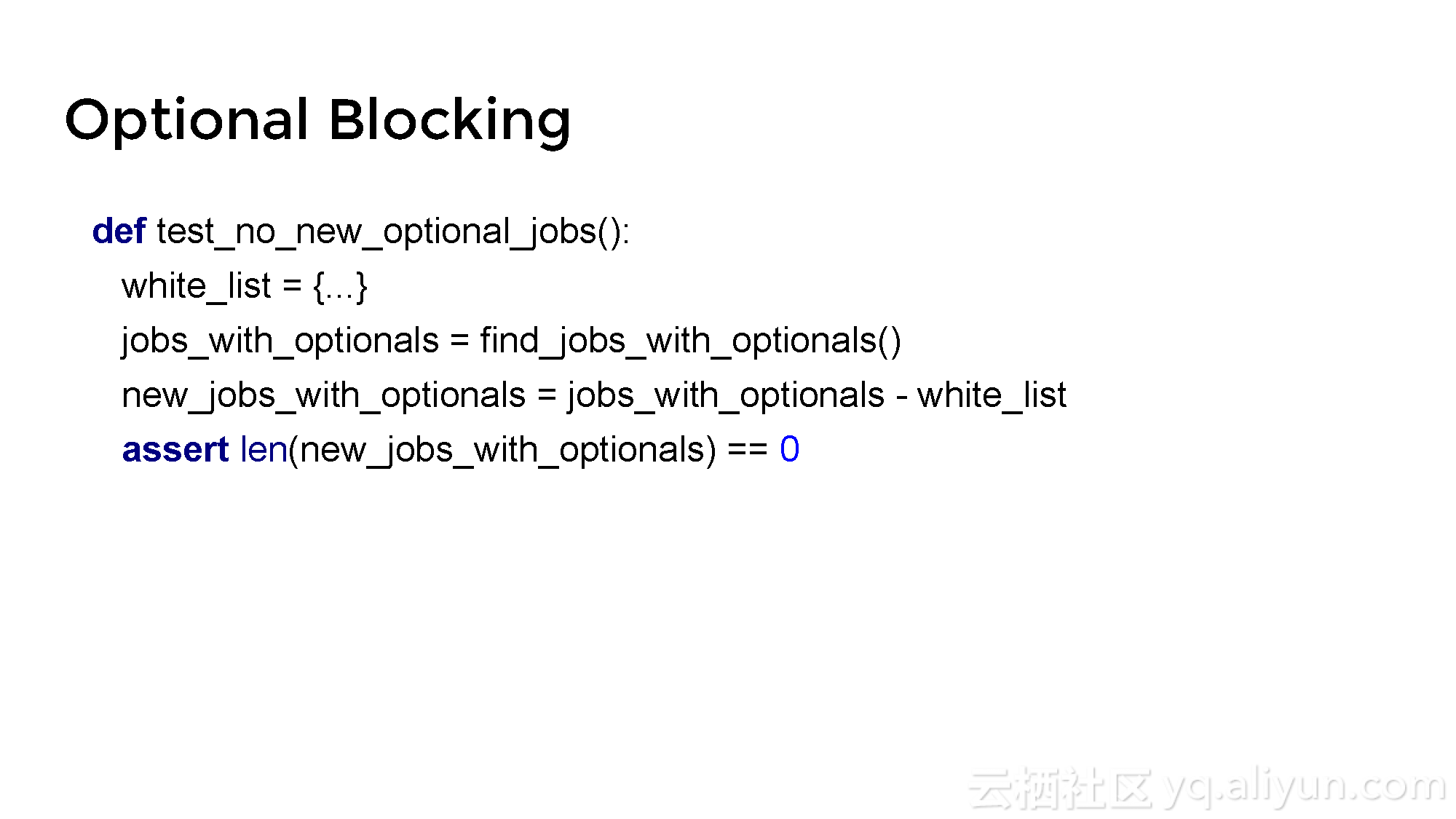

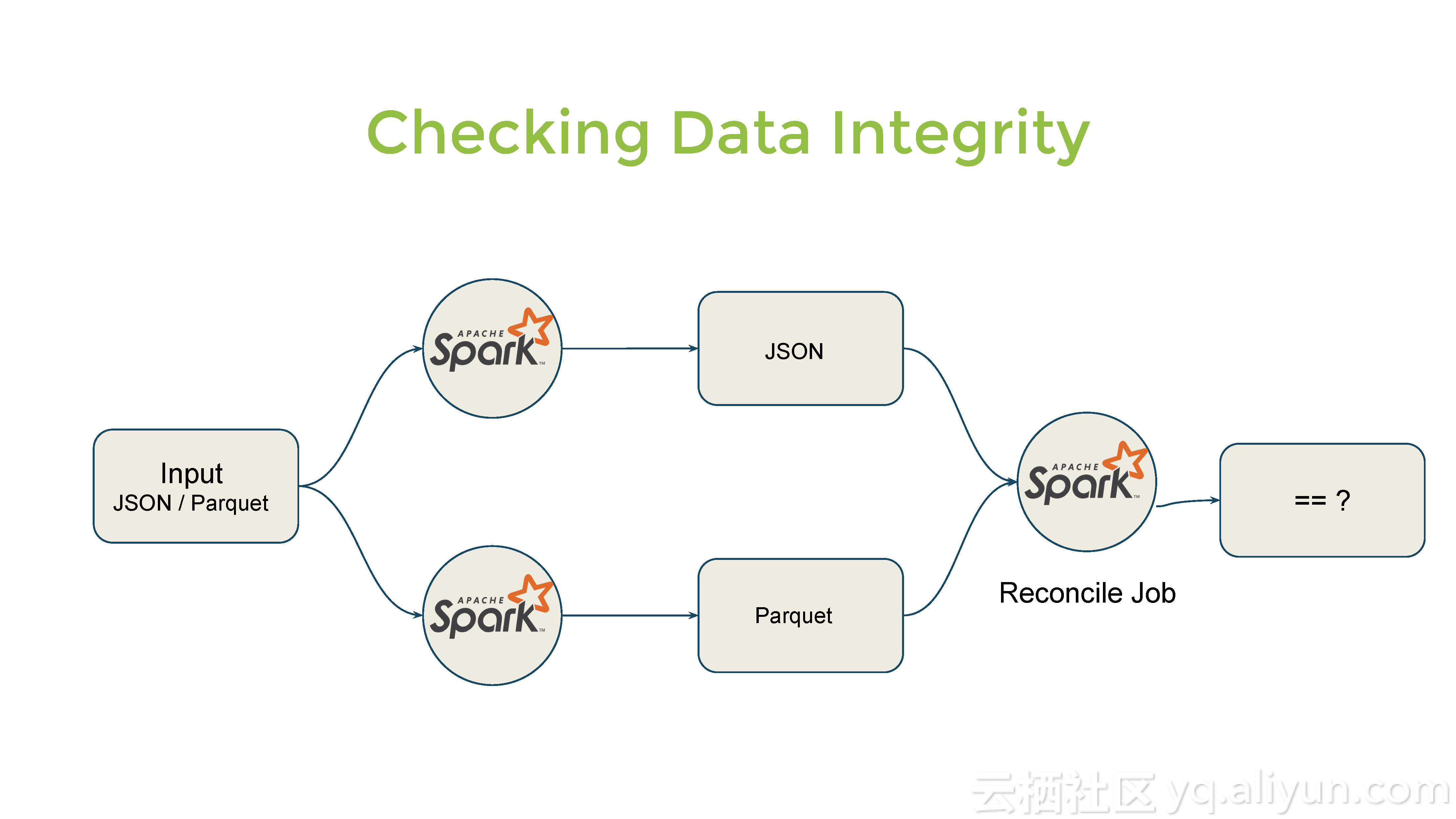

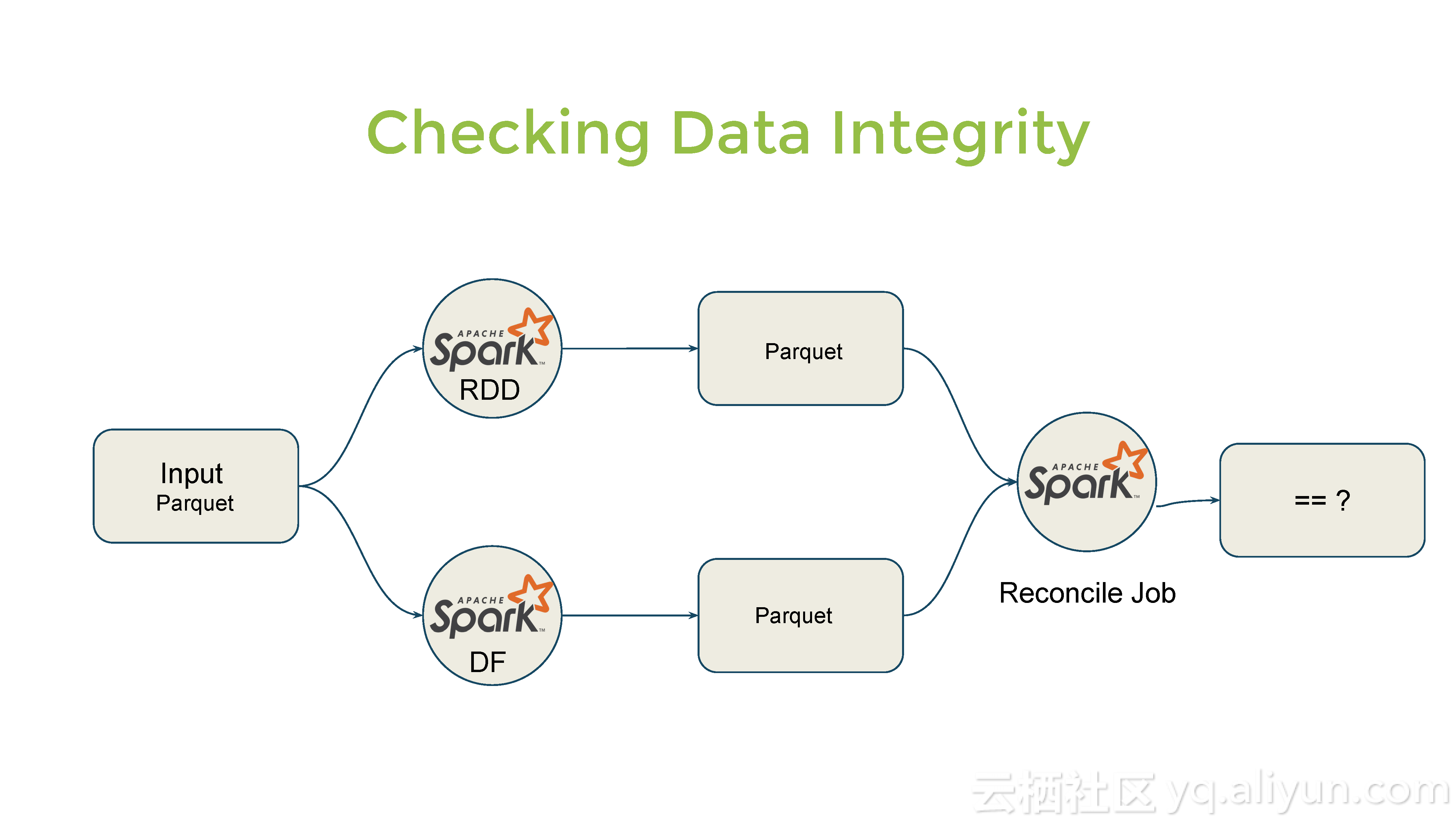

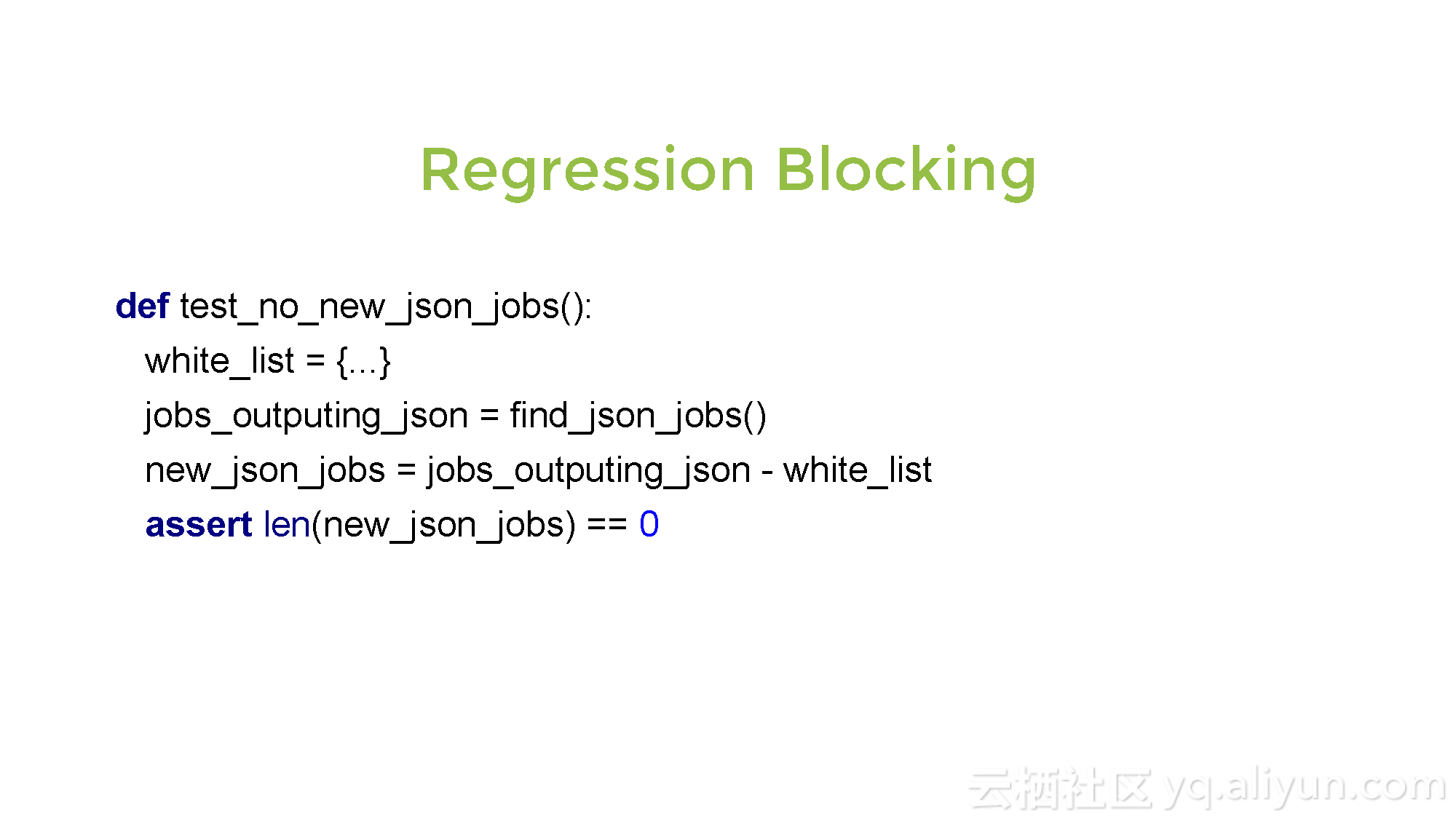

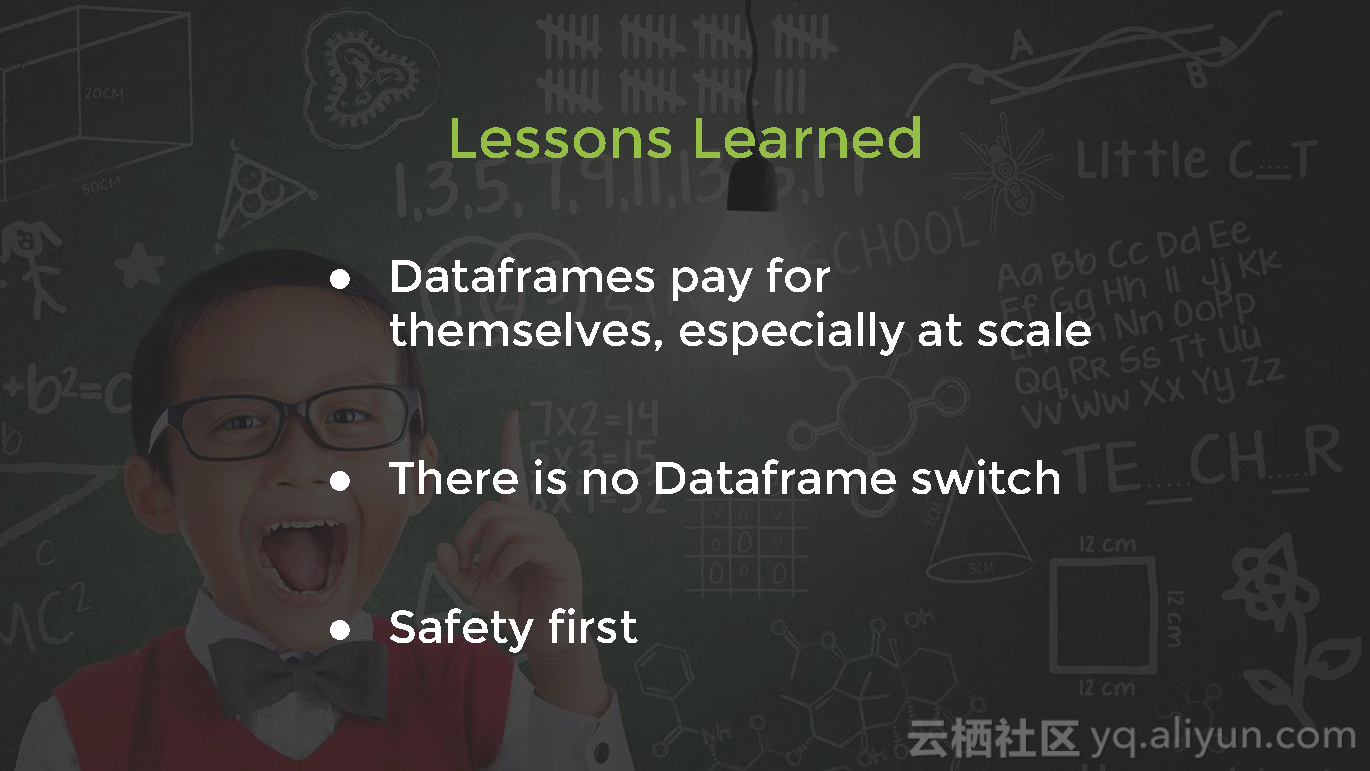

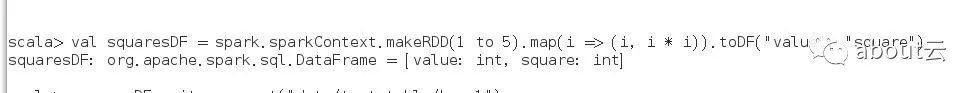

本讲义出自Sol Ackerman与Franklyn D'souza在Spark Summit EU上的演讲,在已存在的数据仓库中使用Dataframes+Parquet的经验方法,实现了在保证原有代码的情况下,引进Dataframes+Parquet,并且重写比较慢的工作作为Dataframes的管道,用Spark对从输入端流入的数据进行处理并输出。