如今有很多公司都在努力挖掘他们拥有的大量数据,包括结构化、非结构化、半结构化以及二进制数据等,来探索对数据的深入利用。

大多数公司估计他们只分析了已有数据的12%,剩余88%还没有被充分利用。大量的数据孤岛和分析能力的缺乏是造成这种局面的主要原因。另外一个难题是如何判断数据是否有价值。尤其是在大数据时代,为了避免数据丢失你必须采集并存储这些数据。一些看起来与业务无关的数据,如手机GPS数据,将来也可能会有大用处。

所以,大量公司都寄希望于使用Hadoop解决如下难题:

采集并存储与公司业务职能相关的所有数据。支撑先进的分析功能,包括商业智能,采用现代方式对数据进行先进的可视化和预测性分析。将数据快速分享给所需之人。整合多个数据孤岛来解答以前根本没人提过,甚至是未知的复杂问题。Hadoop支持解决方案规模的快速、有效扩大,使不断增长的容量、速度以及多样的数据能够得到快速的处理。

如今Hadoop的购买周期正处于上升阶段,因此在该领域催生了越来越多的厂商。尽管Hadoop是Apache的开源项目,任何人都可以免费下载,但大多数消费者还是倾向于采用厂商的打包方案。除了将所有的Hadoop组件打包并保证其能正常使用(兼容版本)之外,厂商一般还会提供企业级支持和扩展:以Apache Hadoop(HDFS)作为方案的核心组件,搭配额外实现增强Hadoop的功能,并增加差异化功能使其解决方案更具吸引力。

在大数据Hadoop解决方案评测中,厂商有Amazon Web Services、Cloudera、Hortonworks、IBM、MapR科技、华为和大快搜索。这些厂商都是基于Apache开源项目,然后增加打包、支持、集成等特性以及自己的创新等内容以弥补Hadoop在企业中的短板。所有厂商都实现了这些功能,尽管方式略有不同——从各厂商的评测得分和厂商资料可见一斑。

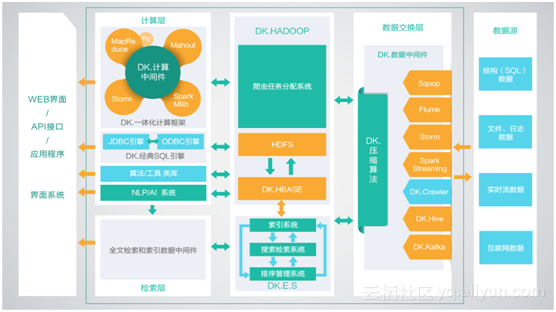

大快大数据平台(DKH),是大快搜索为了打通大数据生态系统与传统非大数据公司之间的通道而设计的一站式搜索引擎级,大数据通用计算平台。传统公司通过使用DKH,可以轻松的跨越大数据的技术鸿沟,实现搜索引擎级的大数据平台性能。

DKH,有效的集成了整个HADOOP生态系统的全部组件,并深度优化,重新编译为一个完整的更高性能的大数据通用计算平台,实现了各部件的有机协调。因此DKH相比开源的大数据平台,在计算性能上有了高达5倍(最大)的性能提升。

DKH,更是通过大快独有的中间件技术,将复杂的大数据集群配置简化至三种节点(主节点、管理节点、计算节点),极大的简化了集群的管理运维,增强了集群的高可用性、高可维护性、高稳定性。

DKH,虽然进行了高度的整合,但是仍然保持了开源系统的全部优点,并与开源系统100%兼容,基于开源平台开发的大数据应用,无需经过任何改动,即可在DKH上高效运行,并且性能会有最高5倍的提升。

传统的企业方法

在这种方法中,一个企业将有一个计算机存储和处理大数据。对于存储而言,程序员会自己选择的数据库厂商,如Oracle,IBM等的帮助下完成,用户交互使用应用程序进而获取并处理数据存储和分析。

局限性

这种方式能完美地处理那些可以由标准的数据库服务器来存储,或直至处理数据的处理器的限制少的大量数据应用程序。但是,当涉及到处理大量的可伸缩数据,这是一个繁忙的任务,只能通过单一的数据库瓶颈来处理这些数据。

谷歌的解决方案

使用一种称为MapReduce的算法谷歌解决了这个问题。这个算法将任务分成小份,并将它们分配到多台计算机,并且从这些机器收集结果并综合,形成了结果数据集。Hadoop

使用谷歌提供的解决方案,DougCutting和他的团队开发了一个开源项目叫做HADOOP。Hadoop使用的MapReduce算法运行,其中数据在使用其他并行处理的应用程序。总之,Hadoop用于开发可以执行完整的统计分析大数据的应用程序。