redis 存储结构

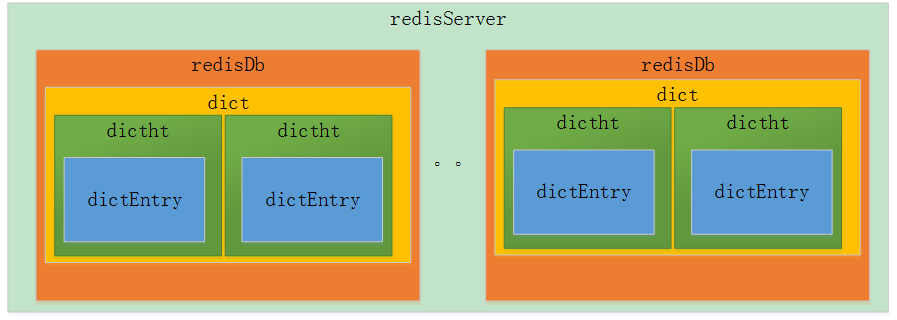

- redis的存储结构从外层往内层依次是redisDb、dict、dictht、dictEntry。

- redis的Db默认情况下有15个,每个redisDb内部包含一个dict的数据结构。

- redis的dict内部包含dictht的数组,数组个数为2,主要用于hash扩容使用。

- dictht内部包含dictEntry的数组,可以理解就是hash的桶,然后如果冲突通过挂链法解决。

redis存储结构

redisServer内部包含着 redisDb *db的数组元素,只是用指针体现而已。

struct redisServer {

/* General */

// 配置文件的绝对路径

char *configfile; /* Absolute config file path, or NULL */

// serverCron() 每秒调用的次数

int hz; /* serverCron() calls frequency in hertz */

// 数据库

redisDb *db;

// 省略很多其他属性

}

redisDb内部包含着dict *dict和dict *expires,用于存储数据和过期事件

typedef struct redisDb {

// 数据库键空间,保存着数据库中的所有键值对

dict *dict; /* The keyspace for this DB */

// 键的过期时间,字典的键为键,字典的值为过期事件 UNIX 时间戳

dict *expires; /* Timeout of keys with a timeout set */

// 正处于阻塞状态的键

dict *blocking_keys; /* Keys with clients waiting for data (BLPOP) */

// 可以解除阻塞的键

dict *ready_keys; /* Blocked keys that received a PUSH */

// 正在被 WATCH 命令监视的键

dict *watched_keys; /* WATCHED keys for MULTI/EXEC CAS */

struct evictionPoolEntry *eviction_pool; /* Eviction pool of keys */

// 数据库号码

int id; /* Database ID */

// 数据库的键的平均 TTL ,统计信息

long long avg_ttl; /* Average TTL, just for stats */

} redisDb;

dict内部包含 dictht ht[2],是存储数据的对象,之所以有两个元素是为了扩容方便。

/*

* 字典

*/

typedef struct dict {

// 类型特定函数

dictType *type;

// 私有数据

void *privdata;

// 哈希表

dictht ht[2];

// rehash 索引

// 当 rehash 不在进行时,值为 -1

int rehashidx; /* rehashing not in progress if rehashidx == -1 */

// 目前正在运行的安全迭代器的数量

int iterators; /* number of iterators currently running */

} dict;

真正保存数据的核心数据结构, dictEntry **table可以理解为hash的桶,通过挂链法解决冲突。

/*

* 哈希表

*

* 每个字典都使用两个哈希表,从而实现渐进式 rehash 。

*/

typedef struct dictht {

// 哈希表数组

dictEntry **table;

// 哈希表大小

unsigned long size;

// 哈希表大小掩码,用于计算索引值

// 总是等于 size - 1

unsigned long sizemask;

// 该哈希表已有节点的数量

unsigned long used;

} dictht;

存储数据的单个节点,包含key和value。保存我们存储在redis的数据。

/*

* 哈希表节点

*/

typedef struct set {

// 键

void *key;

// 值

union {

void *val;

uint64_t u64;

int64_t s64;

} v;

// 指向下个哈希表节点,形成链表

struct dictEntry *next;

} dictEntry;

redis 数据存储过程

数据存储过程以set为例作为说明,过程如下:

- 从redisDb当中找到dict,每个db就一个dict而已。

- 从dict当中选择具体的dictht对象。

- 首先根据key计算hash桶的位置,也就是index。

- 新建一个DictEntry对象用于保存key/value,将新增的entry挂到dictht的table对应的hash桶当中,每次保存到挂链的头部。

- dictSetKey的宏保存key

- dictSetVal的宏保存value

/* High level Set operation. This function can be used in order to set

* a key, whatever it was existing or not, to a new object.

*

* 高层次的 SET 操作函数。

*

* 这个函数可以在不管键 key 是否存在的情况下,将它和 val 关联起来。

*

* 1) The ref count of the value object is incremented.

* 值对象的引用计数会被增加

*

* 2) clients WATCHing for the destination key notified.

* 监视键 key 的客户端会收到键已经被修改的通知

*

* 3) The expire time of the key is reset (the key is made persistent).

* 键的过期时间会被移除(键变为持久的)

*/

void setKey(redisDb *db, robj *key, robj *val) {

// 添加或覆写数据库中的键值对

if (lookupKeyWrite(db,key) == NULL) {

dbAdd(db,key,val);

} else {

dbOverwrite(db,key,val);

}

incrRefCount(val);

// 移除键的过期时间

removeExpire(db,key);

// 发送键修改通知

signalModifiedKey(db,key);

}

/* Add the key to the DB. It's up to the caller to increment the reference

* counter of the value if needed.

*

* 尝试将键值对 key 和 val 添加到数据库中。

*

* 调用者负责对 key 和 val 的引用计数进行增加。

*

* The program is aborted if the key already exists.

*

* 程序在键已经存在时会停止。

*/

void dbAdd(redisDb *db, robj *key, robj *val) {

// 复制键名

sds copy = sdsdup(key->ptr);

// 尝试添加键值对

int retval = dictAdd(db->dict, copy, val);

// 如果键已经存在,那么停止

redisAssertWithInfo(NULL,key,retval == REDIS_OK);

// 如果开启了集群模式,那么将键保存到槽里面

if (server.cluster_enabled) slotToKeyAdd(key);

}

/* Add an element to the target hash table */

/*

* 尝试将给定键值对添加到字典中

*

* 只有给定键 key 不存在于字典时,添加操作才会成功

*

* 添加成功返回 DICT_OK ,失败返回 DICT_ERR

*

* 最坏 T = O(N) ,平滩 O(1)

*/

int dictAdd(dict *d, void *key, void *val)

{

// 尝试添加键到字典,并返回包含了这个键的新哈希节点

// T = O(N)

dictEntry *entry = dictAddRaw(d,key);

// 键已存在,添加失败

if (!entry) return DICT_ERR;

// 键不存在,设置节点的值

// T = O(1)

dictSetVal(d, entry, val);

// 添加成功

return DICT_OK;

}

/*

* 尝试将键插入到字典中

*

* 如果键已经在字典存在,那么返回 NULL

*

* 如果键不存在,那么程序创建新的哈希节点,

* 将节点和键关联,并插入到字典,然后返回节点本身。

*

* T = O(N)

*/

dictEntry *dictAddRaw(dict *d, void *key)

{

int index;

dictEntry *entry;

dictht *ht;

// 如果条件允许的话,进行单步 rehash

// T = O(1)

if (dictIsRehashing(d)) _dictRehashStep(d);

/* Get the index of the new element, or -1 if

* the element already exists. */

// 计算键在哈希表中的索引值

// 如果值为 -1 ,那么表示键已经存在

// T = O(N)

if ((index = _dictKeyIndex(d, key)) == -1)

return NULL;

// T = O(1)

/* Allocate the memory and store the new entry */

// 如果字典正在 rehash ,那么将新键添加到 1 号哈希表

// 否则,将新键添加到 0 号哈希表

ht = dictIsRehashing(d) ? &d->ht[1] : &d->ht[0];

// 为新节点分配空间

entry = zmalloc(sizeof(*entry));

// 将新节点插入到链表表头

entry->next = ht->table[index];

ht->table[index] = entry;

// 更新哈希表已使用节点数量

ht->used++;

/* Set the hash entry fields. */

// 设置新节点的键

// T = O(1)

dictSetKey(d, entry, key);

return entry;

}

// 设置给定字典节点的键

#define dictSetKey(d, entry, _key_) do { \

if ((d)->type->keyDup) \

entry->key = (d)->type->keyDup((d)->privdata, _key_); \

else \

entry->key = (_key_); \

} while(0)

// 设置给定字典节点的值

#define dictSetVal(d, entry, _val_) do { \

if ((d)->type->valDup) \

entry->v.val = (d)->type->valDup((d)->privdata, _val_); \

else \

entry->v.val = (_val_); \

} while(0)

redis 过期事件存储过程

redis的过期事件存储在db->expires的对象当中,整个设置过期时间的过程如下:

- 从db-dict获取原来存储数据,之所以去取数是为了保证key的存在性

- 从db->expires获取旧的过期事件并重新计算过期时间dictReplaceRaw

- 将过期时间重新保存到DictEntry当中,也就是db->expires中的某个对象。

/*

* 将键 key 的过期时间设为 when

*/

void setExpire(redisDb *db, robj *key, long long when) {

dictEntry *kde, *de;

/* Reuse the sds from the main dict in the expire dict */

// 取出键

kde = dictFind(db->dict,key->ptr);

redisAssertWithInfo(NULL,key,kde != NULL);

// 根据键取出键的过期时间

de = dictReplaceRaw(db->expires,dictGetKey(kde));

// 设置键的过期时间

// 这里是直接使用整数值来保存过期时间,不是用 INT 编码的 String 对象

dictSetSignedIntegerVal(de,when);

}

redis数据淘汰过程

淘汰数据的过程是在processCommand当中实现的,这里我们需要关注freeMemoryIfNeeded的方法。

int processCommand(redisClient *c) {

/* Handle the maxmemory directive.

*

* First we try to free some memory if possible (if there are volatile

* keys in the dataset). If there are not the only thing we can do

* is returning an error. */

// 如果设置了最大内存,那么检查内存是否超过限制,并做相应的操作

if (server.maxmemory) {

// 如果内存已超过限制,那么尝试通过删除过期键来释放内存

int retval = freeMemoryIfNeeded();

// 如果即将要执行的命令可能占用大量内存(REDIS_CMD_DENYOOM)

// 并且前面的内存释放失败的话

// 那么向客户端返回内存错误

if ((c->cmd->flags & REDIS_CMD_DENYOOM) && retval == REDIS_ERR) {

flagTransaction(c);

addReply(c, shared.oomerr);

return REDIS_OK;

}

}

整个数据淘汰过程如下:

- 遍历所有的db进行数据的释放

- 根据不同的策略选择从db.dict还是从db.expires选择待过期数据

- 区分不同的淘汰策略选择不同的key,主要分为随机淘汰、LRU淘汰、TTL时间淘汰。

int freeMemoryIfNeeded(void) {

/* Compute how much memory we need to free. */

// 计算需要释放多少字节的内存

mem_tofree = mem_used - server.maxmemory;

// 初始化已释放内存的字节数为 0

mem_freed = 0;

// 根据 maxmemory 策略,

// 遍历字典,释放内存并记录被释放内存的字节数

while (mem_freed < mem_tofree) {

int j, k, keys_freed = 0;

// 遍历所有字典

for (j = 0; j < server.dbnum; j++) {

long bestval = 0; /* just to prevent warning */

sds bestkey = NULL;

dictEntry *de;

redisDb *db = server.db+j;

dict *dict;

if (server.maxmemory_policy == REDIS_MAXMEMORY_ALLKEYS_LRU ||

server.maxmemory_policy == REDIS_MAXMEMORY_ALLKEYS_RANDOM)

{

// 如果策略是 allkeys-lru 或者 allkeys-random

// 那么淘汰的目标为所有数据库键

dict = server.db[j].dict;

} else {

// 如果策略是 volatile-lru 、 volatile-random 或者 volatile-ttl

// 那么淘汰的目标为带过期时间的数据库键

dict = server.db[j].expires;

}

// 跳过空字典

if (dictSize(dict) == 0) continue;

/* volatile-random and allkeys-random policy */

// 如果使用的是随机策略,那么从目标字典中随机选出键

if (server.maxmemory_policy == REDIS_MAXMEMORY_ALLKEYS_RANDOM ||

server.maxmemory_policy == REDIS_MAXMEMORY_VOLATILE_RANDOM)

{

de = dictGetRandomKey(dict);

bestkey = dictGetKey(de);

}

/* volatile-lru and allkeys-lru policy */

// 如果使用的是 LRU 策略,

// 那么从一集 sample 键中选出 IDLE 时间最长的那个键

else if (server.maxmemory_policy == REDIS_MAXMEMORY_ALLKEYS_LRU ||

server.maxmemory_policy == REDIS_MAXMEMORY_VOLATILE_LRU)

{

struct evictionPoolEntry *pool = db->eviction_pool;

while(bestkey == NULL) {

evictionPoolPopulate(dict, db->dict, db->eviction_pool);

/* Go backward from best to worst element to evict. */

for (k = REDIS_EVICTION_POOL_SIZE-1; k >= 0; k--) {

if (pool[k].key == NULL) continue;

de = dictFind(dict,pool[k].key);

/* Remove the entry from the pool. */

sdsfree(pool[k].key);

/* Shift all elements on its right to left. */

memmove(pool+k,pool+k+1,

sizeof(pool[0])*(REDIS_EVICTION_POOL_SIZE-k-1));

/* Clear the element on the right which is empty

* since we shifted one position to the left. */

pool[REDIS_EVICTION_POOL_SIZE-1].key = NULL;

pool[REDIS_EVICTION_POOL_SIZE-1].idle = 0;

/* If the key exists, is our pick. Otherwise it is

* a ghost and we need to try the next element. */

if (de) {

bestkey = dictGetKey(de);

break;

} else {

/* Ghost... */

continue;

}

}

}

}

/* volatile-ttl */

// 策略为 volatile-ttl ,从一集 sample 键中选出过期时间距离当前时间最接近的键

else if (server.maxmemory_policy == REDIS_MAXMEMORY_VOLATILE_TTL) {

for (k = 0; k < server.maxmemory_samples; k++) {

sds thiskey;

long thisval;

de = dictGetRandomKey(dict);

thiskey = dictGetKey(de);

thisval = (long) dictGetVal(de);

/* Expire sooner (minor expire unix timestamp) is better

* candidate for deletion */

if (bestkey == NULL || thisval < bestval) {

bestkey = thiskey;

bestval = thisval;

}

}

}

/* Finally remove the selected key. */

// 删除被选中的键

if (bestkey) {

long long delta;

robj *keyobj = createStringObject(bestkey,sdslen(bestkey));

propagateExpire(db,keyobj);

/* We compute the amount of memory freed by dbDelete() alone.

* It is possible that actually the memory needed to propagate

* the DEL in AOF and replication link is greater than the one

* we are freeing removing the key, but we can't account for

* that otherwise we would never exit the loop.

*

* AOF and Output buffer memory will be freed eventually so

* we only care about memory used by the key space. */

// 计算删除键所释放的内存数量

delta = (long long) zmalloc_used_memory();

dbDelete(db,keyobj);

delta -= (long long) zmalloc_used_memory();

mem_freed += delta;

// 对淘汰键的计数器增一

server.stat_evictedkeys++;

notifyKeyspaceEvent(REDIS_NOTIFY_EVICTED, "evicted",

keyobj, db->id);

decrRefCount(keyobj);

keys_freed++;

/* When the memory to free starts to be big enough, we may

* start spending so much time here that is impossible to

* deliver data to the slaves fast enough, so we force the

* transmission here inside the loop. */

if (slaves) flushSlavesOutputBuffers();

}

}

if (!keys_freed) return REDIS_ERR; /* nothing to free... */

}

return REDIS_OK;

}

随机淘汰

随机淘汰的场景下获取待删除key的策略,随机找hash桶再次hash指定位置的dictEntry即可。

就是在场景REDIS_MAXMEMORY_VOLATILE_RANDOM和REDIS_MAXMEMORY_ALLKEYS_LRU情况下的待淘汰的key。

/*

* 随机返回字典中任意一个节点。

*

* 可用于实现随机化算法。

*

* 如果字典为空,返回 NULL 。

*

* T = O(N)

*/

dictEntry *dictGetRandomKey(dict *d)

{

dictEntry *he, *orighe;

unsigned int h;

int listlen, listele;

// 字典为空

if (dictSize(d) == 0) return NULL;

// 进行单步 rehash

if (dictIsRehashing(d)) _dictRehashStep(d);

// 如果正在 rehash ,那么将 1 号哈希表也作为随机查找的目标

if (dictIsRehashing(d)) {

// T = O(N)

do {

h = random() % (d->ht[0].size+d->ht[1].size);

he = (h >= d->ht[0].size) ? d->ht[1].table[h - d->ht[0].size] :

d->ht[0].table[h];

} while(he == NULL);

// 否则,只从 0 号哈希表中查找节点

} else {

// T = O(N)

do {

h = random() & d->ht[0].sizemask;

he = d->ht[0].table[h];

} while(he == NULL);

}

/* Now we found a non empty bucket, but it is a linked

* list and we need to get a random element from the list.

* The only sane way to do so is counting the elements and

* select a random index. */

// 目前 he 已经指向一个非空的节点链表

// 程序将从这个链表随机返回一个节点

listlen = 0;

orighe = he;

// 计算节点数量, T = O(1)

while(he) {

he = he->next;

listlen++;

}

// 取模,得出随机节点的索引

listele = random() % listlen;

he = orighe;

// 按索引查找节点

// T = O(1)

while(listele--) he = he->next;

// 返回随机节点

return he;

}

LRU 策略

LRU 策略淘汰思路如下:

- dictGetRandomKeys随机获取指定数目的dictEntry。

- 将获取的的dictEntry进行下sort按照最近时间进行排序。

- 选择最近使用时间最久远的数据进行过期

- 每次过期的数据其实是采样的结果数据中的最近未被访问数据而非全局的。

void evictionPoolPopulate(dict *sampledict, dict *keydict, struct evictionPoolEntry *pool) {

int j, k, count;

dictEntry *_samples[EVICTION_SAMPLES_ARRAY_SIZE];

dictEntry **samples;

/* Try to use a static buffer: this function is a big hit...

* Note: it was actually measured that this helps. */

if (server.maxmemory_samples <= EVICTION_SAMPLES_ARRAY_SIZE) {

samples = _samples;

} else {

samples = zmalloc(sizeof(samples[0])*server.maxmemory_samples);

}

#if 1 /* Use bulk get by default. */

count = dictGetRandomKeys(sampledict,samples,server.maxmemory_samples);

#else

count = server.maxmemory_samples;

for (j = 0; j < count; j++) samples[j] = dictGetRandomKey(sampledict);

#endif

for (j = 0; j < count; j++) {

unsigned long long idle;

sds key;

robj *o;

dictEntry *de;

de = samples[j];

key = dictGetKey(de);

/* If the dictionary we are sampling from is not the main

* dictionary (but the expires one) we need to lookup the key

* again in the key dictionary to obtain the value object. */

if (sampledict != keydict) de = dictFind(keydict, key);

o = dictGetVal(de);

idle = estimateObjectIdleTime(o);

/* Insert the element inside the pool.

* First, find the first empty bucket or the first populated

* bucket that has an idle time smaller than our idle time. */

k = 0;

while (k < REDIS_EVICTION_POOL_SIZE &&

pool[k].key &&

pool[k].idle < idle) k++;

if (k == 0 && pool[REDIS_EVICTION_POOL_SIZE-1].key != NULL) {

/* Can't insert if the element is < the worst element we have

* and there are no empty buckets. */

continue;

} else if (k < REDIS_EVICTION_POOL_SIZE && pool[k].key == NULL) {

/* Inserting into empty position. No setup needed before insert. */

} else {

/* Inserting in the middle. Now k points to the first element

* greater than the element to insert. */

if (pool[REDIS_EVICTION_POOL_SIZE-1].key == NULL) {

/* Free space on the right? Insert at k shifting

* all the elements from k to end to the right. */

memmove(pool+k+1,pool+k,

sizeof(pool[0])*(REDIS_EVICTION_POOL_SIZE-k-1));

} else {

/* No free space on right? Insert at k-1 */

k--;

/* Shift all elements on the left of k (included) to the

* left, so we discard the element with smaller idle time. */

sdsfree(pool[0].key);

memmove(pool,pool+1,sizeof(pool[0])*k);

}

}

pool[k].key = sdsdup(key);

pool[k].idle = idle;

}

if (samples != _samples) zfree(samples);

}

通过random() & d->ht[j].sizemask方法随机获取从某个hash桶开始随机获取dictEntry。获取的待淘汰的数据通过count进行指定。

int dictGetRandomKeys(dict *d, dictEntry **des, int count) {

int j; /* internal hash table id, 0 or 1. */

int stored = 0;

if (dictSize(d) < count) count = dictSize(d);

while(stored < count) {

for (j = 0; j < 2; j++) {

/* Pick a random point inside the hash table 0 or 1. */

unsigned int i = random() & d->ht[j].sizemask;

int size = d->ht[j].size;

/* Make sure to visit every bucket by iterating 'size' times. */

while(size--) {

dictEntry *he = d->ht[j].table[i];

while (he) {

/* Collect all the elements of the buckets found non

* empty while iterating. */

*des = he;

des++;

he = he->next;

stored++;

if (stored == count) return stored;

}

i = (i+1) & d->ht[j].sizemask;

}

/* If there is only one table and we iterated it all, we should

* already have 'count' elements. Assert this condition. */

assert(dictIsRehashing(d) != 0);

}

}

return stored; /* Never reached. */

}

TTL时间淘汰

TTL时间淘汰策略跟随机策略很像,唯一的区别就是TTL时间淘汰基于采样结果进行选择然后选择距离过期时间最近的数据进行过期,所以他理论上结合了采样+TTL时间计算进行数据淘汰的。

for (k = 0; k < server.maxmemory_samples; k++) {

sds thiskey;

long thisval;

de = dictGetRandomKey(dict);

thiskey = dictGetKey(de);

thisval = (long) dictGetVal(de);

/* Expire sooner (minor expire unix timestamp) is better

* candidate for deletion */

if (bestkey == NULL || thisval < bestval) {

bestkey = thiskey;

bestval = thisval;

}

}