学习的最好模式,就是学了就去马上用。上次是学完了urllib和re库之后尝试爬取了豆瓣分享的书单,那个时候发现urllib这个标准库还是不太好使。今天刚学了requests这个更好用的库之后,尝试和re一起使用爬取简书的第一页。

第一步:获取响应

使用的requests非常简单,非常人性化的get功能。

import requests

# 获取respnose

headers = {

'Accept':'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8',

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/57.0.2987.133 Safari/537.36',

'Host':'www.jianshu.com'

}

url = 'http://www.jianshu.com/'

response = requests.get(url,headers)

print(response.status_code)

context = response.text

第二步:从网页中提取目标信息

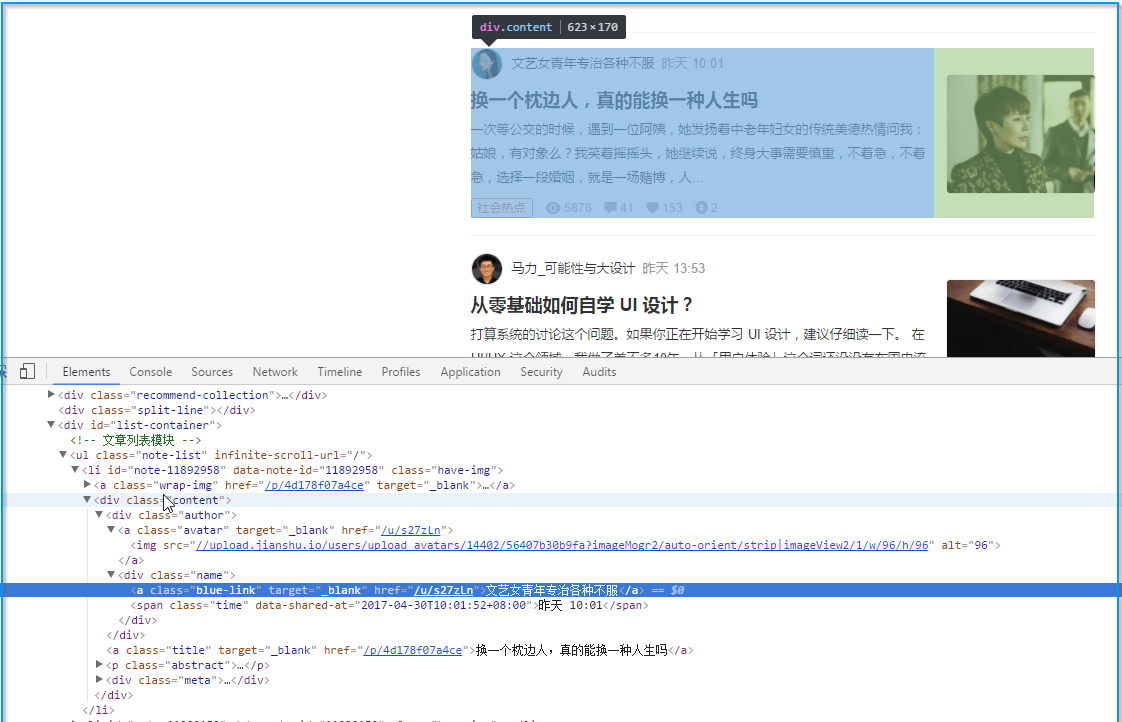

这一步主要涉及到观察网页构造,然后使用正则表达式

我的目标是:

- 作者

- 题目

- 文章简单内容

- 一些tag

先尝试构建获取作者的正则表达式

pattern = re.compile('<li.*?"name">.*?>(.*?)</a>',re.S)

re.findall(pattern,context)

#得到的结果

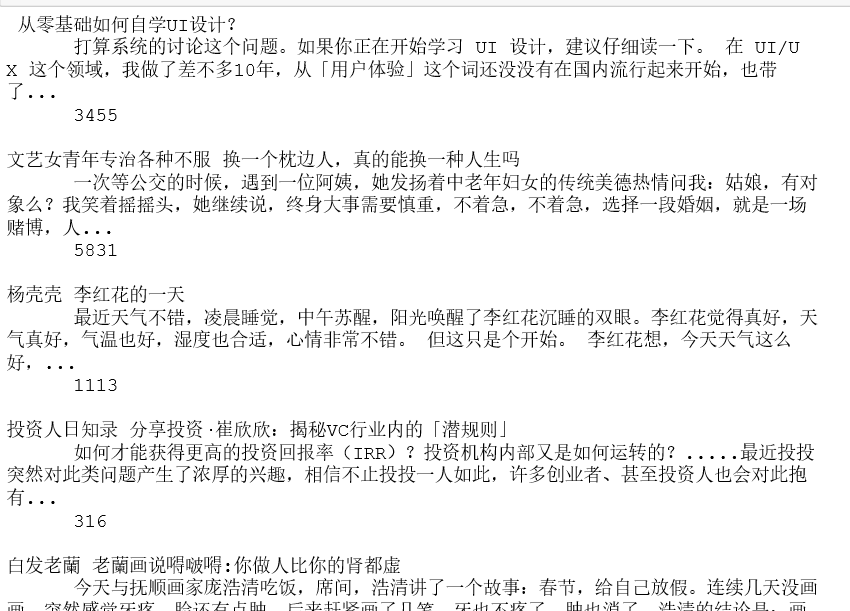

['\n',

'马力_可能性与大设计',

'文艺女青年专治各种不服',

'杨壳壳',

'投资人日知录',

'白发老蘭',

'2020号',

'无戒',

'大胃黄咚咚',

'Aicuuu',

'婉悦悠然',

'MadisonT',

'小荐荐',

'会啊哦的跳跳虫',

'梦旅人rose',

'吴益军子',

'饱醉豚',

'张涔汐',

'笙和箫',

'手机壳0207',

'雪花如糖']

一鼓作气,构建所有的目标信息的正则表达式模式:

pattern = re.compile('<li.*?"name">.*?>(.*?)</a>.*?"title".*?>(.*?)</a>.*?act">(.*?)</p>.*?/i>(.*?)</a>',re.S)

results = re.findall(pattern,context)

for info in results:

author,title,abstract,read_num = info

author = re.sub('\s','',author)

title = re.sub('\s','',title)

print(author,title,abstract,read_num )

部分爬取结果

下一步学习计划

- re模块虽然好用,但是写起来还是麻烦,所以要去学习beautifulsoup等解析库,换一种提取数据方式

- 目前的数据没有采用合理的保存方式,所以下一步 要去了解一下如何合理保存数据