在一个 SQL 的系统 中,所有有意义的数据 都存储在表和序列生成器中。

因此使用数据库 的第一步是定义 一个表和这个表中可能使用的列。

SQL 标准同时也能支持临时表和永久表,临时表用于临时性的存储数据,永久表用于在数据库中永久保持数据。

临时表

临时表的内容只在连接的生命周期中存在,如果连接被终止,临时表中的内容也将会被清除。临时表中的内容只对当前的连接可见,而不能被其他连接使用。临时表的定义,请参考 SQL 标准中的 GLOBAL TEMPORARY 类型。

如果定义临时表为永久表,当一个新的连接被建立的时候,这个连接也可以看到这个临时表,但是这个表的数据会保额清空。当连接发出一个 commit 提交指令的时候,表中的内容将会被默认定义的内容替换掉。

如果表中定义了内容 ON COMMIT PRESERVE ROWS,那么提交的时候,将不会用默认的值替换掉表中的内容。

永久表

HSQLDB 支持 SQL 标准中定义的表类型,但是所有定义的类型与表中存储的数据有关。在 HSQLDB 中有三种类型的表,分别为 MEMORY,CACHED 和 TEXT。

MEMORY 表可以用命令 CREATE TABLE 来定义。这些表中存储了所有数据的实体,当然你也可以通过 SQL 脚本对表中的数据进行修改,所有内容的修改将会被写到 .log 和 .script 文件 中。

.log 和 .script 文件将会在数据库下一次启动的时候读取,同时表中的数据将会根据这两个文件中的内容进行重建。不像临时表,这种类型的表是长期存在的。我们定义的内存表在数据库被打开的时候,所有表中的数据将会被读取和替换。这个过程将会耗费比较长的时间 ,如果表的数据量超过几十兆字节的时候。当数据库关闭的时候,所有数据将会被保存,这个过程同样也会消耗很长时间。

CACHED 表使用命令 CREATE CACHED TABLE 命令进行创建。表中的部分数据和索引将会被加载到内存中。这种表允许存储大量的数据而不需要将表中的所有数据都加载到内存中。另外的好处是,在数据库启动 的时候,数据库引擎只对表中的少量数据进行索引,这样能够加快处理速度也能让表存储更多人内容。但是,这种类型的表将会降低处理速度,如果你的数据量非常 小,请不要使用这种类型的表。如果在一个应用 程序 中包含有一些大数据量的表和小数据量的表,最好默认将所有的小表采用内存模式。

TEXT 表使用 CSV 或者其他逗号分隔符来存储其数据。你可以指定一个已经存在的 CSV 文件,这个文件可以是从其他数据库或者程序里面导出的。或者,你可以使用一个空的数据文件,然后使用数据库引擎将数据导入到这个文件中。TEXT 表对内存的使用非常有效,因为这种类型的表之缓存部分数据到内存,但是这种表会缓存所有索引到内存中。如果必要的话,TEXT 表中的内容可以被任意指定。如何设定 TEXT 表的具体内容在 Text 表设定的章节中讨论。

在全内存的数据库中 MEMORY 和 CACHED 表被声明为非持久的内存表。TEXT 表不能被声明为这种表。

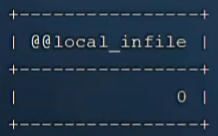

创建表的中的默认类型可以用下面的命令进行定义,这样使用 CREATE TABLE 命令创建的表将会使用数据库默认定义的类型中进行定义:

SET DATABASE DEFAULT TABLE TYPE { CACHED | MEMORY };如果你希望修改已经存在表的类型,你可以用下面的命令:

SET TABLE <table name> TYPE { CACHED | MEMORY };在 SQL 语句中对不同类型的表进行访问,你不需要在你的 SQL 语句中指定表的类型。

LOB 数据

Lob 数据为存储在数据库表里面的逻辑列。这些数据的物理存储是在文件系统中以 *.lobs 为后缀名的文件。在 HSQLDB 2.0 中,这个文件在 BLOB 或 CLOB 字段 被插入到表中的时候被创建。这个文件将会作为一个持续增长的文件而被插入到数据库中。在 HSQLDB 的 2.0 版本中, 尽管你的数据库中的所有 LOB 数据被删除 了, *.lobs 也不会被删除。当你确定所有 LOB 数据被删除后,你可以在数据库引擎被关闭后手工删除 *.lobs 文件。