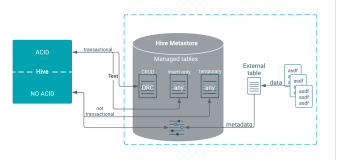

一、Hive 运行模式

1. 内嵌模式

将元数据保存在本地内嵌的 Derby 数据库中,这是使用 hive 最简单的方式。但是这种方式缺点也比较明显,因为一个内嵌的 Derby 数据库每次只能访问一个数据文件,这也就意味着它不支持多会话连接。

2. 本地模式

这种模式是将元数据保存在本地独立的数据库中(一般是 MySQL),这用就可以支持多会话和多用户连接了。

3. 远程模式

此模式应用于 Hive 客户端较多的情况。把 mysql 数据库独立出来,将元数据保存在远端独立的 MySQL 服务中,避免了在每个客户端都安装 MySQL 服务从而造成冗余浪费的情况。

二、下载安装 Hive

http://hive.apache.org/downloads.html

三、配置系统环境变量

修改 /etc/profile 文件,使用 sudo vim /etc/profile 来修改:

# Hive environment export HIVE_HOME=/usr/local/hadoop/hive export PATH=$HIVE_HOME/bin:$HIVE_HOME/conf:$PATH

四、内嵌模式

(1)修改 Hive 配置文件

$HIVE_HOME/conf 对应的是 Hive 的配置文件路径,类似于之前学习的Hbase, 该路径下的 hive-site.xml 是 Hive 工程的配置文件。默认情况下,该文件并不存在,我们需要拷贝它的模版来实现:

$ cp hive-default.xml.template hive-site.xml

hive-site.xml 的主要配置有:

hive.metastore.warehouse.dir

该参数指定了 Hive 的数据存储目录,默认位置在 HDFS 上面的 /user/hive/warehouse 路径下。hive.exec.scratchdir

该参数指定了 Hive 的数据临时文件目录,默认位置为 HDFS 上面的 /tmp/hive 路径下。

同时我们还要修改 Hive 目录下 /conf/hive-env.sh 文件(请根据自己的实际路径修改),该文件默认也不存在,同样是拷贝它的模版来修改:

export HADOOP_HEAPSIZE=1024 # Set HADOOP_HOME to point to a specific hadoop install directory HADOOP_HOME=/usr/local/hadoop # Hive Configuration Directory can be controlled by: export HIVE_CONF_DIR=/usr/local/hadoop/hive/conf # Folder containing extra ibraries required for hive compilation/execution can be controlled by: export HIVE_AUX_JARS_PATH=/usr/local/hadoop/hive/lib

(2)创建必要目录

前面我们看到 hive-site.xml 文件中有两个重要的路径,切换到 hadoop 用户下查看 HDFS 是否有这些路径:

$ hadoop dfs -ls /

没有发现上面提到的路径,因此我们需要自己新建这些目录,并且给它们赋予用户写(W)权限。

$ hadoop dfs -mkdir /user/hive/warehouse $ hadoop dfs -mkdir /tmp/hive $ hadoop dfs -chmod 777 /user/hive/warehouse $ hadoop dfs -chmod 777 /tmp/hive

如果你遇到 no such file or directory 类似的错误,就一步一步新建目录,例如:

$ hadoop dfs -mkdir /tmp $ hadoop dfs -mkdir /tmp/hive

检查是否新建成功 hadoop dfs -ls / 以及 hadoop dfs -ls /user/hive/ :

(3)修改 io.tmpdir 路径

同时,要修改 hive-site.xml 中所有包含 ${system:Java.io.tmpdir} 字段的 value 即路径(vim下 / 表示搜索,后面跟你的关键词,比如搜索 hello,则为 /hello , 再回车即可),你可以自己新建一个目录来替换它,例如 /home/hive/iotmp . 同样注意修改写权限。如果不修改这个,你很可能会出现如下错误

(4)

初始化

:/schematool -initSchema -dbType derby

运行 Hive

./hive

前面我们已经提到过,内嵌模式使用默认配置和 Derby 数据库,所以无需其它特别修改,先 ./start-all.sh 启动 Hadoop, 然后直接运行 hive:

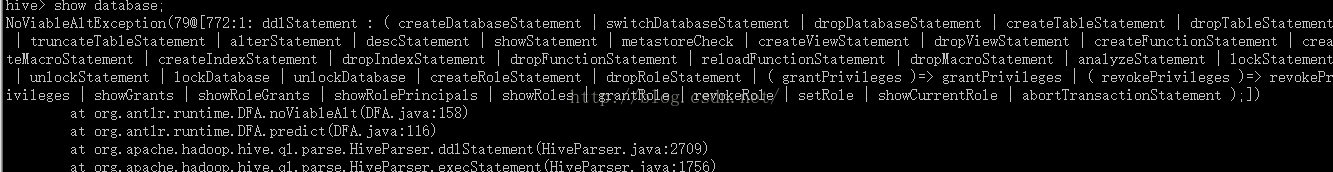

报错

解决方法:

create table test_table(id INT, username string);

show tables;

五、远程模式

1.配置

vim hive-site.xml

<?xml version="1.0"?><configuration>

<property> <name>javax.jdo.option.ConnectionURL</name><value>jdbc:mysql://{ip:port}/{databases}</value> </property><property><name>javax.jdo.option.ConnectionDriveName</name><value>com.mysql.jdbc.Driver</value></property><property><name>javax.jdo.option.ConnectionUserName</name><value>{username}</value></property><property><name>javax.jdo.option.ConnectionPassword</name><value>{password}</value></property><property><name>hive.metastore.warehouse.dir</name><value>/hive/warehouse</value> </property></configuration>

初始化

./schematool -dbType mysql -initSchema

2.启动metastore

./hive --service metastore &

默认端口 9083

在debug模式下开启metastore :

执行hive --service metastore -hiveconf hive.root.logger=DEBUG,console

3.启动HiveServer2

默认端口:10000

./hive --service hiveserver2 &

4.启动客户端

./hive -- service cli

5.启动shell 或是 beeline

./beeline -u jdbc:hive2://app:10000/default

六.配置spark为默认引擎

hive使用spark有严格的版本限制, Hive根pom.xml的<spark.version>定义了使用它构建/测试的Spark的版本

版本不对会报如下错误:

FAILED: Execution Error, return code 1 from org.apache.hadoop.hive.ql.exec.spark.SparkTask

第一种方法

1.要将Spark依赖项添加到Hive

在Hive 2.2.0之前,将spark-assembly jar链接到HIVE_HOME / lib

2.配置Hive执行引擎使用Spark:

Hive-site.xml配置

<property>

<name>hive.execution.engine</name>

<value>Spark</value>

</property>

第二种方法

配置hive-site.xml

<property><name>spark.home</name><value>spark-without-hive</value></property>

七、Java客户端

1.默认用户名和密码为空

2.默认端口10000,如果连不上须关闭防火墙

vim /etc/sysconfig/iptables

-A INPUT -p tcp -m state --state NEW -m tcp --dport 10000 -j ACCEPT

service iptables restart

错误

org.apache.hive.service.cli.HiveSQLException: Failed to open new session: java.lang.RuntimeException: org.apache.hadoop.ipc.RemoteException(org.apache.hadoop.security.authorize.AuthorizationException): User: root is not allowed to impersonate anonymous

at org.apache.hive.jdbc.Utils.verifySuccess(Utils.java:264)

at org.apache.hive.jdbc.Utils.verifySuccess(Utils.java:255)

at org.apache.hive.jdbc.HiveConnection.openSession(HiveConnection.java:593)

at org.apache.hive.jdbc.HiveConnection.<init>(HiveConnection.java:172)

at org.apache.hive.jdbc.HiveDriver.connect(HiveDriver.java:107)

at java.sql.DriverManager.getConnection(Unknown Source)

at java.sql.DriverManager.getConnection(Unknown Source)

at com.car.test.HiveJdbcCli.getConn(HiveJdbcCli.java:156)

at com.car.test.HiveJdbcCli.main(HiveJdbcCli.java:35)

解决方法:

修改hadoop 配置文件 etc/hadoop/core-site.xml,加入如下配置项

-

<property> <name>hadoop.proxyuser.root.hosts</name> <value>*</value> </property> <property> <name>hadoop.proxyuser.root.groups</name> <value>*</value> </property>

重启hadoop

测试:./beeline -u 'jdbc:hive2://localhost:10000/userdb' -n username(替换为上述的用户名部分)

错误

java.sql.SQLException: org.apache.thrift.transport.TTransportException: SASL authentication not complete

at org.apache.hive.jdbc.HiveStatement.closeClientOperation(HiveStatement.java:211)

at org.apache.hive.jdbc.HiveStatement.close(HiveStatement.java:228)

at com.car.test.HiveJdbcCli.main(HiveJdbcCli.java:74)

Caused by: org.apache.thrift.transport.TTransportException: SASL authentication not complete

解决办法:

This is because the thrift server is expecting to authenticate via SASL when you open your transport connection. Hive Server 2 defaults to using SASL - unfortunately, PHP lacks a version of TSaslClientTransport (which is used as a wrapper around another TTransport object) which handles the SASL negotiation when you open your transport connection.

The easiest solution for now is to set the following property in your hive-site.xml

<property><name>hive.server2.authentication</name><value>NOSASL</value></property>