在前面的博文中,已完成了在tomcat中对solr的部署,为solr添加了一个自定义的core,并且引入了ik分词器。

那么该如何将本地的mysql的数据导入到solr中呢?

准备工作:

1、mysql数据源:myuser库中的user表(8条数据),其中这个updateTime字段是用于solr更新数据库数据的依据,表中必须得有这个字段。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

|

/*

Navicat MySQL Data Transfer

Source Server : localhost

Source Server Version : 50521

Source Host : localhost:3306

Source Database : user

Target Server Type : MYSQL

Target Server Version : 50521

File Encoding : 65001

Date: 2016-10-21 10:14:01

*/

SET FOREIGN_KEY_CHECKS=0;

-- ----------------------------

-- Table structure for user

-- ----------------------------

DROP TABLE IF EXISTS `user`;

CREATE TABLE `user` (

`id` int(11) NOT NULL AUTO_INCREMENT,

`name` varchar(255) NOT NULL,

`password` varchar(255) NOT NULL,

`updateTime` datetime DEFAULT NULL,

PRIMARY KEY (`id`)

) ENGINE=InnoDB AUTO_INCREMENT=10 DEFAULT CHARSET=utf8;

-- ----------------------------

-- Records of user

-- ----------------------------

INSERT INTO `user` VALUES ('1', '张三', 'abc', '2016-10-21 10:10:58');

INSERT INTO `user` VALUES ('2', '李四', 'def', '2016-10-21 10:10:58');

INSERT INTO `user` VALUES ('3', '王五', 'ghi', '2016-10-21 10:10:58');

INSERT INTO `user` VALUES ('4', '赵六', 'jkl', '2016-10-21 10:10:58');

INSERT INTO `user` VALUES ('5', '田七', 'mno', '2016-10-21 10:10:58');

INSERT INTO `user` VALUES ('6', '老八', 'pqr', '2016-10-21 10:10:58');

INSERT INTO `user` VALUES ('7', '金九', 'stu', '2016-10-21 10:10:58');

INSERT INTO `user` VALUES ('8', '银十', 'vwx', '2016-10-21 10:10:58');

|

2、数据源配置文件:新建文件:data-config.xml,文件内容如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

<

dataConfig

>

<

dataSource

type

=

"JdbcDataSource"

driver

=

"com.mysql.jdbc.Driver"

url

=

"jdbc:mysql://localhost:3306/myuser"

user

=

"root"

password

=

"root"

batchSize

=

"100"

/>

<

document

>

<

entity

name

=

"user"

pk

=

"id"

query

=

"SELECT id,name,password,updateTime FROM user"

deltaImportQuery

=

"SELECT id,name,password,updateTime FROM user where id='${dataimporter.delta.id}'"

deltaQuery="SELECT id FROM user where updateTime > '${dataimporter.last_index_time}'">

<

field

column

=

"id"

name

=

"id"

/>

<

field

column

=

"name"

name

=

"name"

/>

<

field

column

=

"password"

name

=

"password"

/>

<

field

column

=

"updateTime"

name

=

"updateTime"

/>

</

entity

>

</

document

>

</

dataConfig

>

|

3、mysql驱动jar包和solr导入数据所需的jar包:mysql-connector-java-5.1.32.jar(这个大家都有) 和 solr-dataimporthandler-4.10.2.jar(这个在solr-4.10.2\dist目录下可以找到,复制出来一个即可)

====================================================================================

准备工作完成之后就可以进行配置和操作了。

步骤一:将刚才准备的那两个jar包复制到apache-tomcat-7.0.72\webapps\solr\WEB-INF\lib目录下。

步骤二:将准备的data-config.xml文件复制到solrhome\simple\conf目录下,和schema.xml同一目录。

步骤三:在solrhome\simple\conf目录下找到solrconfig.xml文件,为该文件添加如下内容:

|

1

2

3

4

5

6

|

<

requestHandler

name

=

"/dataimport"

class

=

"org.apache.solr.handler.dataimport.DataImportHandler"

>

<

lst

name

=

"defaults"

>

<

str

name

=

"config"

>data-config.xml</

str

>

</

lst

>

</

requestHandler

>

|

步骤四:在solrhome\simple\conf目录下找到schema.xml文件,打开并修改如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

|

<?

xml

version

=

"1.0"

encoding

=

"UTF-8"

?>

<

schema

name

=

"example"

version

=

"1.5"

>

<!--定义type类型-->

<

types

>

<

fieldType

name

=

"string"

class

=

"solr.StrField"

sortMissingLast

=

"true"

/>

<

fieldType

name

=

"long"

class

=

"solr.TrieLongField"

precisionStep

=

"0"

positionIncrementGap

=

"0"

/>

<

fieldType

name

=

"int"

class

=

"solr.TrieIntField"

precisionStep

=

"0"

positionIncrementGap

=

"0"

/>

<

fieldType

name

=

"date"

class

=

"solr.TrieDateField"

precisionStep

=

"8"

positionIncrementGap

=

"0"

/>

<

fieldType

name

=

"text_ik"

class

=

"solr.TextField"

>

<

analyzer

class

=

"org.wltea.analyzer.lucene.IKAnalyzer"

/>

</

fieldType

>

</

types

>

<!--定义字段-->

<

fields

>

<

field

name

=

"_version_"

type

=

"long"

indexed

=

"true"

stored

=

"true"

/>

<

field

name

=

"_root_"

type

=

"string"

indexed

=

"true"

stored

=

"false"

/>

<

field

name

=

"id"

type

=

"int"

indexed

=

"true"

stored

=

"true"

required

=

"true"

multiValued

=

"false"

/>

<!--注意:这里的field中的name要和data-config.xml中的name对应-->

<!--字段为name的type类型可以是string-->

<

field

name

=

"name"

type

=

"text_ik"

indexed

=

"true"

stored

=

"true"

/>

<

field

name

=

"password"

type

=

"string"

indexed

=

"true"

stored

=

"true"

/>

<

field

name

=

"updateTime"

type

=

"date"

indexed

=

"true"

stored

=

"true"

/>

</

fields

>

<

uniqueKey

>id</

uniqueKey

>

<

solrQueryParser

defaultOperator

=

"AND"

/>

</

schema

>

|

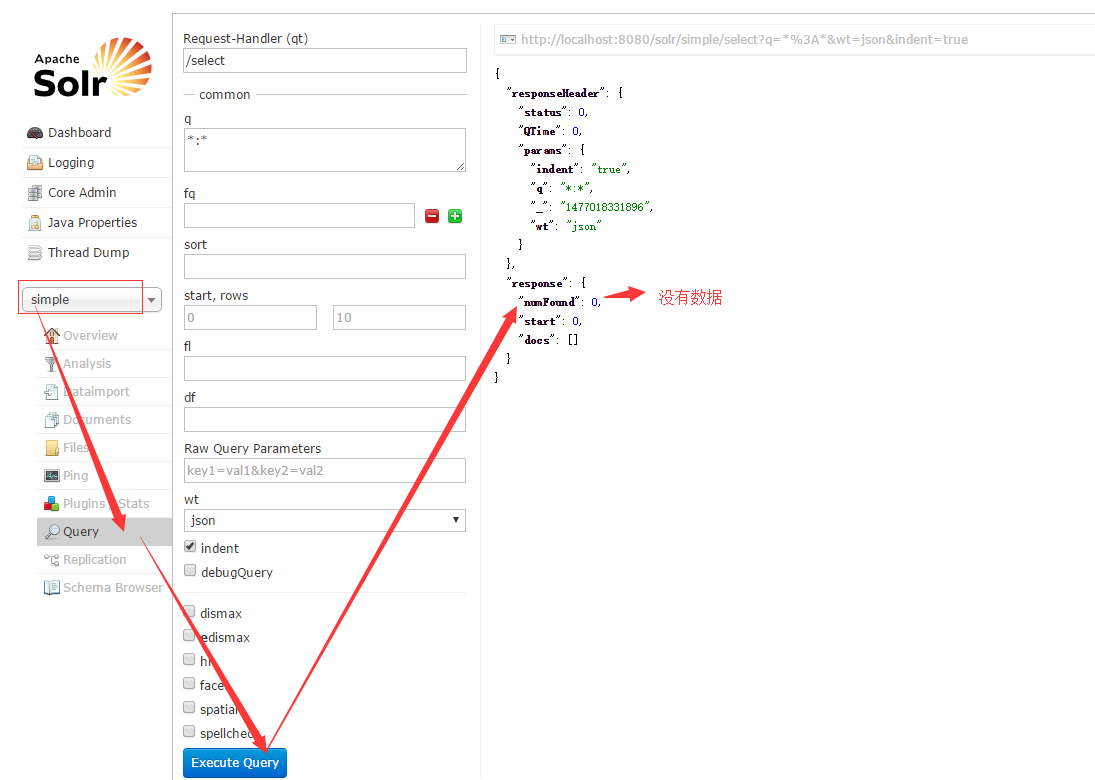

步骤四:启动tomcat,浏览器访问:locahost:8080/solr 原来的simple中数没有任何数据的。

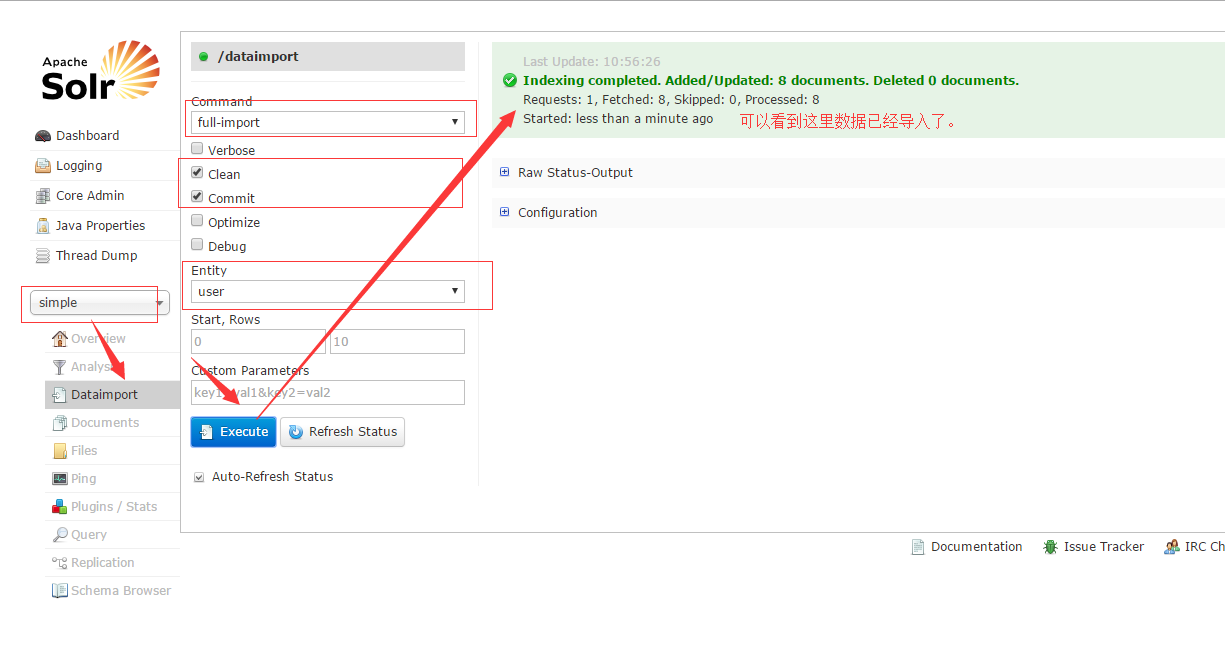

步骤五:导入mysql数据到solr中

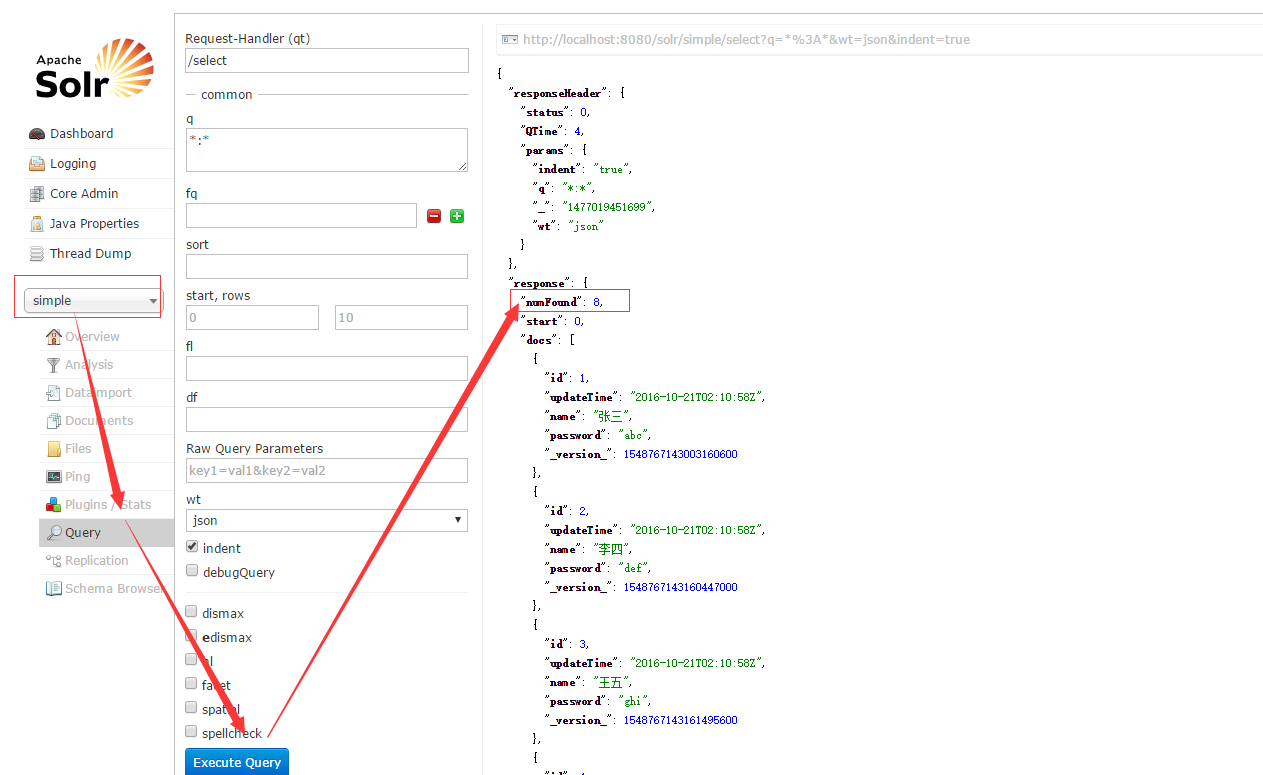

再次查看数据,如果显示如下,那么恭喜你,数据导入成功!

=====================================================================================

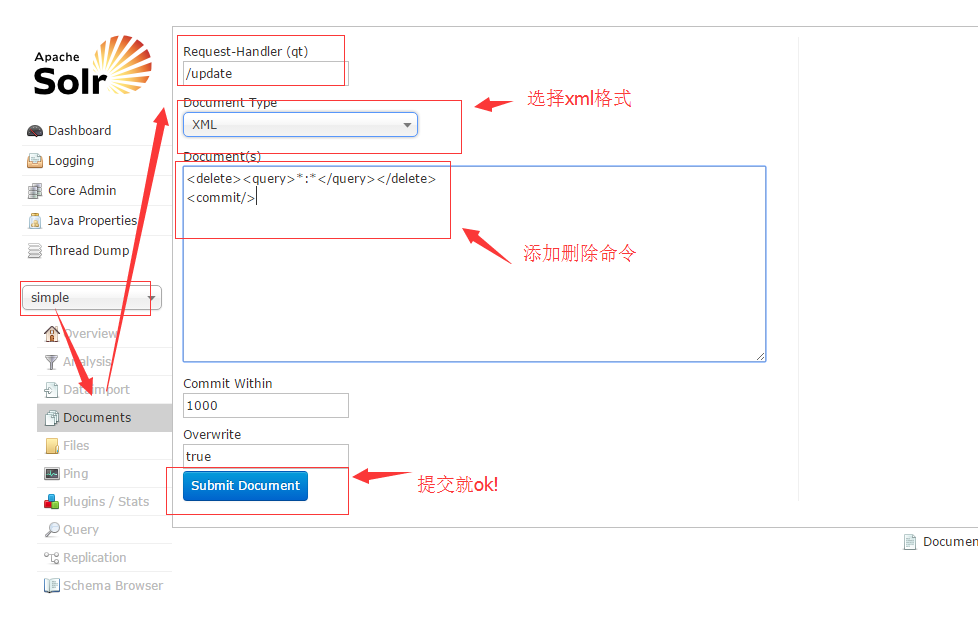

1、根据查询删除:删除所有数据

|

1

2

|

<

delete

><

query

>*:*</

query

></

delete

>

<

commit

/>

|

当然,上面说的是手动删除,如果要删除的数据很多,想在下一次自动同步数据的时候自动删除指定的数据该如何做呢?

场景:有一批要拍卖的店铺数据存储在solr中,拍卖的店铺数据有一个拍卖结束时间(endTime),当拍卖结束时间一到,这条存储在solr中的拍卖数据就没有意义了,想要删除这条存储在solr中的数据。

按照上面的手动删除也不是不可以,但这人工操作未免太扯了,到时间人工去solr中删除这条数据耗时又耗力,也不太现实。

解决办法就是:

在data-config.xml的entity中添加:

|

1

|

deletedPkQuery=

"select id from shops where endTime < NOW()"

|

这一句,这句和entiy的query同级,目的是查询出所有店铺数据中结束时间小于当前时间的店铺id,

这个店铺id会和deltaQuery中收集到的id一并执行deltaImportQuery操作,只不过一个是添加数据,一个是删除数据。

如果是其他业务场景也可以借鉴下这篇博客中在表中添加isdelete字段的方式完成删除,其实只要有一个字段能够标识就行:

参考地址:http://simplelife.blog.51cto.com/9954761/1883024

本文转自 兴趣e族 51CTO博客,原文链接:http://blog.51cto.com/simplelife/1864154