今天,谷歌联合Columbia University、Adobe(就是你们知道的那个Adobe)提出深度概率编程语言Edward,我就其发布Edward的专业论文,给大家介绍一下,这个秒天秒地秒空气的牛逼哄哄的新语言(框架)。

为什么开发Edward?

因为现在的概率编程语言啊,

Too Young!Too Simple!

原文是这样的:

Rather, most existing probabilistic programming languages treat the inference engine as a black box,abstracted away from the model. These cannot capture the recent advances in probabilistic inference that reuse the model’s representation.

就是因为如今的概率编程语言,把引擎设置为一个黑箱。

其实这是把难度降低了,毕竟我们绝大多数用Keras这类框架的人,根本不去在意这个问题。而我们这些玩弄Keras的怪蜀黍们的应对的策略也很奔放——直接把Keras的源代码撬开改!

某科技媒体上的文章,说Edward是深度概率编程语言,然而,官网是这样的:

也就是说...这...是Python库啊。。。

Python库啊。。。

至少现在看,确实是Python库的吧。。。

文档中提到,支持的模型:

也就是支持

其实我还是觉得,就神经网络而言,Keras的易用性真的是太棒了!

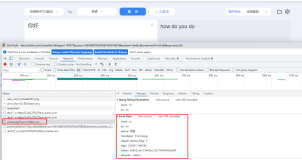

在这里提一下,想上Edward之前先看看自己的Tensorflow的版本,Tensorflow作为一个日新月异的深度学习框架,肯定有不少人表示——给老子上最新的!

所以。。。你们就要GG了。。。

我不是针对你,我是说所有想玩Edward的同时还追求Tensorflow的,都要把版本弄回来。。。

在arXiv的论文中提到:

他的效率高很多,举个例子就是:他做蒙特卡罗哈密顿方法,效率比别人高35倍

在Edward里,随机变量的地位很高,是类对象。

先科普一个常识,张量,就是Tensor,就是Tensorflow的那个Tensor,也就是多维数组。

另外,每个随机变量与张量

相关联,其表示单个样本

方法,例如以计算对数密度和该关联将随机变量嵌入到计算图形中,其中节点表示张量和边际上的操作,表示张量在它们之间通信的符号框架。

而这种设计有助于在计算图框架中开发概率程序,也是Edward堪称“语言”的地方吧。所有的计算都可以在图表上表示。这使得很容易组成具有复杂确定性结构的随机变量,比如说深层神经网络,一组不同的数学运算以及在同一框架上构建的第三方库。噢对了,这种的设计还能使随机变量的组合能够捕获复杂的随机结构。

举个例子:

随机变量是50维的,由随机张量

参数化。 获取对象运行图形:它从生成过程模拟并输出50个元素的二进制向量。

现在来实操一番:

当然了,安装的方法也是熟悉的味道。。

pip install edward

首先,定一个小目标,比如弄50个小数据

我们把y设置为一个在x附近有一丢丢摆动的正弦值。

定义一个两层贝叶斯网络,用tanh来定义非线性的神经网络

可能画出来会比较直观一点

是吧,跟段子一般的简单。接下来我们从数据反怼出模型,用边分推理对权重和偏差指定正态近似。

在这里科普一下什么是变分推理:

变分推断是一类用于贝叶斯估计和机器学习领域中近似计算复杂(intractable)积分的技术,变分推断限制近似分布的类型,从而得到一种局部的最优,但具有确定解的近似后验分布。需要提一下的是,虽然都是通过抽取大量的样本估计真实的后验分布,但是变分推断和猛上之后的蒙特卡洛方法是有大大的区别的。

在Edward中的变分推理的实现方法是酱紫的:

既然提到了Monte Carlo嘛。。。

在Edward中的Monte Carlo的实现是这样的。。。

其中,T为样本数量。

好的,那么我们就来做一个:

定义tf.Variable允许变分因子的参数变化。

它们都被初始化为0.用softplus transformation,使标准偏差参数被调整为大于零。

用Kullback-Leibler散度运行变分推理,以推断模型的给定数据的潜在变量。

科普时间到:

Kullback-Leibler散度也称为辨别信息,信息散度,信息增益,相对熵,KLIC,KL散度(我也不知道为什么名字那么的长啊长)。

它是在两个概率分布P和Q之间的差异的测量。在P和Q中不对称。P通常表示数据的“真实”分布,观察或精确计算的理论分布,而Q通常表示理论、模型、描述或近似。

我们就做个。。。1000次迭代吧?

最后,评价模型拟合水平。

贝叶斯神经网络定义了神经网络上的分布,因此我们可以执行图形检查,将模型打印出来,看看是不是和我们一开始定义的模型,也就是一个在余弦曲线上摆动有一定的摆动的图样。

显然,该模型真的已捕获观察域中x和y之间的余弦关系。

即,模型拟合通过。

原则上,就这么简单的通过了,但是Edward在安装的时候确实废了我不少心血,同时在调整模型的时候屡次GG,觉得。。。虽然它是个很棒的工具,从效率上来看(至少官方公布的效率,绝对是扛把子级别的)

原文发布时间为:2017-01-23

本文作者:那只猫

本文来自云栖社区合作伙伴“Python中文社区”,了解相关信息可以关注“Python中文社区”微信公众号