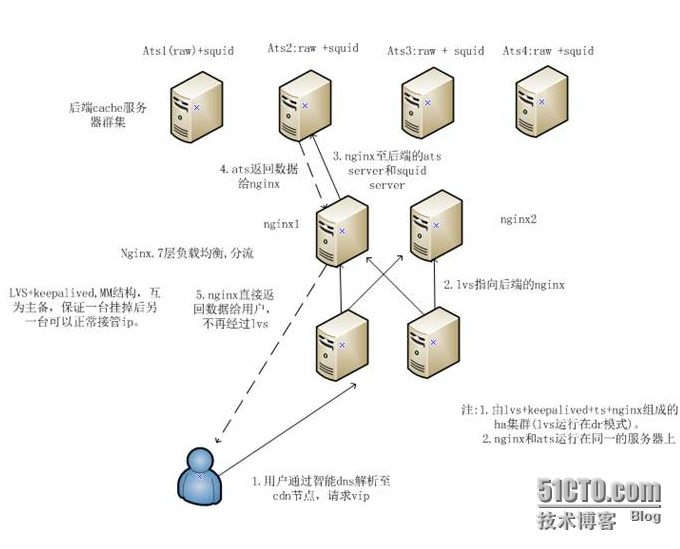

cdn内部结构

2015-01-07

1273

版权

版权声明:

本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《

阿里云开发者社区用户服务协议》和

《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写

侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

简介:

转载自:http://caiguangguang.blog.51cto.com/1652935/1371949之前在设计自建cdn的内部结构时写的一些文字,简单贴下。

目录

相关文章

|

边缘计算

缓存

监控

【CDN 排查方案-1】认识 CDN 网络调优

面向不同业务类型的网站,很多人都选择了 CDN 加速来优化自己的网站,目的在于加速网民的体验效果,赢取流量。 在网站调优的过程中,如果正确理解基于 CDN 的网络调优以及正确的配合 CDN 服务方来快速提供调优信息做了详细的讲解, 希望对大家有用,希望对从事 CDN 的人和对网络调优感兴趣的人能有作用。

464

0

0

|

3月前

|

缓存

前端开发

API

|

5月前

|

SQL

缓存

网络安全

|

缓存

运维

负载均衡

|

JavaScript

CDN

|

存储

CDN

热门文章

最新文章

1

随机生成UserAgent的python库(fake-useragent库)

2

使用zxing识别一幅包含多个二维码的图片

3

阿里云的SLB,植入cookie和重写cookie有什么区别?

4

基于Flink的实时日志分析系统实践

5

如何在服务器上跑python程序

6

电池技术多年没有较大发展,成为移动设备最大制约

7

Spread for WinRT 7新功能使用指南

8

codeforces Soldier and Number Game(dp+素数筛选)

9

九度oj-1001-Java

10

Android:随笔——对页面的View进行截图

1

分解商业周期时间序列:线性滤波器、HP滤波器、Baxter滤波器、Beveridge Nelson分解等去趋势2

9

2

分解商业周期时间序列:线性滤波器、HP滤波器、Baxter滤波器、Beveridge Nelson分解等去趋势法1

9

3

灰色关联分析(Grey Relation Analysis,GRA)中国经济社会发展指标

9

4

极值分析:分块极大值BLOCK-MAXIMA、阈值超额法、广义帕累托分布GPD拟合降雨数据时间序列

9

5

GARCH-DCC模型和DCC(MVT)建模估计

8

6

ARIMA、ARIMAX、 动态回归和OLS 回归预测多元时间序列

10

7

R语言预测期货波动率的实现:ARCH与HAR-RV与GARCH,ARFIMA模型比较

10

8

spss modeler用决策树神经网络预测ST的股票

9

9

K-means和层次聚类分析癌细胞系微阵列数据和树状图可视化比较

8

10

matlab中使用VMD(变分模态分解)对信号去噪

8