异步并发执行:

CUDA将以下操作公开为可以相互并行操作的独立任务:

1:在主机上计算;

2:在设备上计算;

3:内存从主机传输到设备;

4:内存从设备传输到主机;

5:内存在给定设备的内存中传输;

6:内存在设备间传输。

这些操作之间实现的并发级别将取决于设备的功能集和计算能力,如下所述:

主机和设备之间的并行执行:

通过在设备完成所请求的任务之前将控制权返回给主机线程的异步库函数来简化并行主机的执行。 在适当的设备资源可用的情况下,使用异步调用,可以将许多设备操作排队在一起以便由CUDA驱动程序执行。 这减轻了管理设备的许多责任的主线程,使其免于其他任务。 以下设备操作对于主机是异步的:

1:内核启动;

2:在单个设备的内存中复制;

3:内存从64 KB或更少的内存块的主机复制到设备;

4:使用Async后缀的函数执行内存拷贝;

5:内存设置函数调用

编程人员可以通过将CUDA_LAUNCH_BLOCKING环境变量设置为1来全局禁用运行在系统上的所有CUDA应用程序的内核启动的异步性。此功能仅用于调试目的,不应用作使生产软件可靠运行的方式.

并发内核执行:

计算能力2.x和更高的一些设备可以同时执行多个内核。 应用程序可以通过检查concurrentKernels设备属性(请参阅设备枚举)来查询此功能,对于支持它的设备,该属性等于1。

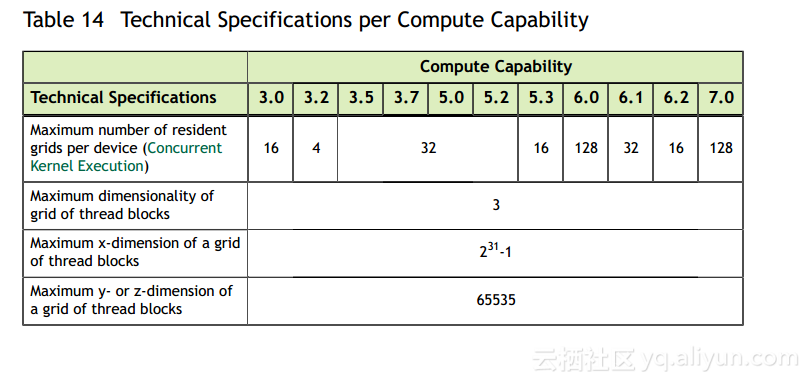

设备可同时执行的最大内核启动数取决于其计算能力,如表14所示:

来自一个CUDA上下文的内核不能与来自另一个CUDA上下文的内核同时执行。

使用许多纹理或大量本地内存的内核不太可能与其他内核同时执行。

数据传输和内核执行的重叠:

一些设备可以在内核执行的同时与GPU执行异步内存拷贝。 应用程序可以通过检查asyncEngineCount设备属性来查询此功能,对于支持它的设备,该属性大于零。 如果主机内存涉及副本,则必须进行页面锁定。

也可以在内核执行的同时(在支持concurrentKernels设备属性的设备上)或在设备上执行设备内拷贝(对于支持asyncEngineCount属性的设备)。 使用标准的存储器复制功能来初始化复制,其中目标和源地址驻留在同一设备上。

并发数据传输:

计算能力2.x及更高版本的某些设备可以与设备之间的拷贝重叠。 应用程序可以通过检查asyncEngineCount设备属性来查询此功能,对于支持该设备的设备,该属性等于2。 为了重叠,传输中涉及的任何主机内存必须为页锁定内存。

CUDA学习(十一)

2018-02-08

1237

版权

版权声明:

本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《

阿里云开发者社区用户服务协议》和

《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写

侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

简介:

目录

相关文章

|

11月前

|

缓存

并行计算

API

|

并行计算

Linux

程序员

CUDA学习(九十二)

2042

0

0

|

并行计算

异构计算

CUDA学习(九十四)

2126

0

0

|

并行计算

异构计算

数据管理

CUDA学习(九十五)

2386

0

0

|

并行计算

CUDA学习(二十四)

1411

0

0

|

并行计算

CUDA学习(十二)

1649

0

0

|

并行计算

CUDA学习(十四)

2167

0

0

|

并行计算

CUDA学习(十五)

3788

0

0

|

并行计算

API

异构计算

CUDA学习(十七)

1488

0

0

热门文章

最新文章

1

随机生成UserAgent的python库(fake-useragent库)

2

使用zxing识别一幅包含多个二维码的图片

3

阿里云的SLB,植入cookie和重写cookie有什么区别?

4

基于Flink的实时日志分析系统实践

5

如何在服务器上跑python程序

6

电池技术多年没有较大发展,成为移动设备最大制约

7

Spread for WinRT 7新功能使用指南

8

codeforces Soldier and Number Game(dp+素数筛选)

9

九度oj-1001-Java

10

Android:随笔——对页面的View进行截图

1

分解商业周期时间序列:线性滤波器、HP滤波器、Baxter滤波器、Beveridge Nelson分解等去趋势2

9

2

分解商业周期时间序列:线性滤波器、HP滤波器、Baxter滤波器、Beveridge Nelson分解等去趋势法1

9

3

灰色关联分析(Grey Relation Analysis,GRA)中国经济社会发展指标

9

4

极值分析:分块极大值BLOCK-MAXIMA、阈值超额法、广义帕累托分布GPD拟合降雨数据时间序列

9

5

GARCH-DCC模型和DCC(MVT)建模估计

8

6

ARIMA、ARIMAX、 动态回归和OLS 回归预测多元时间序列

10

7

R语言预测期货波动率的实现:ARCH与HAR-RV与GARCH,ARFIMA模型比较

10

8

spss modeler用决策树神经网络预测ST的股票

9

9

K-means和层次聚类分析癌细胞系微阵列数据和树状图可视化比较

8

10

matlab中使用VMD(变分模态分解)对信号去噪

8