IPoIB

Internet Protocol over InfiniBand

就是指利用物理IB网络(IB卡,线缆,交换机,更甚者IB3层交换)通过ip协议进行连接,并进行数据传输!

SDP

Sockets Direct Protocol由InfiniBand行业协会trade Association软件工作组指定,主要是针对InfiniBand架构.

SDP利用IB卡的RDMA特性进行数据的高速传输,低延迟数据交换,推广到iWARP Internet Wide Area RDMA Protocol.

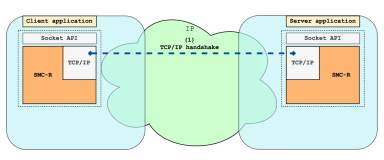

SDP使用RDMA网络特性能够高效的进行零拷贝的数据传输,SDP协议设计的目的是为了使得应用程序能够透明的使用IB卡的RDMA(Remote Direct Memory Access)通信机制来加速传统的TCP/IP网络通信.

在InfiniBand上的SDP协议实现即SDPoIB

solsris Unix均提供SDP支持,在Microsoft windows中则可以使用Winsock Direct 子系统来实现SDP

SDPoIB主要是针对流的套接字通信,使用SDPoIB进行通信的应用,可以绕过操作系统本身的TCP协议栈,之间利用IB卡硬件的RDMA能力进行通信,基于数据包的通信像UDP等则由IPoIB来进行支持,SDPoIB可以依赖IPoIB来进行地址解析等工作.

Roce(RDMA over Converged EtherNet)

http://en.wikipedia.org/wiki/RDMA_over_Converged_Ethernet

R-NIC

Rdma-aware Network Interface Controller

IE-TF

互联网工程任务组(Internet Engineering Task Force)