在人工智能的大背景下,这几年,说起芯片霸主英特尔,似乎总有一股时过境迁的味道。但是,“关于芯片霸主这个问题,判断是不是具有领先性,既不能看近期的市场营收,也不能只看媒体曝光的热度,应该要从一个长时期来看这家企业在整个芯片市场上的技术领先程度、对于下游厂商的支持程度,以及驱动整个生态系统的能力。”

英特尔中国研究院院长宋继强说:“打个比方,如果一家芯片公司退出市场,这个世界会怎么样?大家可以想一下,有什么样的芯片企业是这个世界不能缺少的。”

明年就是英特尔成立第50周年了。日前,“英特尔中国研究院开放日”时隔两年再次在北京举行,英特尔中国研究院院长宋继强率领团队,共同分享了英特尔中国研究院的整体定位、研究方向和创新机制,以及英特尔在人工智能、机器人等领域的最新研究成果。

没有做好的事情不对外说,流水线式的研究成果转化流程

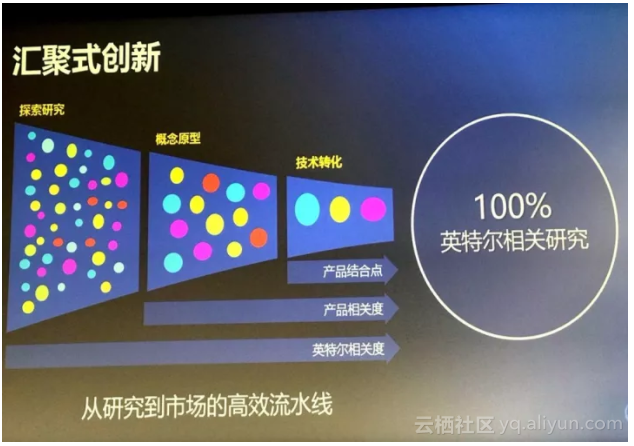

作为英特尔在海外设立的三个地区性研究机构之一,英特尔中国研究院(Intel Labs China, ILC)将自身定位于世界一流的工业研究院,6大团队——机器人系统研究实验室、机器人交互研究实验室、认知计算实验室、智能存储实验室、通讯架构实验室和新技术中心,大约60位正式研究员,联合大批博士后、实习生与合作伙伴,执行着从研究到市场的高效流水线。

研究成果转化流水线

英特尔中国研究院与世界各地的大学合作

英特尔中国研究院院长宋继强说:“我们的指标是突破性的技术,这些技术能够真正应用到产品当中去,改变现在一些产品的技术状态。”

宋继强说:“我们现在关注几个点:一是视觉理解的技术,从感知到认知;二是人机交互,因为我们相信按照贝尔定律,下一代计算机类别一定不是按照触摸的方式跟人交互,而是泛在的,存在于生活当中的方方面面,各种人机交互的方式都有可能;三是5G+无线通信;四是智能存储,这是我们内部很重要的研究方向,而且对于英特尔未来在存储领域的产品和商业价值非常大。”

英特尔中国研究院院长宋继强介绍研究院定位及最新成果

英特尔研究院认为智能计算是一个绝对的潮流,因此在先进算法、神经拟态芯片、自主系统和量子计算这几大智能计算的核心组成部分都有大量投入。而英特尔中国研究院聚焦自主系统相关的关键技术,包括人工智能算法、自主系统平台和智能基础设施。

对应这三大方面,在媒体开放日上,英特尔中国研究院研究员展示了他们在视觉理解和认知相关的技术以及产品方面的进展。机器人方面展示了HERO智能机器人异构开发平台。无线技术方面展示了用移动边缘计算做高清全景图像采集和无线VR显示技术。此外,还重点介绍了英特尔研究院总部研发的神经拟态计算芯片LOIHI。

先进AI算法:布局视觉理解和认知,抢滩3D人脸分析,百倍DNN模型无损压缩性能推进产品部署

英特尔中国研究员介绍,英特尔的人脸分析及情感识别技术,经历了从二维到三维到多模态的发展过程。2011年,英特尔开始从事人脸分析技术研究,7年的时间里,大概申请了20多个国际专利,这一系列的技术影响了多个硬件和软件产品的开发及相关应用。“我们的人脸检测技术用在了英特尔的集成显卡中,作为硬件功能被集成。我们的人脸识别技术,面部关键点跟踪检测以及人脸表情识别技术,用在了英特尔实感技术SDK集成,大家熟知的RealSense SDK。”

2015年,英特尔中国研究院基于密集人脸关键点检测和跟踪技术,开发了一套人脸美化技术,属于人脸美化技术的早期开发者。“我们的技术跟现在市场上主流的技术不一样的地方在于,除了处理皮肤,比如说磨皮、亮化,我们还加入了一些几何上的处理,基于密集的人脸关键点技术,我们可以去让人的脸形变成你想要的形式,把眼睛变得更大,把鼻子变得更挺,等等。”

最近两三年,英特尔中国研究院开始从事三维人脸技术的研究。“三维人脸技术的门槛非常高,目前国际上有几个非常著名的研究组在做,基本上处于垄断的地位,不是说轻易花3个月请几个人就能做出来的。”英特尔中国研究院的研究员用了3年多的时间,建立了自己的3D人脸分析引擎。

在这个引擎的基础上,利用机器学习和深度学习算法,开发了英特尔3D人脸面部表情捕捉技术,对视频图像进行智能分析与3D建模,不仅可以检测与识别人脸,还能精准重建3D人脸,并实时跟踪面部表情变化,将预先设计好的特效素材附着在3D人脸上并叠加到视频中,实现脸部特效。

实时3D面部表情捕捉及渲染

除了3D人脸分析,英特尔中国研究院同时也在做多模态的人脸情感分析。英特尔中国研究员介绍:“一个注意外部影响的公司,可能不会轻易多次参加同一个竞赛,因为夺冠后再参赛很可能会失去冠军的地位,这种影响可能很多人无法承受。”

而英特尔中国研究院连续三年参加ACM ICMI举办的自然环境下情感识别挑战赛(EmotiW),两次获得冠军(2015、2017),2016年虽然获得亚军,但算法的速度是第二名团队的100倍以上,每秒处理2000到3000帧,可用于无人驾驶场景,由此获得了当年最有影响力论文奖。

目前,这套技术正在由英特尔AI团队产品化,应用到英特尔的实感RealSense SDK里面。

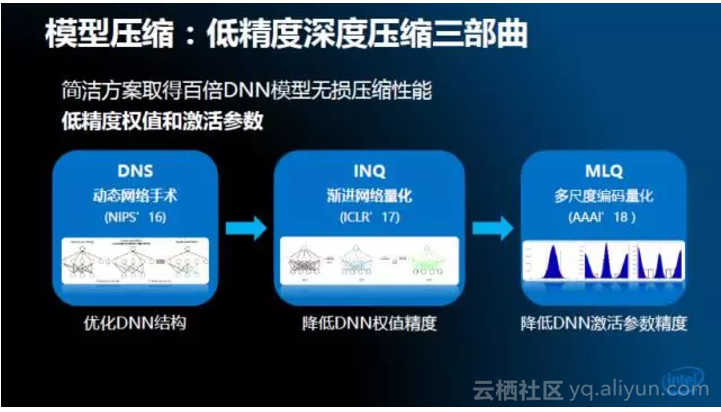

有了先进的算法和训练好的模型,如何将其部署到移动、嵌入式或便携式这些轻量级的平台,就成了接下来考虑的重点。解决方案是低精度的网络压缩。

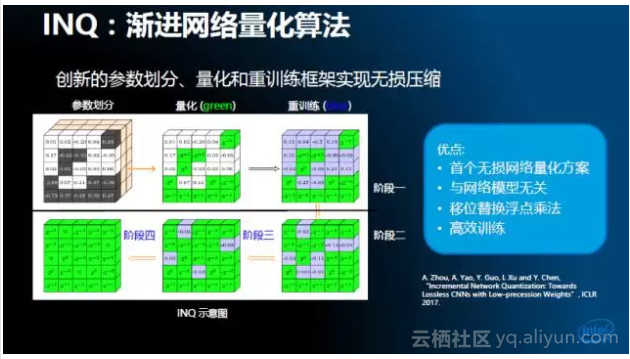

英特尔中国提出了三个相互耦合的解决技术:一是动态网络手术,二是渐进网络量化,三是多尺度编码量化。“这里最重要的一块INQ技术,渐进式网络量化方法。”英特尔中国研究员介绍:“我把一棵繁茂的树变成一棵稀疏的树必然是有损,怎么样让它无损呢?我可以先量化一部分,剩下的还依然是原来没有量化的,它可以通过重训练的方式恢复网络的精度,通过逐步的量化重训练,这样可以做到无损量化。”

三种技术相互结合,可以获得百倍DNN模型无损压缩性能,方便在边缘和嵌入式设备的部署。

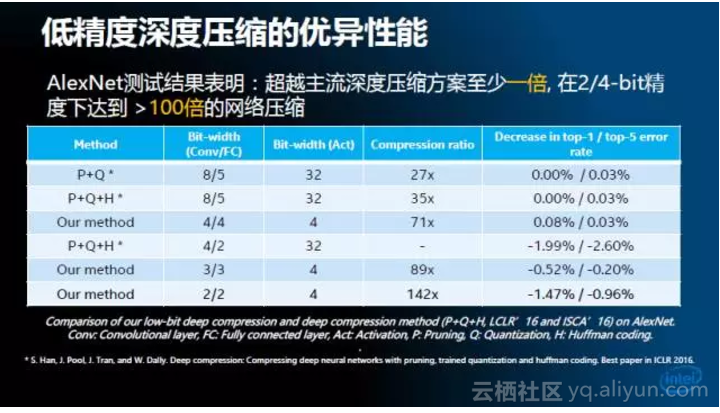

根据AlexNet测试结果,英特尔中国研究院的神经网络压缩解决方案能够超越主流深度压缩方案至少一倍,在2/4-bit精度下达到超过100倍的网络压缩

英特尔中国研究员介绍:“我们把动态网络动手术和增量化的方法进行组合,把跟目前领域内最好的解决方案进行比较。我们比较对象是2016年这篇ICLR的最佳论文,也是现在几大主要硬件公司的主要解决方案。在他们的方法里用了三个量化方法,先是剪枝,二是量化,三是编码方式。”

“而我们只用了网络动态手术和增量式量化。在同样的量化条件下,它们量化只是量化网络的参数,输入输出依然是浮点。在我们的量化里我们的输出是4bit,2的幂次方,所有的运算都不存在浮点的乘法运算。在这样的情况下,跟原始浮点的网络精度比起来,我们的网络精度依然比它高,有分类的准确率还是要高一点。跟ICLR的方法比,我们应该比它翻了一倍。”

“更进一步,如果用2对2或者2对4,2对4有什么好处,在FPGA和Asic运算里,FPGA可以把计算性能提升3倍,Asic或者一些专用的低功耗的硬件设计里能提高3到7倍的加速。在这种情况下,即使我们压缩142的时候,标准的误差评价标准下只降了1个点以内的损失,这是目前业内没有人能够超越这个性能。”

这一套技术现在影响到英特尔人工智能相关的硬件各个方面。“我们知道英特尔有FPGA,有A10和S系列,我们的方法解决方案应用到这样的平台上,它可以是一个扩展的任意一款FPGA都可以做,我们初步的把一个VGG这样1.5亿到1.2亿参数类似的网络,单幅图像可以高达到600帧。同时这个方案应用到 Movidius低功耗加速芯片下一代设计里面,还有一些其他英特尔内部的一些引擎里面。”

研究人员还展示了视觉、语言和知识融合,也即多模态图像视频解析技术。多模态的图像视频解析是最近几年兴起的新的计算机视觉研究方向。英特尔中国研究院提出了弱监督视频密集描述生成的方法,不需要训练数据对视频中的不同事件和对应区域进行分别标注,而仅仅使用标注员对视频的一句话描述,就可以自动产生多角度的视频描述,并且从中挑选出最具代表性的描述语句。

自主系统:创造机器人的“英雄”时代

机器人系统作为各种先进技术的“集大成者”,也是英特尔中国研究院的一个重点研究方向。英特尔中国研究院的目标是推出一套基于CPU+FPGA异构计算的自主智能机器人开发平台,帮助研究人员基于此平台进行开发。

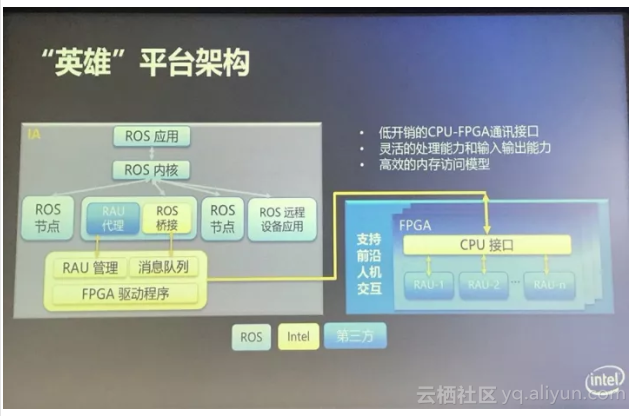

智能机器人算法和应用研究的不断演进,计算芯片需要在性能、生产率、功耗和价格等方面平衡。基于这一目标,英特尔中国研究院开发了HERO智能机器人开放平台(Heterogeneous Extensible Robot Open Platform),专为智能机器人(包括服务机器人、医疗机器人、自动驾驶汽车等)打造,可以实现多种基于FPGA加速的机器人算法,是一套低功耗、高性能、体积小的异构系统平台方案。

在此方案中,CPU作为控制中心,与FPGA和其他专用加速器芯片(如Movidius的VPU)搭配,提供高效的性能。整套HERO硬件系统采用了英特尔酷睿系列CPU,搭载英特尔Arria 10 GX系列1150型FPGA作为异构加速器,能够实时处理大量数据并运行多种智能算法。

英特尔中国研究员介绍,HERO平台的平台架构逻辑上分为两个主要的部分,左边是FPGA的计算平台,右边是通用计算平台。HERO平台要满足两个条件,一是要支持实时的交互能力,二是要支持一些新的机器人算法,进行有效的加速。

“HERO平台有三个优势:第一、两个计算组件之间的通讯开销非常低,保证实时计算的能力;第二、在处理和输入输出方面是有先天优势,因为机器人将来会要集成不同的传感器,要有很好的外设的扩展能力,同时要很灵活的对算法的计算能力进行划分。这也是必不可少的。第三、内存的访问模型也是为了支持机器学习算法,使其更灵活地应用到计算平台上,有一些算法对内存的消耗很大,有一些算法需要更加灵活的随机访问。”

在本次开放日活动上,研究人员展示了接入HERO平台的不同机器人相互配合,完成取牛奶的任务(详见下面的视频)。此外,英特尔中国研究院还宣布,围绕HERO平台推出全新的合作伙伴计划,扩展应用场景,加速技术和产品的落地。目前已经有的合作伙伴包括丰田。

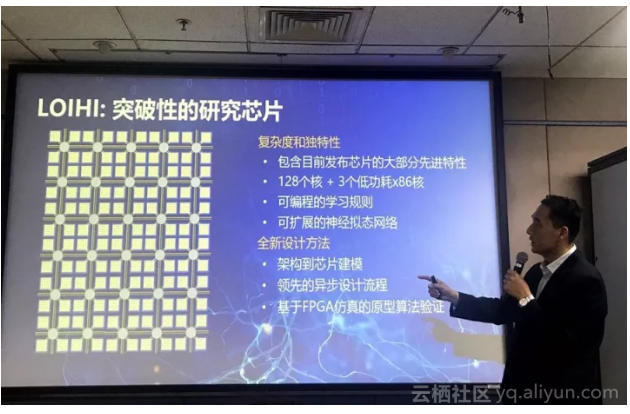

战略性基础设施:自我学习神经拟态芯片LOIHI,五年后情况将大不同

最后,院长宋继强介绍了英特尔总部研究院发布的神经拟态芯片LOIHI。

LOIHI芯片由128个计算核心组成,每个核心有1024个人工神经元,整个芯片共有超过13万个神经元和1.3亿个突触连接。采用异步计算,有需要才被激活,可以大幅降低能耗。与其他现有神经拟态芯片训练完参数就固定下来不同,LOIHI拥有“自我学习”(self-learning)的能力,它的参数在使用过程中,仍然可以通过脉冲神经网络里的脉冲传递训练去改变,在使用过程中不断改变网络模型,适应当前的状态。LOIHI可以在单个芯片上完成训练和推理,实际上,训练和推理这两个过程并没有分得那么开,这一点与人脑一样。

虽然还没有实际开发产品,但英特尔已经利用FPGA做了测试,实现了简单的路径规划和词典学习。LOIHI芯片预计今年年底面世,开放给高校和研究人员使用,模拟器也同步开放,方便编程。

从神经元数量上看,单个LOIHI芯片的神经元数量只比虾子的脑复杂一点点,距离模拟人脑复杂行为还很遥远。但是,宋继强表示,这些小的单芯片可以互相连接构成更大规模的阵列,由此模拟更大的神经元。不仅如此,LOIHI芯片直接受益于摩尔定律的发展,现在是14纳米的工艺,到了10纳米、7纳米之后会大幅提高神经元的容量。

“五年之后就会大不一样。”宋继强说。

原文发布时间为:2017-12-1

本文作者:文强

本文来自云栖社区合作伙伴新智元,了解相关信息可以关注“AI_era”微信公众号