原文出处:http://my.oschina.net/dragonblog/blog/173290

第一步:当然是安装python了,本人安装的是2.7.3版本;可以到python的官网下载然后双击运行,一路“下一步”即可完成安装。安装好后,将python的安装目录添加到系统变量中,这样才能够在控制台中输入python进入,如下图所示则说明安装python成功了

第二步:按照官网的提示,我们先安装pywin32,在http://sourceforge.net/projects/pywin32/files/这里点击进去后选择对应的版本(注意要与安装的python版本对应),下载后也是双击运行,直接下一步一路完成。

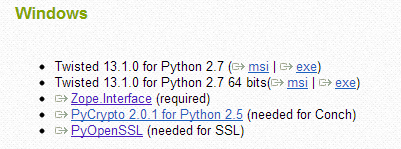

第三步:安装twisted,在其官网的下载页面中http://twistedmatrix.com/trac/wiki/Downloads可以看到其还依赖几个包

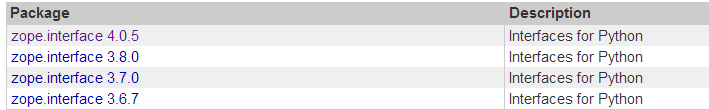

1. 安装zope.interface, 从这里https://pypi.python.org/pypi/zope.interface#download下载

我选择了4.0.5版本,点击进去后,点击download按钮即可,下载完后也是双击运行,一路下一步即可完成。

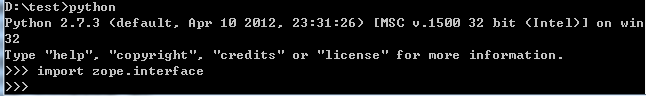

打开cmd,进入python,按照下图显示输出的话表示正确安装了

2. 安装pyopenssl, 从这里https://pypi.python.org/pypi/pyOpenSSL下载,注意要选择对应python的版本。

我选择了倒数第二个,安装成功后通过下面的方式验证:

3. 安装twisted,在下载页面http://twistedmatrix.com/trac/wiki/Downloads中我们可以看到

选择对应python的版本下载安装。

第四步:安装lxml,在这里https://pypi.python.org/pypi/lxml/下载,本人选择了3.2.3版本

官网下周lxml相当慢,可以点这个链接来直接下载http://pan.baidu.com/s/1jGHm4v0

最后一步:安装scrapy

在安装前,请先将easytool安装好

在这里http://pypi.python.org/packages/2.7/s/setuptools/setuptools-0.6c11.win32-py2.7.exe下载,安装好后,需要将python安装目录下的Scripts目录路径添加到系统变量中,因为下面就要用到。

下载scrapy,在这里https://pypi.python.org/pypi/Scrapy下载,下载完后,解压出来,运行cmd,cd到该解压目录下,在cmd中输入

easy_install Scrapy

完成scrapy的安装,然后在cmd中输入scrapy进行验证,如果出现下图所示,则说明安装成功了

到此,整个环境搭建成功!