Apache Kafka是一个分布式的、分区的、多复本的日志提交服务,使用Scala编写,以可水平扩展和高吞吐率而被广泛使用。Kafka最初是由LinkedIn开发,并于2011年初开源,目标是为实时数据处理提供一个统一、高通量、低等待的平台。目前,越来越多的开源分布式处理系统如Cloudera、Apache Storm、Spark都支持与Kafka集成。

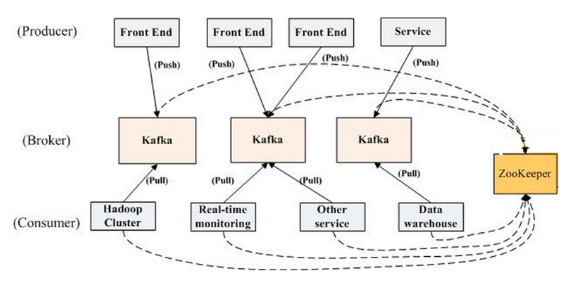

Kafka拓扑结构Kafka的设计可以帮助用户解决很多架构上的问题,其具备的高性能、低耦合、高可靠性、数据不丢失等特性,结合实际的应用系统使用场景,能够非常满足用户的需求。

8月28日,Kafka Summit大会在旧金山召开,同一天Confluent宣布Kafka新的里程碑:KSQL——用于Apache Kafka的流数据SQL引擎。KSQL(点击查看demo)是分布式、可扩展、可靠的和实时的,支持多种流式操作,包括聚合(aggregate)、连接(join)、时间窗口(window)、会话(session)等等。它为Kafka的流处理提供了一个简单而完整的SQL界面,而不需要再用编程语言(如Java或Python)编写代码。

KSQL的两个核心概念是流(Stream)和表(Table),集成流和表,允许将代表当前状态的表与代表当前发生事件的流连接在一起。

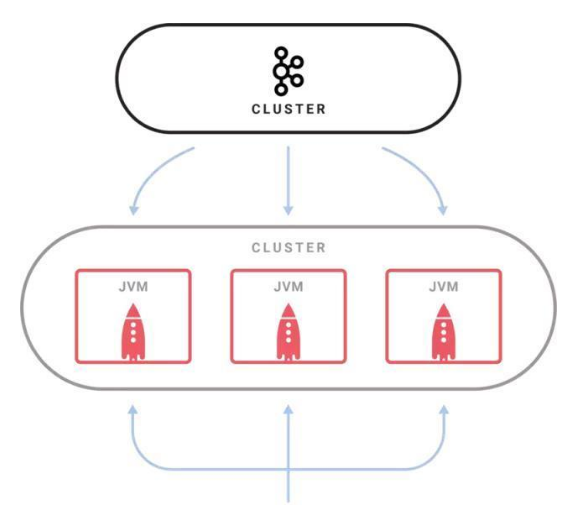

KSQL项目架构事实上,KSQL与关系型数据库中的SQL还是有很大不同的。传统的SQL都是即时的一次性操作,不管是查询还是更新都是在当前的数据集上进行。KSQL的查询和更新是持续进行的,而且数据集可以源源不断地增加。简言之,KSQL所做的其实是转换操作,也就是流式处理。

虽然项目基于Apache 2.0协议开源,但目前还处于开发者预览阶段,不建议用于生产集群中。在可预料的条件下,KSQL在实时监控、安全检测、在线数据集成、应用开发等场景拥有极大的潜力。

实时监控:通过KSQL自定义业务层面的度量指标,可以实时获得。底层的度量指标无法告诉用户应用程序的实际行为,所以基于应用程序生成的原始事件来自定义度量指标可以更好地了解应用程序的运行状况。另外,可以通过KSQL为应用程序定义某种标准,用于检查应用程序在生产环境中的行为是否达到预期;

安全检测:KSQL把事件流转换成包含数值的时间序列数据,通过可视化工具把这些数据展示在UI上,可以检测到很多威胁安全的行为,比如欺诈、入侵等等;

在线数据集成:大部分的数据处理都会经历ETL过程,而这样的系统通常都是通过定时的批次作业来完成数据处理的,但批次作业所带来的延时在很多时候是无法被接受的。通过使用KSQL和Kafka连接器,可以将批次数据集成转变成在线数据集成;

应用开发:对于复杂应用来说,使用Kafka的原生Streams API或许更合适。不过对于简单应用,或者对于不喜欢Java编程的人来说,KSQL会是更好的选择。

未来,项目计划增加更多的特性,包括支持更丰富的SQL语法,让KSQL成为生产就绪的系统。相信KSQL为处理Kafka数据而提供的简单完整的可交互式SQL接口,能够降低流式处理的门槛。

本文作者:佚名

来源:51CTO