研究人员开发出以人脑为模型的深度学习算法,来破解人类大脑。相关研究发表在最新一期Cerebral Cortex,研究人员构建了一个大脑如何解码信息的模型,根据参与者的大脑活动,该模型能够以50%的精确度预测她所看到的东西。

人工智能让我们离科幻小说里的“读脑机器”更近了一步。现在,研究人员开发出以人脑为模型的深度学习算法,来破解人类大脑。首先,他们建立了一个大脑如何解码信息的模型。三名女性花费了数小时观看几百条短视频,功能性核磁共振机器测量了视觉皮层和其他地方的活动信号。一个用于图像处理的人工神经网络学会了将视频图像和大脑活动联系起来。随着这几名女性观看更多的视频,经过算法预测的活动和一些大脑活动相吻合。它还帮助科学家了解皮层每个区域的特征。还有一个网络能够解码神经信号:根据参与者的大脑活动,能够以50%的精确度预测她所看到的东西(通过选择包括鸟类、飞机、运动等15个种类中的一个)。据研究者本月在 Cerebral Cortex 发表的报告,如果该网络从不同的女性大脑上训练数据,仍然可以达到25%的准确性。该网络也可以部分重建参与者所看到的内容,将大脑活动转化为像素,但产生的图像只是白色斑点。研究人员希望他们的工作能够重建心理图像,它使用与视觉处理相同的脑电路。从mind’s eye转换成二进制数字可以让人们对计算机或其他人表达生动的想法(无需借助语言或鼠标点击),也可以帮助那些没有其他方式进行沟通的人。

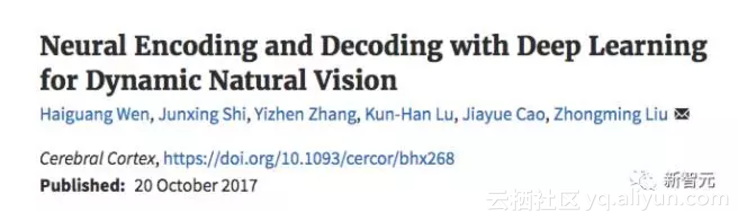

Haiguang Wen, Junxing Shi等人10月20日在 Cerebral Cortex 发表了一篇题为 Neural Encoding and Decoding with Deep Learning for Dynamic Natural Vision 的论文。

摘要:

通过图像识别驱动的卷积神经网络(CNN)已经显示能够解释腹侧流区域对静态图像的皮层反应。在这里,我们进一步表明,这种CNN能够可靠地预测和解码人们观看电影的功能性磁共振成像数据,尽管它缺乏任何机制来解释时间动态或反馈处理。使用单独的数据,编码和解码模型被开发和评估,以描述CNN和大脑之间的双向关系。通过编码模型,CNN预测区域不仅覆盖腹侧流区域,而且覆盖背部流,尽管程度较小;单体素反应被可视化为驱动反应的特定像素模式,揭示单个皮质位置的不同表示;从具有高通量的自然图像合成皮质激活,以绘制类别表示,对比度和选择性。通过解码模型,直接解码fMRI信号,以评估视觉和语义空间中的特征表示,分别用于直接视觉重建和语义分类。这些结果证实,推广和扩展以前的发现,并突出显示使用深度学习作为视觉皮质的一体化模型的价值,以了解和解码自然视觉。

解码大脑活动的新策略

几个世纪以来,哲学家和科学家一直在试图揣测、观察、理解和破译大脑的运作,使人们能够感知和探索视觉环境。在这里,我们询问大脑如何表示来自外界的动态视觉信息,以及大脑活动是否可以被直接解码,以重建和分类一个人所看到的内容。这些关于神经编码和解码的问题(Naselaris et al. 2011) 主要用静态或人为刺激来解决(Kamitani and Tong 2005; Haynes and Rees 2006) 。然而,这种策略过于狭隘,无法揭示自然的计算视力。需要一种替代策略,涵盖了视觉复杂性,以揭示和解码分布式皮质活动的视觉表示。尽管它具有多样性和复杂性,视觉世界由大量的视觉特征组成(Zeiler and Fergus 2014; LeCun et al. 2015; Russ and Leopold 2015)。这些功能涵盖了许多抽象层次,例如低级别的方向和颜色,中间层的形状和纹理,以及高级中的对象和动作。

迄今为止,深度学习提供了最全面的计算模型来编码,并从任意自然图片或视频中提取分层组织的特征(LeCun et al. 2015)。基于这种模型的计算机视觉系统模拟甚至超越了人类在图像识别和分割中的表现(Krizhevsky et al.2012; He et al. 2015; Russakovsky et al. 2015)。深层卷积神经网络(CNN)被构建和训练与前馈视觉皮质网络(DiCarlo et al. 2012; Yamins and DiCarlo 2016)类似的组织和编码原理。最近的研究表明,CNN可以部分解释大脑对(Yamins et al. 2014; Güçlü and van Gerven 2015a; Eickenberg et al. 2016)的回应和(Khaligh-Razavi and Kriegeskorte 2014; Cichy et al. 2016)自然图片刺激。然而,仍然不清楚CNN是否以及在多大程度上解释和解码大脑对自然视频刺激的反应。虽然动态自然视觉涉及前馈,反复和反馈连接(Callaway 2004),但CNN仅对前馈处理进行建模,并对瞬时输入进行操作,无需考虑反复或反馈网络交互(Bastos et al. 2012; Polack and Contreras 2012)。

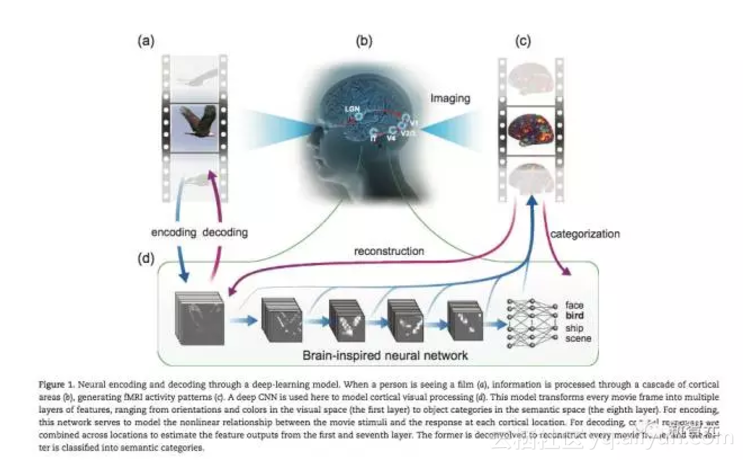

为了解决这些问题,我们从3名人类实验者中获取11.5 h的fMRI数据,他们观看了972个不同的视频片段,包括不同的场景和动作。该数据集与以前的研究不同,比之前研究样本大,覆盖更广(Khaligh-Razavi and Kriegeskorte 2014; Yamins et al. 2014; Güçlü and van Gerven,2015a; Eickenberg et al. 2016;Güçlü and van Gerven 2015a; Cichy et al. 2016)。这使得我们可以在动态观察条件下能够确认、推广和扩展CNN用于预测和解码腹侧和背侧两侧的皮层活动。具体来说,我们通过不同的数据来训练和测试了编码和解码模型,用于描述大脑和CNN之间的关系,由(Krizhevsky et al. 2012)实现。通过CNN,编码模型被用来预测和可视化给定电影刺激的个体皮层体素的fMRI反应;解码模型用于重建和分类基于fMRI活动的视觉刺激,如图1所示。主要发现如下:

- 用于图像识别的CNN解释了对几乎整个视皮层(包括其腹侧和背部流)的复杂电影刺激的fMRI反应的显着变化,尽管背侧流程度较小;

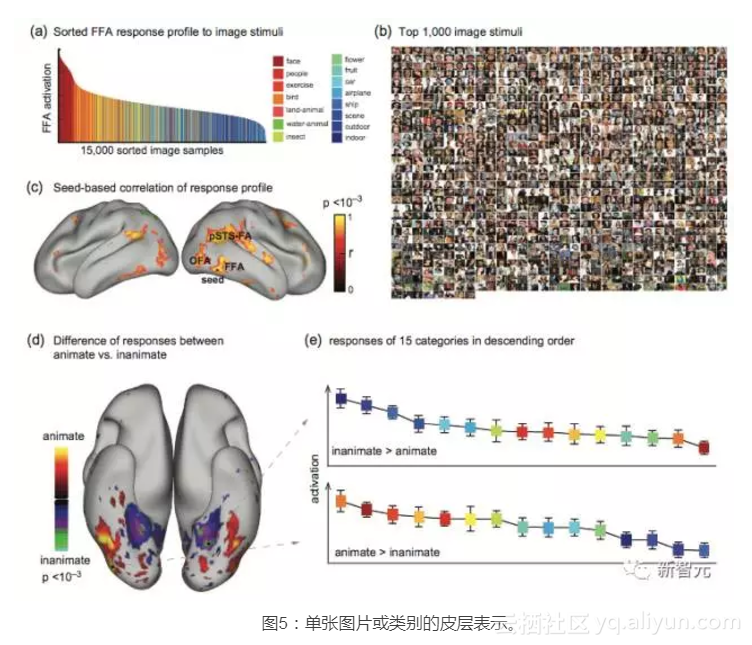

- 基于CNN的体素编码模型将不同的单体素表示可视化,并显示类别表示和选择性;

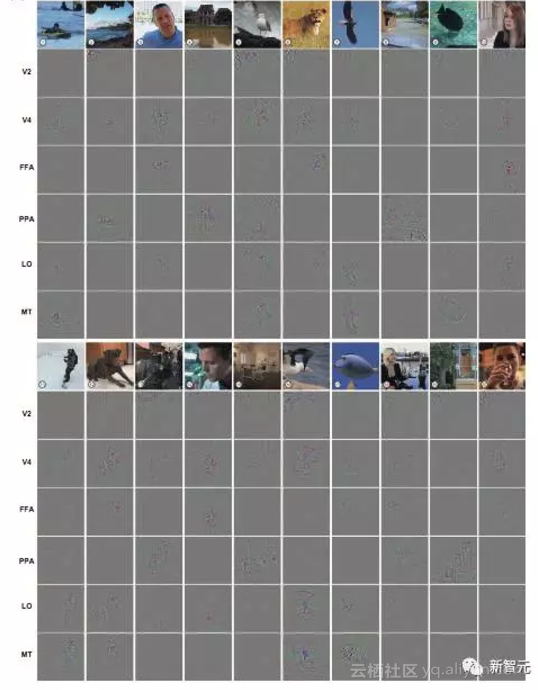

- CNN支持自然电影的直观视觉重建,突出显示模糊细节和缺失颜色的前景物体;

- CNN还支持直接语义分类,利用CNN中嵌入的语义空间。

图1:通过深度学习模型进行神经编码和解码。当一个人看到电影时(a),信息通过层叠的皮质区域(b)进行处理,产生fMRI活动模式(c)。这里使用深层CNN来建模皮质视觉处理(d)。该模型将每个电影帧转换成多层特征,从视觉空间(第一层)中的方向和颜色到语义空间中的对象类别(第八层)。

材料与方法 (详见论文)

实验结果

CNN与视觉皮层之间的功能定位

为了探索并建模CNN与大脑之间的关系,我们使用374个视频剪辑来构成一个训练电影。从训练电影中,CNN通过数十万个单元提取视觉特征,将其组织为8层,形成可训练的自下而上的网络架构。

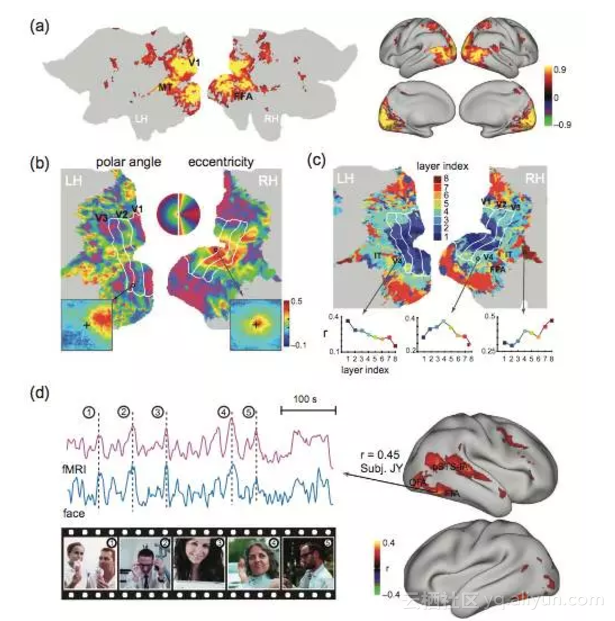

CNN中的层次结构和计算与视觉皮层中的前馈处理(Yamins and DiCarlo 2016)相似。这促使我们询问个体皮层位置是否在功能上类似于CNN中的不同单位,因为大脑和CNN都输入了一样的训练电影。为了解决这个问题,我们首先通过评估受试者在第一次和第二次观看训练电影时评估fMRI活动的体内再现性(Hasson et al. 2004; Lu et al. 2016),绘制了皮质激活。所有皮质激素在所有受试者的整个视觉皮质(图2a)上广泛存在。然后,我们检查了每个激活位置的fMRI信号与CNN中每个单元的输出时间序列之间的关系。后者指出了训练电影每一帧中特定特征的时变表现。对每个单位的特征时间序列进行对数变换,并与HRF进行卷积,然后计算其与每个体素的fMRI时间序列的相关性。

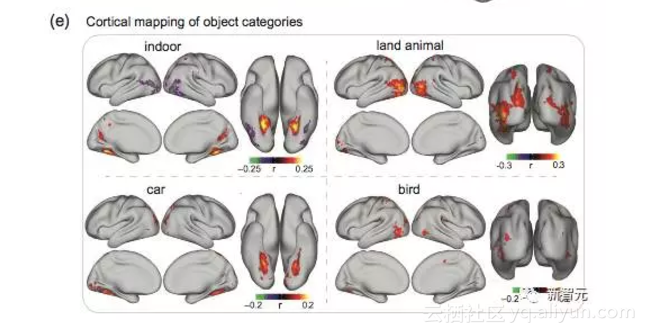

图2: 视觉皮层和CNN的功能定位(a)皮层激活(b)“视网膜定位”(c)“分层映射”(d)“大脑中的FFA和CNN中的”面部“单位的共同激活。(e)“其他4类皮层映射”。

神经编码

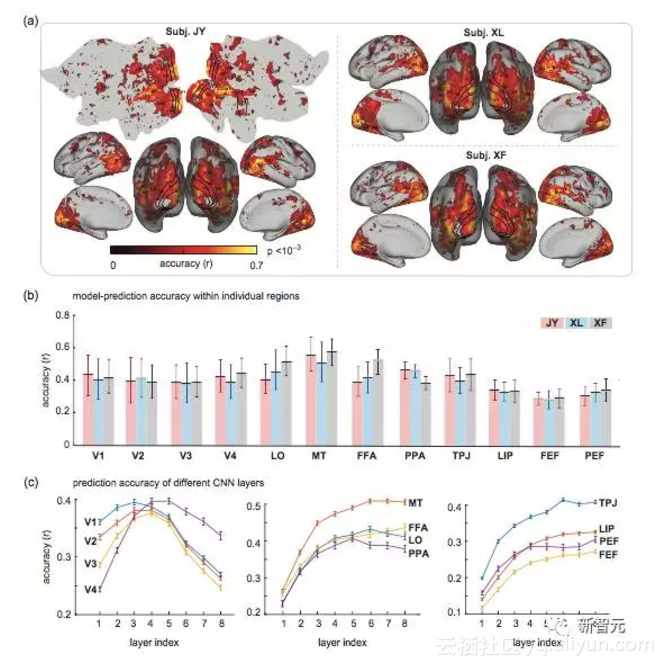

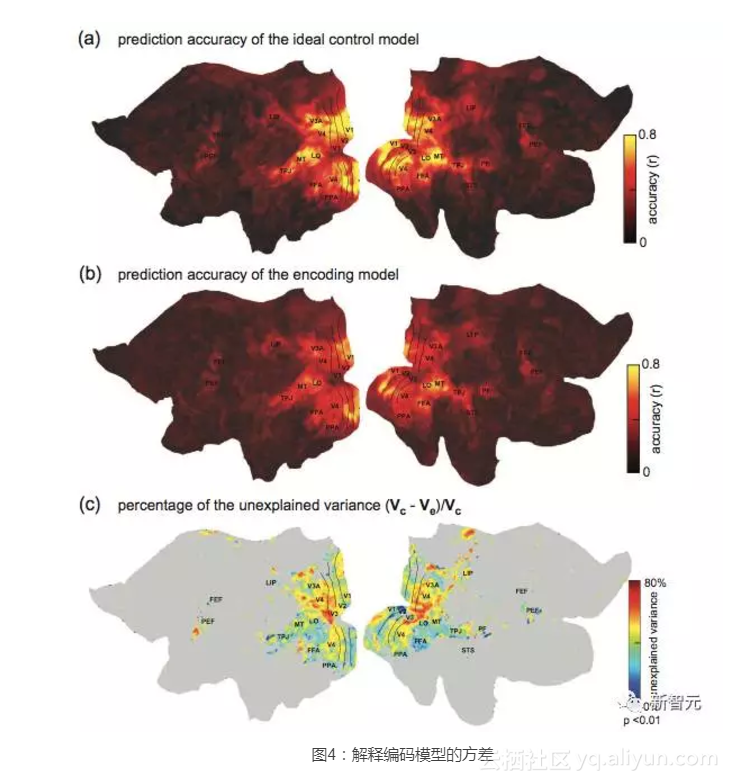

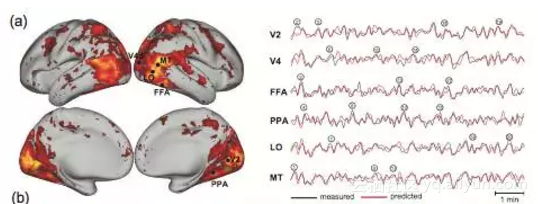

我们试图建立一个体素编码模型(Kay et al. 2008; Naselaris et al. 2011),通过该模型,从CNN的输出预测了每个体素的fMRI反应。具体来说,对于任何给定的体素,我们优化了一个线性回归模型,以组合CNN中单层的单位输出,最好地预测训练电影中的fMRI反应。

图3: 给定体素编码模型的皮层可预测性。(a)体素化编码模型在预测新型自然电影刺激的皮层反应中的准确性。(b)3个受试者的感兴趣区域(ROI)中的预测准确度。(c)不同CNN层对不同ROI的预测准确度。

给定自然视觉输入的可视化单体素表示

我们开发了一种可视化每个单体素的方法。该方法是从视觉输入中识别通像素类型。

结论

经过图像识别监督学习的深度CNN,形成了一个完全可观察的大脑前视神经计算模型。CNN解释在观看自然视频时人类皮质活动的重要变化。它预测和可视化了几乎所有级别视觉处理皮层表征。它还支持皮质活动的直接解码,来重构和分类动态视觉体验。因此,包括CNN及其未来变化在内的深层神经网络预计将体现出丰富的计算原理,以解释人类和动物的自然视觉。

原文发布时间为:2017-10-29

本文作者:常佩琦

本文来自云栖社区合作伙伴新智元,了解相关信息可以关注“AI_era”微信公众号

原文链接:CNN实现“读脑术”,成功解码人脑视觉活动,准确率超50%