本文讲的是阿里云发布ODPS 可分析PB级海量数据,8日,阿里云计算发布核武级大数据产品——ODPS。通过ODPS在线服务,小型公司花几百元即可分析海量数据。ODPS可在6小时内处理100PB数据,相当于1亿部高清电影。此前,全球掌握这种能力的公司屈指可数,如Google、亚马逊等。

五年间,阿里云的工程师们写下250万行代码,不断打磨ODPS。该团队在一封公开信中描述:“把数据海洋里的水灌进ODPS,设定好一套参数,拧开水龙头,出来的就是鲜榨果汁!”对比工业时代,ODPS相当于大数据时代的流水生产线,水龙头里流出来的“果汁”,随原始数据和算法的改变而千变万化。

公开信中表示:工业革命后的200多年里,人类对物理资源的利用登峰造极,对数据资源的利用却仍处于起步阶段。Google、Facebook、阿里巴巴等互联网公司先行一步,触碰到了大数据的魅力。然而,人类拥有的绝大部分数据还无法产生价值。

采用传统方案处理大规模数据,一般得耗资数千万自建数据中心,请专业技术人员维护运作。一旦数据总量超过100TB,技术挑战会非常大。Hadoop开源运动降低了这一成本,不过自建一个像样的Hadoop集群,仍然需要上百万的起步资金。专业的Hadoop人才则更加稀缺。

相比而言,使用ODPS的成本和门槛则低得多。ODPS采取按量收费的模式,目前定价0.3元/GB,即开即用,一个月内免费。根据大部分公司的数据量来测算,一般每月只需花费数百元。

在对外商用之前,ODPS一直是阿里巴巴内部的秘密武器。阿里小贷最先将ODPS应用到商业领域。如今,超过36万人从阿里小贷借款,最小贷款额为1元,并实现3分钟申请、1秒放款、0人工干预。要做到这一点,阿里小贷每天得处理30PB数据,包括店铺等级、收藏、评价等800亿个信息项,运算100多个数据模型,甚至得测评小企业主对假设情景的掩饰和撒谎程度。阿里小贷每笔贷款成本3毛钱,不到普通银行的1/1000。

据悉,淘宝、支付宝等阿里巴巴最核心的数据业务,都运行在ODPS平台。比如阿里妈妈广告的核心算法,点击预测模型的训练等。ODPS商用,意味着阿里云将这种大数据处理能力对外开放,此举将大幅降低社会创新成本。

在公共领域,ODPS也具备广泛应用的潜力:华大基因利用ODPS进行基因测序,耗时不到传统方式的十分之一,未来一旦爆发生物危机,可以为人类赢得宝贵的破译时间;药监部门利用ODPS,全程监管药品流向,解决假药问题。“我们期待未来每一桶油、每一道菜的数据都跑在ODPS上,食品安全问题需要通过创新的方式来解决。”

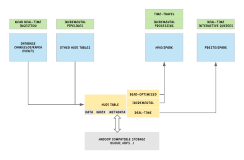

目前,全球提供类似服务的仅有Google和亚马逊,国内尚无同类产品可供比较。阿里云方面表示,ODPS将比Google BigQuery更强大,不仅支持更丰富的SQL语法,还将提供MapReduce编程模型和机器学习建模能力,可以服务更多应用场景。