3.3 基于网络结构和节点信息的网络表 示方法

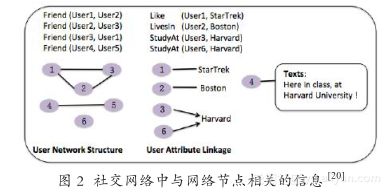

除了节点之间的网络结构信息,网络节点本身往往存在丰富的信息。比如,在维基百科中的文章连接形成的信息网络中,每篇文章作为一个节点,节点包含了丰富的文本信息;在社交网络中(如图2 所示),每个用户节点包含用户产生的文本内容及用户属性(如性别、学校、地点、公司等)。

这部分介绍两种同时考虑网络结构和节点信息的模型:TADW 和 Multi-facetedRepresentations。Multi-faceted Representations模型考虑与节点 υ i 相关的信息为 I i ={text i , G i , R i ,M i }。其中 text i 表示节点 υ i 产生的文本内容,由单词序列组成 text i = {w 1 , w 2 , … };G i 表示与 υ i 相关的网络结构;R i 表示 υ i 与属性实体之间的关系集合(如图 2 中的 Like、LivesIn 和 StudyAt 等);M i 表示用户 υ i 拥有的属性实体集合(如图 2 中 StarTrek、Boston 和 Harvard 等)。TADW 模型则只考虑了网络结构信息和节点的文本信息 I i ={text i , G i }。

TADW 模型

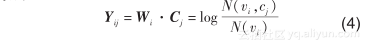

文献 [19] 证明 DeepWalk 模型等价于矩阵分解并给出了待分解矩阵的具体形式。为了建模网络节点自身的文本特征,TADW(text-associatedDeepWalk) 采 用 了 文 献 [26] 中 诱 导 矩 阵 填 充(inductive matrix completion) 的方法。从文献 [25] 可知,使用 hierarchical softmax优化 Skip-gram 模型等价于分解矩阵 Y,Y 中的元素为

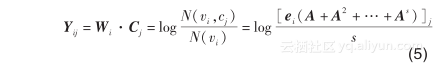

其中 N(υ i , c j )、N(υ i ) 和 N(c j ) 分别表示 (υ i , c j )、节点 υ i 、上下文节点 c j 出现在训练语料中的个数。在DeepWalk 上下文节点 c j 出现在 υ i 的左边或者右边的上下文期望次数为 ,其中 s 是设定的窗口大小。文献 [19] 指出 DeepWalk 模型的优化过程本质上是在分解矩阵 Y,其中 Y 中每个元素为

,其中 s 是设定的窗口大小。文献 [19] 指出 DeepWalk 模型的优化过程本质上是在分解矩阵 Y,其中 Y 中每个元素为

其中 e i 是一个 |V| 维的向量,在 i 维上为 1,其余为0。进而可知,e i A 是从节点 υ i 出发经过一步到达网络上各节点的概率分布,[e i (A+A 2 + … +A s)] j 是上下文节点 c j 出现在 υ i 一边窗口(左边或者右边)的期望次数。

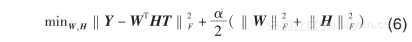

在此基础上,TADW 采用了诱导矩阵填充方法,同时对文本特征和网络结构建模,求解的目标函数为

其中 T 的每一列代表一个节点的文本特征(例如TF-IDF 值),在求解中保持不变。模型得到的 W和 HT 作为网络节点和上下文节点的低维表示串接起来,作为最终的网络表示。在进行矩阵分解之前首先要获得 Y,当 s 变大矩阵分解时间复杂度为O(|V|) 3 。一般情况下,t 越大模型效果越好,但计算越费时。在 TADW 中,t 取 2。

TADW 模型在 Cora、Citeseer、Wiki 三个标准数据集的表现超过了不用文本特征的 DeepWalk模型、只用文本特征的 PLSA [27] 模型,以及简单将两模型所得表示串接起来的方法。这说明 TADW 模型能够有效地融合文本信息获得更好的节点表示。

Multi-faceted Representations( 多方面表示 ) 模型

文献 [20] 关注社交网络中节点表示学习,除了节点的网络链接信息之外,还考虑真实存在的多源信息(见图 2),包括用户产生的文本内容和用户本身的属性背景等。多方面表示模型目标在于学习得到每个用户、每个属性实体和每个用户属性关系的低维向量表示。给定用户 υ i ,整个模型最大化 I i ={text i , G i , R i , M i } 的出现概率为

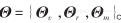

其中 分别表示用户、用户属性实体关系和实体的潜在表示矩阵。模型假设词的表征已经提前学习得到,因此整个模型的参数为

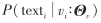

借 助 于 段 落 向 量 (paragraphvector) [15] 的思想建模,使用用户级别的表示和邻接词来预测文本中的目标词。公式如下(8)模型假设词级别的表示是预先学习好的,因此式

借 助 于 段 落 向 量 (paragraphvector) [15] 的思想建模,使用用户级别的表示和邻接词来预测文本中的目标词。公式如下(8)模型假设词级别的表示是预先学习好的,因此式

后一项被看作常数项。模型使用 AUC 损失函数(间隔排序损失 margin ranking loss)的方法对函数的第一部分进行优化,使得 (w, υ i ) 配对的分数大于随机产生的 (w', υ i ) 配对分数,其中 w' 是从词典 C (w)中负采样得到的词。

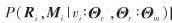

定义为用户 υ i 的链接节点的似然,借助于 Skip-gram 模型的思想,使用用户节点来预测其链接的节点。最后,采用 AUC 损失函数的方法进行优化。

定义为用户 υ i 的链接节点的似然,借助于 Skip-gram 模型的思想,使用用户节点来预测其链接的节点。最后,采用 AUC 损失函数的方法进行优化。

目标在于预测用户 υ i 是否与属性实体 具有 r 的关系。首先使用双线性模型对每个元组 r(υ i , m j ) 建模打分,然后采用AUC 损失函数对模型进行优化。

目标在于预测用户 υ i 是否与属性实体 具有 r 的关系。首先使用双线性模型对每个元组 r(υ i , m j ) 建模打分,然后采用AUC 损失函数对模型进行优化。

多方面表示模型使用随机梯度下降的方法对整个模型进行优化。通过将不同信息建模到统一空间,模型学习得到的网络表示,不仅可以对用户之间的链接关系预测,同时也可以预测用户本身的属性(比如性别、工作、位置等)。