芯片设计厂商ARM公司于本周一公布其基于DynamIQ微处理器架构的第一波处理器产品,同时亦提到经过调整的GPU芯片设计方案。

ARM公司产品营销负责人John Ronco在接受电话采访时解释称,DynamIQ代表着“一种新的CPU整合方式,其能够提供更多配置选项,旨在更为灵活地实现CPU对接。”

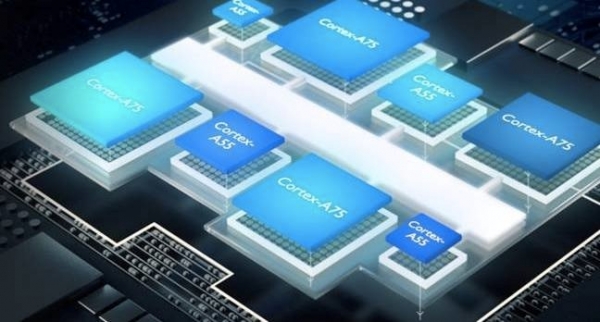

Ronco介绍称,这项技术允许各计算核心以不同尺寸形式存在。此举相当于对2011年首次出台的big.LITTLE架构(其中各核心以分组形式存在,且不同分组间允许存在规模差异)进行扩展,且具备一系列潜在优势。举例来说,包含一个大型计算核心与七个小型计算核心的芯片能够利用较小核心执行持续性计算任务,而较大核心则面向性能密集型应用需求。

Ronco进一步解释道,“DynamIQ是一种新的计算核心拼接方式。在它的帮助下,您将能够对各计算核心进行混合与匹配,从而在自有设计方案中实现更多可能性。我们期待着看到更多用户将其中的大型计算核心引入各类中端设备之内。”

使用这种芯片架构设计的最初两款CPU分别为ARM Cortex-A75与Cortex-A55,二者将于2018年第一季度开始逐步出现在各硬件制造商发布的设备当中。

Cortex-A75专为性能而生,这套设计方案可用于旗舰级手机设备、其它计算设备、基础设施以及车载系统芯片等等。根据ARM公司的说法,在主频为3 GHz的情况下,其SPECint 2006基准测试成绩可在运行速度方面超过原有Cortex-A73 50%以上。

Cortex-A55则面向效率进行调整。“其拥有极为强大的能源效率与成本效率,”Ronco指出,他同时预计这款芯片将被用于众多中端手机设备。

Ronco强调称,A55的上代产品A53已经成为目前普及范围最广的64位CPU方案。

ARM公司宣称,16纳米制程的A55处理器相较于前代28纳米A53处理器,能够将能源效率提升达50%。

Ronco解释道,“对于手机而言,由于其所能够提供的电池续航能力非常有限,因此持续使用时长对于用户来说可谓至关重要。”

Mali-G72 GPU

ARM公司还计划公布Mali-G72图形处理单元,以作为其Mali-G71的换代方案。该公司指出,其去年总计售出10亿块GPU,大约相当于2014年出货量的两倍。

G72针对图形密集型移动游戏、移动VR以及手机内机器学习等负载类型进行了优化,ARM公司产品营销主管Anand Patel表示。

根据Ronco的解释,目前正有越来越多的客户对于AI以及机器学习等方向抱有浓厚兴趣。“这在一定程度上改变了我们所处理的计算任务种类。”

最新的Mali设计当中包含用于强化机器学习计算能力的优化机制。举例来说,其通用矩阵到矩阵乘法(简称GEMM)计算的能源效率提升了17%。

在接受电话采访时,咨询企业IDC公司分析师Abhi Dugar表示,AI类应用对于高通等大型ARM客户已经变得非常重要。

原文发布时间为: 2017年5月31日

本文作者:孙博

本文来自云栖社区合作伙伴至顶网,了解相关信息可以关注至顶网。