打造未来就绪的企业,并非以“预测未来”为前提,而是面向未来做好准备。

大数据真正的价值即在于为面向未来做好准备,帮助企业规避风险。

戴尔提供专门为大数据目标而设计的端到端体系架构,助力企业通过大数据获得商业洞察,面向未来就绪。

正如纳特·西尔弗(Nate Silver)在他的畅销书《信号与噪声》(The Signal and the Noise)中写的,预测未来是非常困难的,因为“我们选择性地忽略了最难以衡量的风险,即便这些风险对我们的生活构成了最大的威胁”。

以大数据获得商业洞察 面向未来就绪

在商业领域,企业的领导人往往寄希望于通过“预测未来”让自己在竞争中胜出,他们不厌其烦地说服自己和其他人:这世界上确实存在一些具有前瞻性的,能够“远远眺望到未来的人”,而这些人就是他们自己——企业的领导者和管理者。

但 正如戴尔在打造“未来就绪企业”(FRE)战略中所倡导的,打造未来就绪的企业(FRE),并非基于对未来的预测,而是侧重于面向未来做好准备——设计并 实施灵活、高效的体系架构,从而让企业更灵敏地反应、更果断地改变。未来就绪的企业致力于成为倡导开放性的典范——乐于接受新观念、新流程,尤其是接受能 够避免刻板和传统的、促进创新和灵活的开放式IT架构。

这同样也应当是企业对待大数据的态度,客观来说,大数据确实蕴含了宝贵的企业经营信息,通过对大数据分析,企业的管理者能够有效、直接、准确地了解企业的运营情况、潜在问题以及商业优势,但就对未来的预测来说,大数据更多的是提供进行预测的蓝本和避免错误发生的预警。

换句话说,大数据分析乃至实时分析,提供的是侧重于面向未来做好准备、或是及时发现问题以规避企业经营风险的作用,“以古通今”可以,“以过去预测未来”则显得不是那么实际了。

但 这并非意味着大数据没有价值了,对企业运营来说,避免发生错误和疏漏,可以说对企业维持正常运营贡献了一半以上的价值,如果再能藉此获得一些“预测未来以 及做出决定”的可供参考的数据支撑,则大数据对于企业经营的价值肯定还会大幅上升,这也就是为什么当前人们要求越来越快、越来越准确的大数据实时分析的重 要原因之一。

在企业运营过程中,大数据产生价值至少需要三个组成部分,缺一不可:

第一,承载大数据的平台是足够可靠的,并且是足够快的,可以将大数据快速供给到数据处理、分析平台,保证“持续性的数据供应”;

第二,数据处理及分析的体系架构是高效率且可信的,这要求整体架构(特别是软件平台)不仅分析速度要快,响应时间要短,更要求任何数据分析平台都可以快速融合到企业现有的数据平台或数据源/流中;

第三,数据的备份、恢复仍然非常重要,随着数据实时分析成为企业的关键业务,一旦出现数据丢失、损坏等原因无法向实时分析平台供给数据,这相当于关键业务出现了停摆,这是不能被允许的。

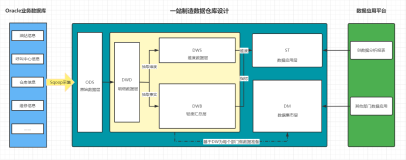

在戴尔大数据及数据分析的技术蓝图中,戴尔强调“提供端到端的体系架构”,专门为大数据目标而设计,利用数据分析和数据管理在软硬件上的集成,实现最终效果的提升,彻底改变数据业务运行效率,推动业务转型,在企业客户的应用中,“分析速度最高可提升70倍,预测分析响应时间最快可加快60倍”,那么,戴尔是怎么做到的呢?

硬件加速 让运行速度快上100倍

作为所有大数据解决方案的基础,硬件平台所能提供的速度是任何软件优化所不能比拟的,正如国内许多互联网公司的DBA最近几年对闪存技术,尤其是PCIe SSD的追捧,远胜过他们对于SQL语句和数据结构优化的热情,硬件平台是一切速度提升最直接、最根本的办法。

针对这一市场需求,戴尔与Hadoop领域的No.1 Cloudera合作,面向Cloudera Enterprise打造了内存一体化应用,Dell (Cloudera)In-Memory Appliances,这一平台以戴尔的PowerEdge C系列服务器为基础,结合戴尔与英特尔合作的性能及安全调优方案和高性能网络,借助Cloudera针对Hadoop及Spark工作负载的部署、配置、调优技术,建立起高性能、可靠的大数据平台。

这一方案与MapReduce相比,运行工作的速度快100倍,与传统磁盘的方案相比,in-memory的速度快10倍,同时,这一单一平台可以支持多种框架,支持Hadoop和Spark,简化运营、降低成本,并且完全基于横向扩展的技术进行搭建。

除此以外,戴尔在近两年针对数据存储及大数据需求,不断优化硬件平台性能:提升13G PowerEdge服务器的能力,特别推出FX2、R730/R730xd、R530xd等适合大数据环境的高性能计算系统;完全针对闪存特性进行了性能优化的戴尔存储SC系列存储系统;Force 10系列高性能、高密度、低延迟的网络交换机,都为面向大数据优化的解决方案提供了完整就绪的硬件平台。

让预测和分析轻松起来 将数据转化为洞察力

在数据处理、分析、进而提取价值、实现预测,并更进一步将数据转化为洞察力之前,数据先要进行由外向内的迁移,并进行数据集成,构建起覆盖面足够广、数据量级足够大的数据集合,这其中至少包括两项工作:在数据集(如数据库)之间进行数据的复制和迁移,以及在应用程序之间的迁移。

比如说,就实现数据集中的数据迁移来说,当前大数据主流的数据集平台是Hadoop、Greenplum,而企业业务系统和原有平台中的结构化数据往往是基于Oracle数据库或是SQL Server所构建的,这意味着企业需要从Oracle数据库迁移到Hadoop或是Greenplum。这就是戴尔SharePlex所做的事情。在其客户网秦的应用过程中,SharePlex非常好地帮助网秦消除了各类应用系统软件升级或迁移过程中的服务停滞时间,实现了在线式的软件系统升级,另一方面Quest SharePlex高效支持异构的IT平台,可以帮助数据库管理员实现高效融合,轻松完成数据的汇集和分发,这让网秦数据管理效率提升10倍。

在应用程序之间同步数据同样令人头疼,为了消除使用旧式中间件、应用方案或自定义代码时,所产生的与集成、及维护集成相关的成本,企业客户寻找过很多的解决方案,但归根结底,他们需要的不过是简化软件及设备的、连接内部或云中同步业务关键型应用程序之间的数据(比如Salesforce)的方法。

换言之,企业需要连接内部传统IT架构、内部私有云、外部混合云及公有云的数据连接及同步方案——这正是Boomi AtomSphere要做的事情,以数据映射建议引擎Boomi Suggest为核心,企业客户可以使用直观的拖放界面立即创建集成流程,自动准确建议映射并在应用程序之间轻松映射数据字段;更可使用Boomi基于Web且功能丰富的控制板,监控和维护已部署的集成流程。

Boomi AtomSphere的价值在于,数据映射的建立只需要通过简单地拖动来解决,可视化设计的界面避免了复杂的编码工作,“封包”了所有的复杂性,并且可以集中管理和监控所有集成流程,“以跟踪总体集成性能以及个别流程的执行指标”。

具有行业特性的服务和解决方案 更聚焦、更可信的商业洞察

基础架构已经准备就绪,数据集合已经准备就绪,顺理成章来到了第三步,这一步正是大数据真正创造价值的部分:统计数据、处理数据、分析数据,形成对业务的有效结论,将数据转化为洞察力。

戴尔Statistica大数据分析正是这一步的关键,Statistica Big Data Analytics是一种先进的内容挖掘和分析解决方案,完全集成了自动化配置及云功能,可以在几分钟内汇集自然语言处理、机器学习、高级搜索和可视化,并可以与Hadoop结合起来,帮助各种规模的企业更有效地处理数据。

最新的Statistica 13可以将企业把预测模型直接部署到数据源的流程进行简化和改进,无论这些数据源在防火墙内、云中还是合作伙伴生态系统中。作为一个无需编码并与开源R无缝集成,且易于使用的解决方案,戴尔Statistica提供全面的数据融合、数据发现以及先进的预测分析工具,帮助企业利用所有数据来预测未来趋势、发现新客户和销售机会、探索“假设”场景,并降低欺诈和其它业务风险的可能性。

值得一提的是,新的本地分布式分析(NDA)功能,让用户可以直接在数据所在的数据库中运行分析,并更有效地使用不断增长的大型数据集。

NDA功能把预测算法建模和计分功能直接推送到数据源。这消除了把数据拉取到中间服务器或桌面的耗费时间,且规避了令数据受限的流程,让所有分析处理直接在数据库内发生,并让企业能够充分利用Hadoop集群、数据库设备和其它高性能平台的威力。

但戴尔在大数据领域的业务就绪并非只有软硬件,随着戴尔服务继续在高级分析和数据科学领域加强IP主导的服务产品,一系列新的BPO服务正式上线,其中包括欺诈、浪费和滥用的管理,拒绝可能性计分和预测分析,客户流失管理/客户保留服务,以及创建早期报警和文本分析的Dell Service Desk Analytics,和帮助客户跟踪、监测各种计分卡或预测分析模型效果的Dell ModelHealth Tracker。

除此以外,戴尔深刻理解“大数据是具有行业特性的,行业要解决的是具有行业特色的大数据”,戴尔服务在先进分析领域有50多个解决方案,包括聚焦人口健康、患者再入院和健康风险分层等关键问题的医疗分析产品;聚焦在线交易和欺诈监测的金融分析产品;以及保险相关产品,聚焦于通过LifeSys(用于保险索赔处理的戴尔平台)中嵌入的分析而减少客户流失。

高性能的数据保护与恢复 为大数据的可靠、可用保驾护航

最后一步,为了保证大数据可靠、可用,在戴尔的未来就绪企业的技术蓝图中,数据保护、备份恢复乃至容灾是非常重要的组成部分,AppAssure 备份、复制和恢复软件 + NetVault 备份正是为此准备的。

在这一解决方案之中,企业客户可以在单一的解决方案中统一进行备份、复制和恢复,保护物理、虚拟和云环境中的数据;几乎可以瞬间恢复系统运行,恢复时间目标(RTO)只有几分钟;在意外发生后,提供近乎不间断的数据访问,确保业务的不间断,但戴尔在这方面的能力还不止如此。

Rapid Recovery在戴尔的数据保护产品组合之中是一个值得记住的名字,因为这一产品不仅集成了AppAssure,而且是一款在开发时充分考虑了云恢复的产品,比如说可以从云存档中裸机恢复 (BMR),采用含加密的Rapid Recovery Repository(R3)以及基于经过验证的Rapid Data Access(RDA)客户端重复数据删除技术——这为从云中实现更快速的快照复制、缩短数据传输时间和更高的规模提供了技术基础。

除此以外,Rapid Recovery还包括两个功能:1.Rapid Snap for Applications技术,可以捕捉整个应用及相关状态,实现完整的应用和系统恢复,拥有接近于零的RTO和激进的RPO;2.Rapid Snap for Virtual功能,基于Dell vRanger技术,为不断扩大的VMWare环境提供可扩展的无代理保护,并自动检测和备份ESXi主机上配置的虚拟机。

Rapid Recovery的高性能、大规模、云适应能力,能够为大数据提供可靠、可用的有效保障,而这正是四步大数据优化的最后一步,历经基础架构、数据集合、数据洞察与数据保护的四步优化,大数据才能够真正顺畅地在企业中发挥其应用的价值,为未来就绪企业的商业洞察与业务发展,提供万全的大数据准备。