本文的目标有两个:

1、学会使用11大Java开源中文分词器

2、对比分析11大Java开源中文分词器的分词效果

本文给出了11大Java开源中文分词的使用方法以及分词结果对比代码,至于效果哪个好,那要用的人结合自己的应用场景自己来判断。

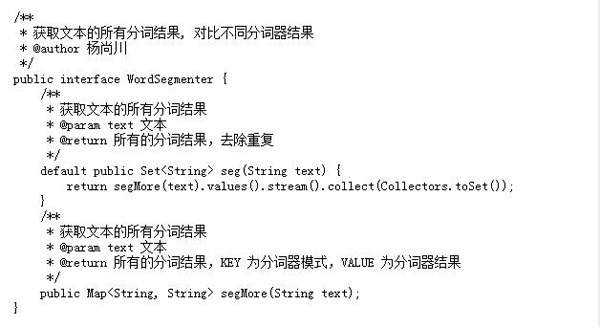

11大Java开源中文分词器,不同的分词器有不同的用法,定义的接口也不一样,我们先定义一个统一的接口:

从上面的定义我们知道,在Java中,同样的方法名称和参数,但是返回值不同,这种情况不可以使用重载。

这两个方法的区别在于返回值,每一个分词器都可能有多种分词模式,每种模式的分词结果都可能不相同,第一个方法忽略分词器模式,返回所有模式的所有不重复分词结果,第二个方法返回每一种分词器模式及其对应的分词结果。

在这里,需要注意的是我们使用了Java8中的新特性默认方法,并使用stream把一个map的value转换为不重复的集合。

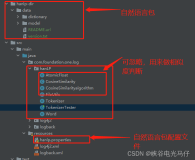

下面我们利用这11大分词器来实现这个接口:

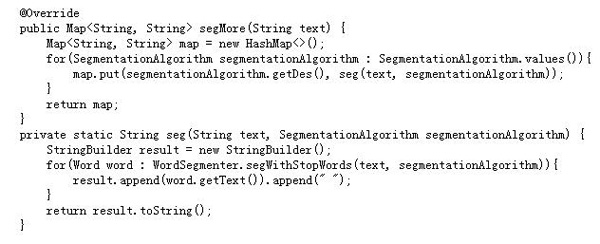

1、word分词器

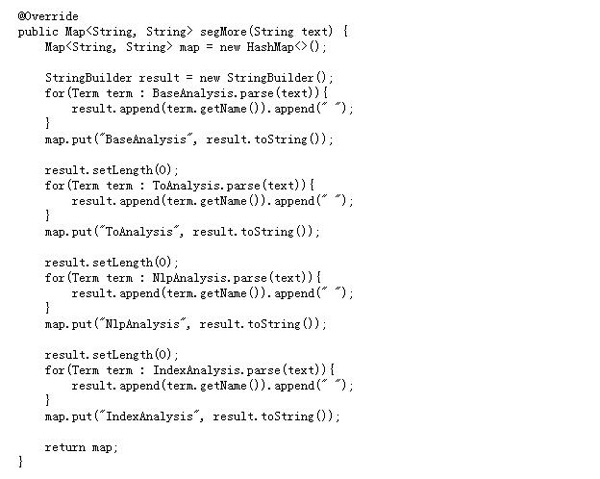

2、Ansj分词器

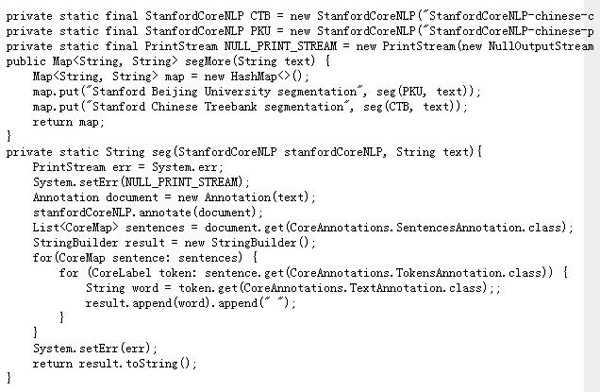

3、Stanford分词器

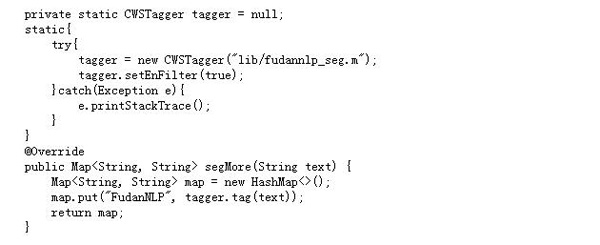

4、FudanNLP分词器

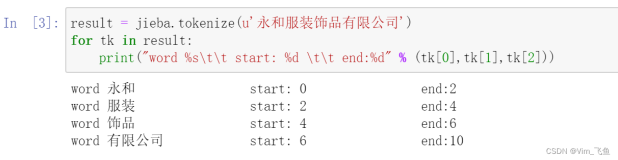

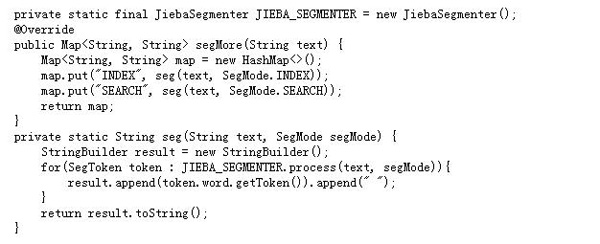

5、Jieba分词器

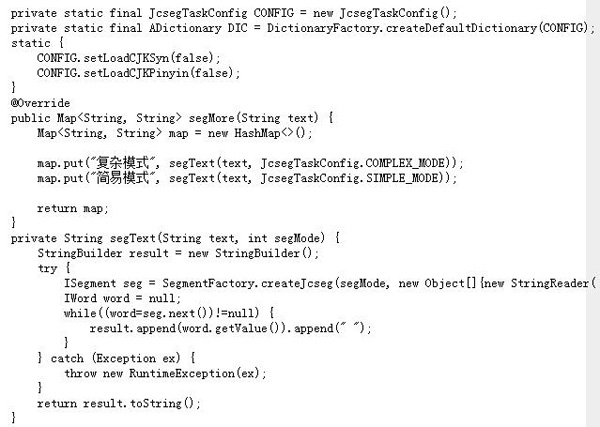

6、Jcseg分词器

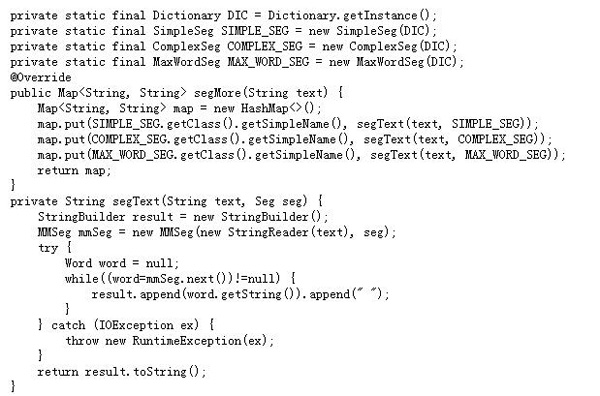

7、MMSeg4j分词器

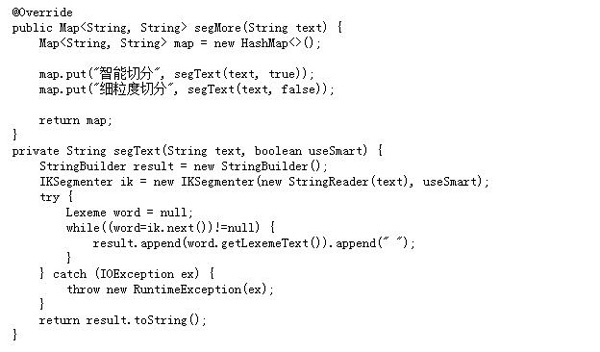

8、IKAnalyzer分词器

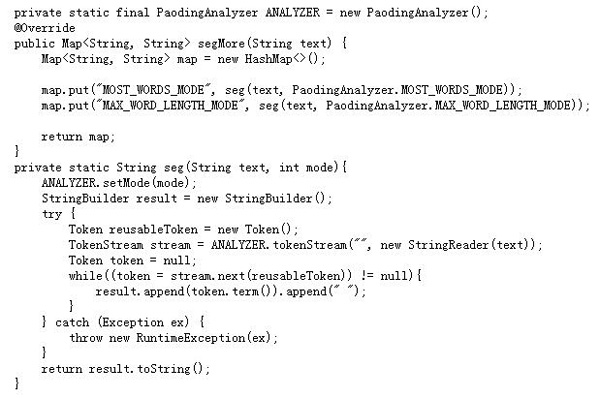

9、Paoding分词器

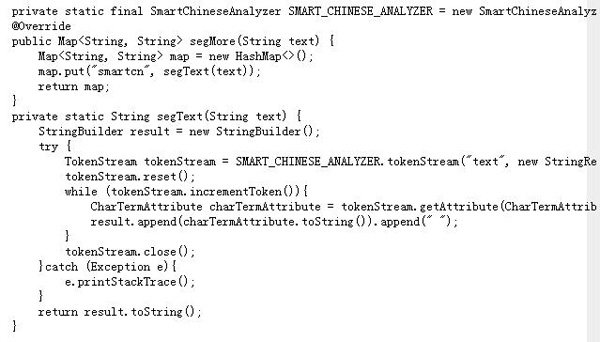

10、smartcn分词器

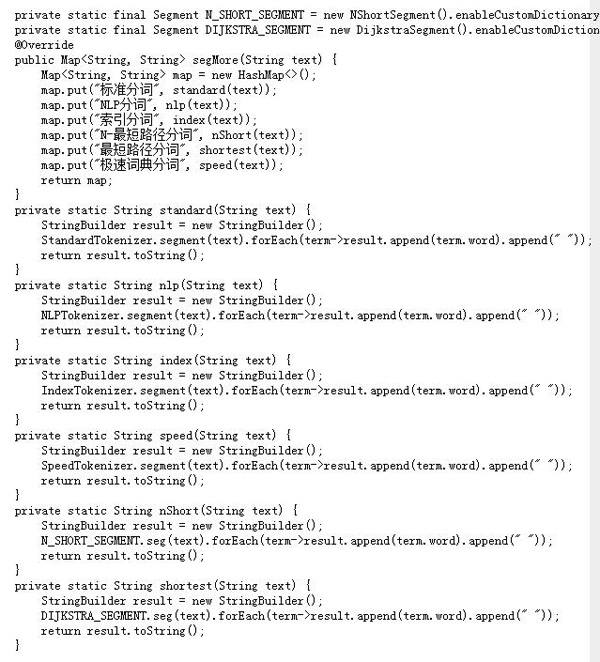

11、HanLP分词器

现在我们已经实现了本文的第一个目的:学会使用11大Java开源中文分词器。

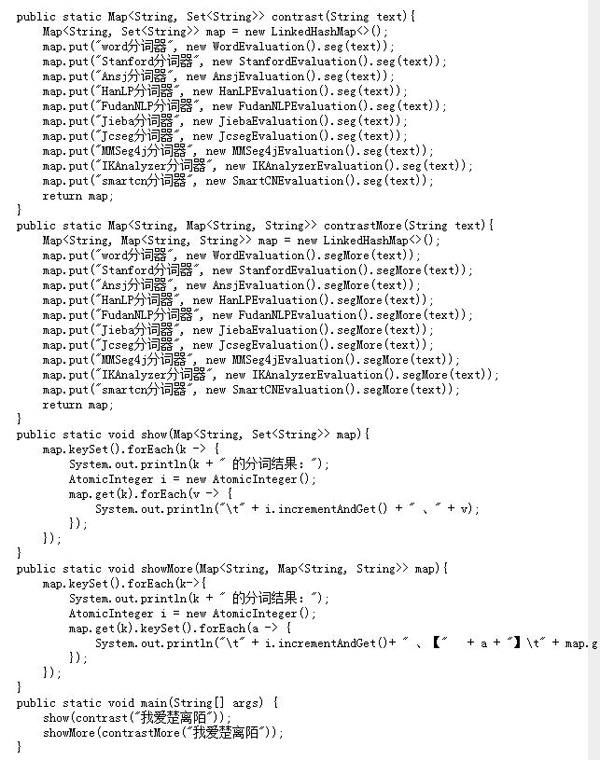

最后我们来实现本文的第二个目的:对比分析11大Java开源中文分词器的分词效果,程序如下:

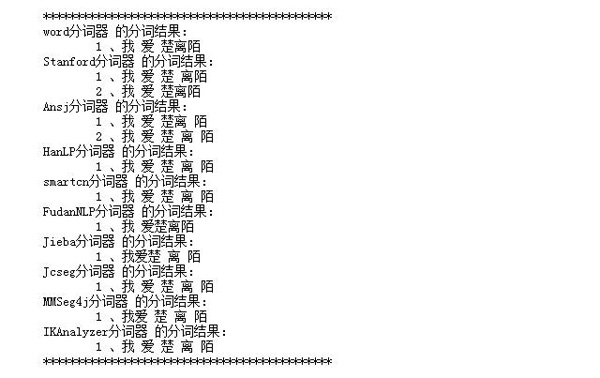

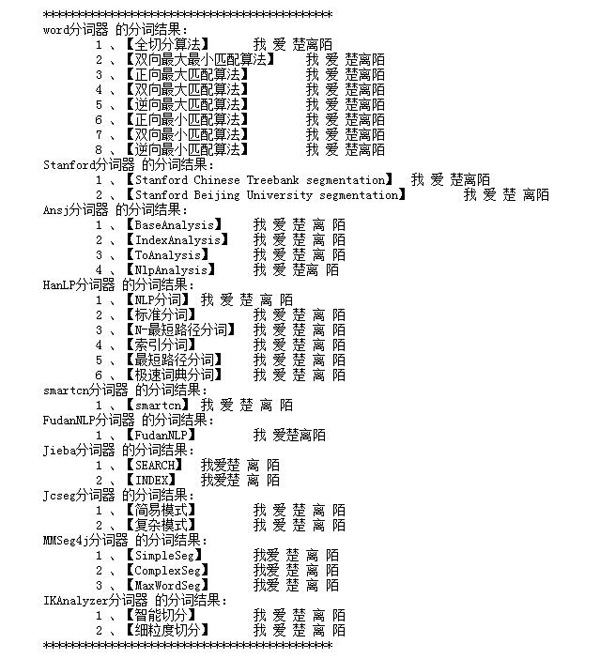

运行结果如下:

作者:liuchi1993

来源:51CTO