雷锋网报道,美国印第安纳州的普渡大学西拉法叶分校的研究工作者,利用深度学习算法为虚拟增强现实技术提供了新型系统——“深度手控”(DeepHand)。

未来的人机交互系统,概念上应能够满足人类和虚拟环境间的交流互动。届时,对计算机的要求也变得更高,计算机将需要获取并计算人类手部复杂的运动状态及庞杂关节角度,从而理解人类双手无穷无尽的姿势所要表达的含义。

在虚拟增强现实技术中,用户需要佩戴头盔,才能够感知虚拟环境为用户所带来的视听盛宴。然而,增强现实技术能为用户呈现虚实并存的世界,并且满足用户对虚拟场景及真实世界双重互动。而虚拟现实技术为用户提供一个纯粹的人工环境,用户可以完全的沉浸在虚拟现实世界。

图片展示了深度手控系统的使用过程。“深度手控”(DeepHand)是由普渡大学C设计实验室的研究者所开发。该系统能够应用深度学习算法理解人类手部灵活的关节和大量复杂的扭动。这将会让我们向未来人机交互系统迈出一大步,更加深刻的满足人类和虚拟环境间的交流互动。

“如果将虚拟现实和增强现实二者结合,这种新系统必须能够看见并且理解用户的双手到底在做什么”,“Donald W. Feddersen机械工程系”兼C设计实验室主管,Karthik Ramani说道。“如果你的双手不能和虚拟现实相互沟通,那么你就没办法做任何事情。这就是为什么说双手在虚拟增强现实技术中是非常重要的。”

“深度手控”(Deephand)是一种新的系统,它应用卷积神经网络算法来模仿人类大脑,同时能够运用“深度学习”算法去理解双手状态的多变性和扭转的复杂度。“我们可以精确定位出手部和指头的位置,并能实时估计双手和指头的运动状态。”Ramani 说道。

一篇关于“深度手控”的研究论文在今年6月26日至7月1日于美国拉斯维加斯举办的CVPR 2016上展出。(附上会议传送门:http://cvpr2016.thecvf.com/)

“深度手控”应用深度感知照相机捕捉使用者的手掌,并且使用特定算法来理解手势。“这种系统被称作‘三维空间用户界面‘,因为用户与电脑是在空间中进行交流,而不是传统的触屏控制和键盘操作。”,Ramani说道。“系统可以根据用户所需来识别搭建在虚拟平台上的物体,例如用户可以开虚拟汽车,或者做一个虚拟的陶艺。这样的一双会思考的虚拟双手,显然是一个至关重要的平台。”

这篇学术文章的作者是博士生Ayan Sinha和Chiho Choi 以及Ramani。关于这篇文章更多细节已在C设计实验室主页展出。普渡大学的C设计实验室,是由美国国家自然基金所支持,并且和Facebook及Oculus齐名。同时联合赞助CVPR研讨会。(普渡大学C程序设计实验室网址传送门在此。)

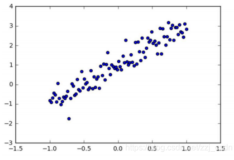

根据一个拥有250万个手势和结构的大数据库,研究工作者不断地“训练”深度手控系统。为了更快的提取有效信息,手指连接处被设置为特定的“特征向量”。

“我们识别一些手部的关键角度。然后我们观察这些角度是如何变化的。这些结构其实就是一些量化的数值。”Sinha说道。

“这个想法类似于Netflix上的推荐算法,根据先验知识,比如用户之前购买过的电影库,然后针对这类特定客户的偏好,选择性地向他们推荐电影。”Ramani说。“深度手控”倾向于选择‘空间最近邻’算法,这种算法能够最佳的被摄像头捕捉到手部具体位置。尽管训练这个系统要求强大的计算能力,但是一旦这个系统被训练好了,就可以在标准运算强度的计算机上运行。”

雷锋网了解到,这项研究已经被国家自然基金和普渡大学机械工程系所支持。

深度手控是一种关于重建人类手势使用深度学习算法的新理论。深度感知镜头使得电脑可以处理不同的人类手势。使用这些新的深度学习算法,电脑识别并重建手型的过程就像我们自身大脑做的那样。这有着潜力去变化我们和电脑交互的方式同时改变我们身边的事情。

深度学习模型能够观察手的不同部位,比如手掌或者指头,并且可以计算出他们组合在一起是怎么工作的,这和大脑的工作非常类似。考虑到自遮挡和自相似的手掌,甚至一些部分对于传感器根本不可见,但是算法依旧可以重建这些部位通过深度学习算法。

雷锋网(公众号:雷锋网)在此附上CVPR 2016该文章的论文摘要译文:

《DeepHand:一种基于补完深度特征矩阵的鲁棒手势估计方法》

摘要:本文提出一种使用商用传感器的深度数据恢复3D手势信息的DeepHand算法。通过有区别的训练卷积神经网络,得到低维的具有深度映射性的手势特征。这一手势特征向量包含了手部运动中整体的和局部的典型关节角度信息。算法通过高效地的识别空间上最近的指节构建出的手势特征,将特征库与合成的深度映射信息结合,并融合前几帧中的相邻指节信息来实现识别功能。

矩阵补完是通过时间-空间行为特征与已标记的手势参数值共同估计未知的手势参数。算法中手势特征数据库覆盖了多种视角下的特征数据,分层估计手势参数从而保证了在遮挡情形下的鲁棒性。文中展示了在标准配置的计算机上统一使用帧率为32的视频流将DeepHand与最新的方法进行对比的结果。

本文作者:sunshine_lady

本文转自雷锋网禁止二次转载,原文链接