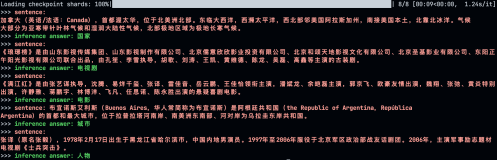

在第十期《论文访谈间》,我们介绍了义原信息(sememe)在提高词向量表示能力方面的作用。义原信息(sememe)是词意的最小语义单位,一个词的意思可以认为是多个义原信息的组合。在 HowNet 中,可以具象化出这种 word-sense-sememe 的结构,如下图所示:

其中苹果是我们的目标单词,网络包含苹果的两个不同意思,而 sememe 分别解释了两个 sense 的具体含义。

为了在 NLP 任务中利用义原信息,需要为词汇进行义原标注。传统的人工标注费时费力,同时由于会让多个专家进行标注,难以避免引入专家的主观偏差。随着新词的不断出现,我们急需一种能为新词进行自动标注义原的方法。来自清华大学的袁星驰,谢若冰,刘知远老师 和孙茂松老师发表在 IJCAI2017 上的论文“Lexical Sememe Prediction via Word Embeddings and Matrix Factorization”首次提出从已有的人工标注数据集学习词汇与义原的通用的关系,借助协同过滤和矩阵分解的方法,自动构造出新词的义原。

由于语义相似的词往往会共享相同的义原,所以本文工作中的主要问题是如何表示词汇与义原的语义含义来对它们之间的语义相关性进行建模。在实现时,有着不少挑战:(1) 由于义原的集合在 HowNet 数据集中标记好了,里面有许多意思相近的义原,在给新词标记义原的 时候要考虑如何区分选择这些义原;(2) 词向量的计算以及是否固定词向量;(3) 由于义原的个数远小于词的个数,无法很好地用义原向量表示词向量,义原向量学习难度大。 为了解决上述问题,作者们提出了三个模型:

1. Sememe Prediction with Word Embeddings (SPWE)

基于相似的词汇应该拥有相似的义原的假设,借助推荐系统中的协同过滤算法,作者提出了基于词嵌入的义原预测模型,即从一个大文本中训练得到所有词的词向量,对于无义原标注的词,找离它最近的那些已标注的词的义原作为其义原集合。同时在训练时加入了置信因子来减少不相关词汇的影响。

2. Sememe Prediction with Sememe Embeddings (SPSE)

受 GloVe 分解词汇共现矩阵来获得词向量的启发,作者提出了基于义原嵌入的义原预测模型,即通过分解词与义原的矩阵和义原的共现矩阵,将词汇与义原嵌入到同一个语义空间。于是可以通过余弦距离的方式为无义原标注的新词推荐义原。由于词与义原的矩阵十分稀疏,在实现时作者还对矩阵中的非 0 项和 0 项采用不同的分解策略来提高效果。

3. Sememe Prediction with Aggregated Sememe Embeddings (SPASE)

基于词汇在语义上是由其义原组合而成的假设,作者提出了基于义原嵌入聚集的义原预测模型。该模型也是通过矩阵分解的方法,即固定词向量矩阵,将其分解为权值矩阵和义原向量矩阵。由此,将词向量表示为其所有义原向量的加权和。最终得到的义原向量可以用来预测新词的义原。

由于作者提出的模型是从不同的方面来对义原预测任务进行建模的,所以作者还做了模型融合。在实验中,由于缺少相关的工作,作者使用了 GloVe+LR 模型作为基准实验,结果表明融合模型取得了更优秀的效果。

同时为了对模型能力进行更好的分析,作者还对不同特点的词,不同词性的词,不同词频的词进行了分析,发现对于名词以及低频词模型表现出了更好的效果。

欢迎点击「阅读原文」查看论文:

Lexical Sememe Prediction via Word Embeddings and Matrix Factorization

关于中国中文信息学会青工委

中国中文信息学会青年工作委员会是中国中文信息学会的下属学术组织,专门面向全国中文信息处理领域的青年学者和学生开展工作。