我们今天要试的,是从RDS 的MySQL数据库到MaxCompute的 ODPS 的数据同步过程。

往简单了说,就是把源数据库(Read)里的数据,转移到目标数据库(Write)。 DataWorks 产品组里的 数据集成 提供了数据一次性搬移,以及周期性搬移的功能,搬移的细节可以在数据同步任务中设置。

一、 数据源

1、 来源数据源

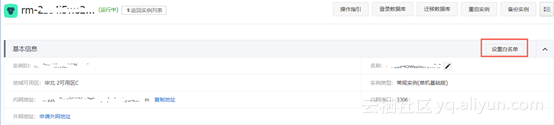

申请RDS 上的MySQL就不多说了,此处的注意事项是,数据集成服务连接RDS MySQL数据库属于远程连接,需要添加连通允许的白名单,如下图所示设置:

参考链接:RDS数据源配置,如何添加RDS IP白名单

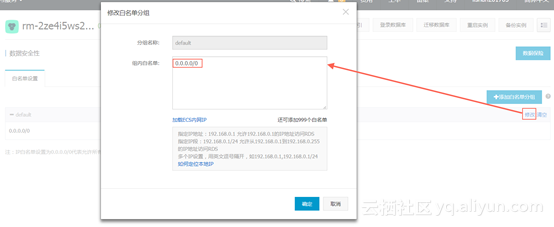

注意:白名单设置我这里很简单,设置为所有ip都可以访问,实际上数据集成服务需要的ip为:

2、 目标数据源

MaxCompte后台用的存储是ODPS,在大数据开发套件里创建的任务默认会带一个ODPS的数据存储,所以需要新建一个project就新建了一个ODPS数据源。

二、 任务配置

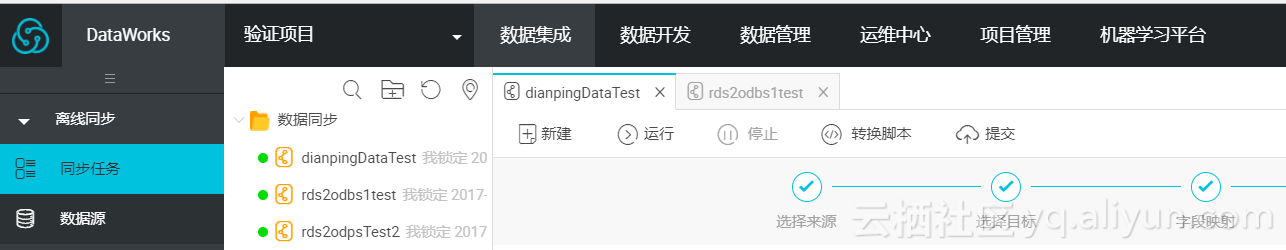

进入 数据集成,按照向导模式,将read数据源和write数据源都配置好。

配置来源:

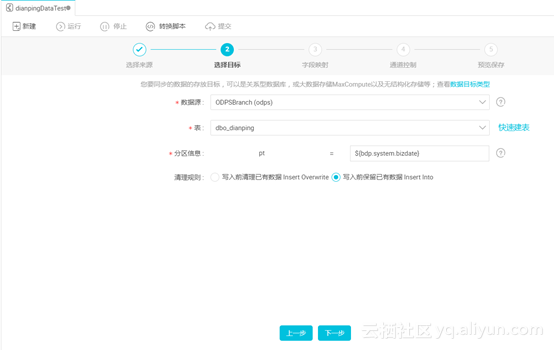

配置目标:

配置字段映射:

预览配置并保存:

配置完成后,就可以运行任务了。点击“运行”会把当前配置好的数据源导入一次。

可以在 DataWorks 产品组中的 数据管理 中查看导入进来的数据表,如下图所示:

笔者尝试过两次导入,一次是几百行,很快完成,一次是大于1亿行,运行了好几个小时,所以要尝试的同学要注意一下,尝试流程时不要试太大的数据集,避免造成运算量过大。

三、 任务运行

测试通过后,可以启动周期调度,点击“提交”后可以就可以进入任务页面了。

按照实际周期同步的需求,设置周期属性,任务提交后,在 运维中心 可以看到任务运行情况。