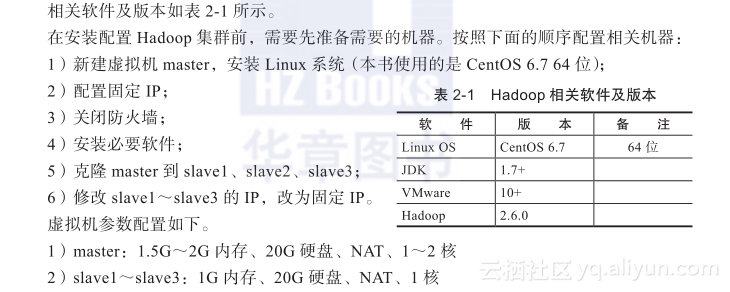

本节书摘来自华章计算机《Hadoop与大数据挖掘》一书中的第2章,第2.2节,作者 张良均 樊哲 位文超 刘名军 许国杰 周龙 焦正升,更多章节内容可以访问云栖社区“华章计算机”公众号查看。

2.2 Hadoop配置及IDE配置

2.2.1 准备工作

上面的虚拟机参数配置只是参考,可以根据自身机器的实际情况进行调整。

在配置好Hadoop集群所需机器后,先确认下集群拓扑,本次部署采用的集群拓扑如图2-16所示。

如文中未做说明,则所有操作都是在root用户下执行。但是,在生产环节,一般不会使用root用户,这点需要注意。

2.2.2 环境配置

1.安装JDK

(1)文件下载

到www.oracle.com网站上下载自己系统对应JDK版本。文件名如jdk-7u-linux-x64.tar.gz,注意下载64位的版本。

(2)解压文件

把下载下来的文件上传到Linux机器,并解压缩到某个路径下,如/usr/local目录。

mv jdk-7u<version>-linux-x64.tar.gz /usr/ local

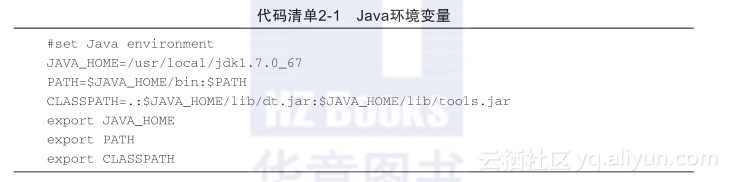

tar zxvf jdk-7u<version>-linux-x64.tar.gz(3)配置Java环境变量

编辑/etc/profile文件,在末尾加上Java配置,如代码清单2-1所示。

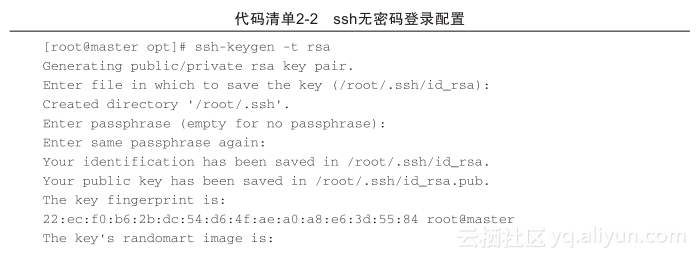

2.配置ssh无密码登录

1)生成公钥和私钥,执行ssh-keygen –t rsa,接着按3次Enter键即可,如代码清单2-2所示。

在~/.ssh目录生成两个文件,id_rsa为私钥,id_rsa.pub为公钥。

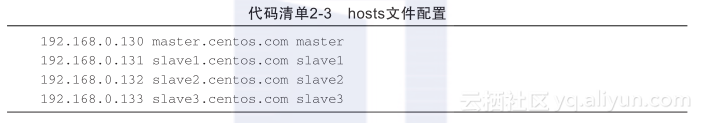

2)设置hosts文件。在/etc/hosts文件中配置IP与HOSTNAME的映射(IP根据自己机器情况设置),如代码清单2-3所示。

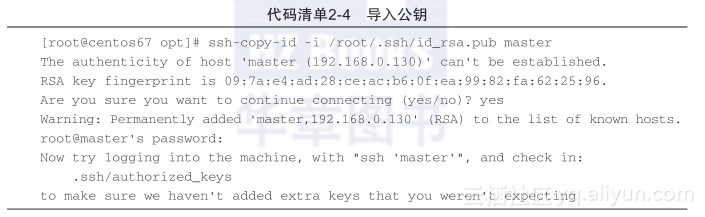

3)导入公钥到认证文件,执行ssh-copy-id命令,如代码清单2-4所示。

接着分别执行:

ssh-copy-id -i /root/.ssh/id_rsa.pub slave1

ssh-copy-id -i /root/.ssh/id_rsa.pub slave2

ssh-copy-id -i /root/.ssh/id_rsa.pub slave3即可导入公钥到其他所有子节点。

4)验证。打开终端,直接输入ssh master、ssh slave1、ssh slave2、ssh slave3,如果可直接登录,而不需要输入密码,则ssh无密码登录配置成功。

[root@master ~]# ssh master

Last login: Tue Nov 3 18:39:41 2015 from 192.168.0.13.配置NTP

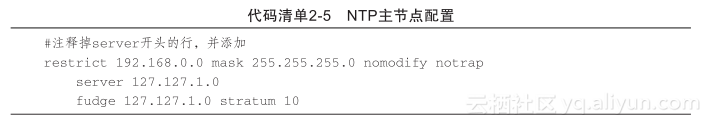

配置NTP主要是为了进行集群间的时间同步,需要注意在master、slave1、slave2、slave3节点分别执行“yum install ntp”,即可安装该软件。

假设将Master节点作为NTP服务主节点,那么其配置(修改/etc/ntp.conf文件)如代码清单2-5所示。

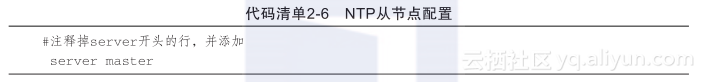

在slave1~slave3配置NTP,同样修改/etc/ntp.conf文件,内容如代码清单2-6所示。

在master、slave1、slave2、slave3节点执行“service ntpd start &chkconfig ntpd on”,即可启动并永久启动NTP服务。

4.配置Hadoop集群

上传Hadoop安装包到master机器,并解压缩到/usr/local目录,使用代码:

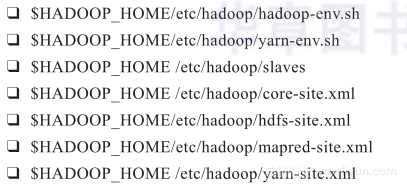

tar -zxf hadoop-2.6.0.tar.gz -C /usr/localHadoop配置涉及的配置文件有以下7个:

各个配置文件修改如下所示。

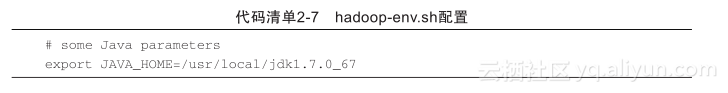

1)配置文件1:hadoop-env.sh。

该文件是Hadoop运行基本环境的配置,需要修改为JDK的实际位置。故在该文件中修改JAVA_HOME值为本机安装位置,如代码清单2-7所示。

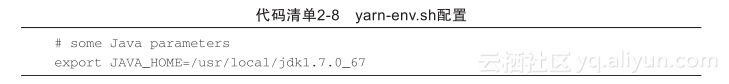

2)配置文件2:yarn-env.sh。

该文件是YARN框架运行环境的配置,同样需要修改Java所在位置。在该文件中修改JAVA_HOME值为本机安装位置,如代码清单2-8所示。

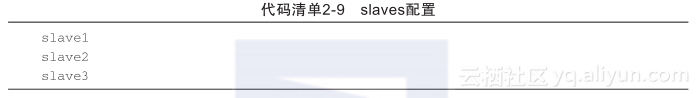

3)配置文件3:slaves。

该文件里面保存所有slave节点的信息,如代码清单2-9所示。

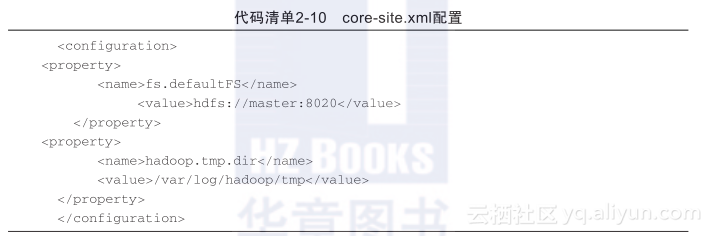

4)配置文件4:core-site.xml,配置内容如代码清单2-10所示。

这个是Hadoop的核心配置文件,这里需要配置两个属性:fs.defaultFS配置了Hadoop的HDFS系统的命名,位置为主机的8020端口,这里需要注意替换hdfs://master:8020,中的斜体master,该名字为NameNode所在机器的机器名;hadoop.tmp.dir配置了Hadoop的临时文件的位置。

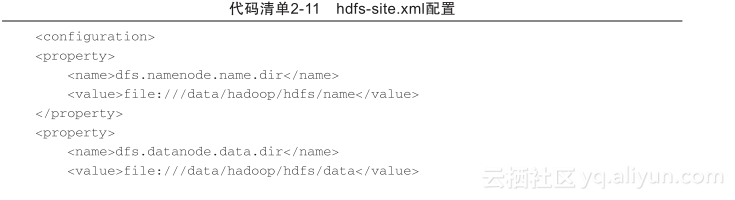

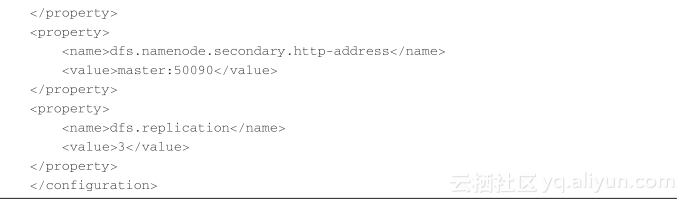

5)配置文件5:hdfs-site.xml,配置内容如代码清单2-11所示。

这个是HDFS相关的配置文件,dfs.namenode.name.dir和dfs.datanode.data.dir分别指定了NameNode元数据和DataNode数据存储位置;dfs.namenode.secondary.http-address配置的是SecondaryNameNode的地址,同样需要注意修改“master”为实际Secondary-NameNode地址;dfs.replication配置了文件块的副本数,默认就是3个,所以这里也可以不配置。

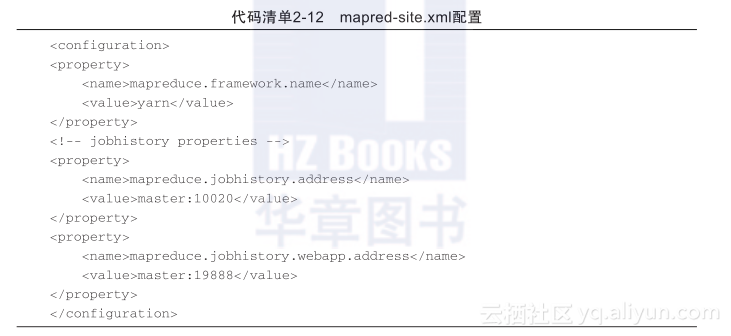

6)配置文件6:mapred-site.xml,配置内容如代码清单2-12所示。

这个是MapReduce相关的配置,由于Hadoop2.x使用了YARN框架,所以必须在ma-preduce.framework.name属性下配置yarn。mapreduce.jobhistory.address和mapreduce.job-history.webapp.address是与JobHistoryServer相关的配置,即运行MapReduce任务的日志相关服务,这里同样需要注意修改“master”为实际服务所在机器的机器名。

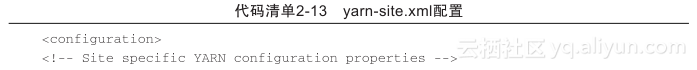

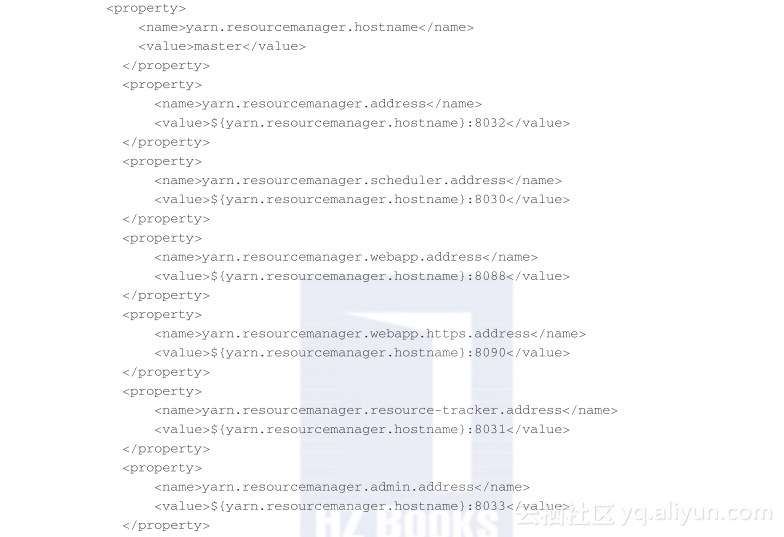

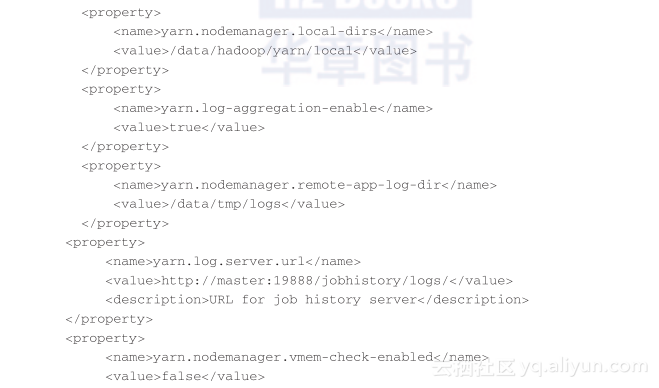

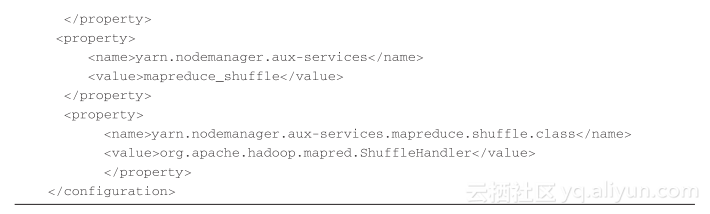

7)配置文件7:yarn-site.xml,配置内容如代码清单2-13所示。

该文件为YARN框架的配置,在最开始命名了一个名为yarn.resourcemanager.hostname的变量,这样在后面YARN的相关配置中就可以直接引用该变量了。其他配置保持不变即可。

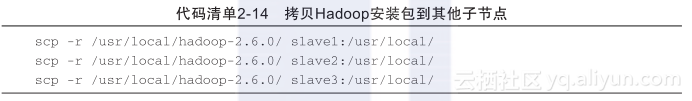

将配置好的Hadoop复制到其他节点,直接执行如代码清单2-14所示命令即可(注意,本文使用的从节点名字是slave1、slave2、slave3,读者可根据自己机器实际情况修改)。

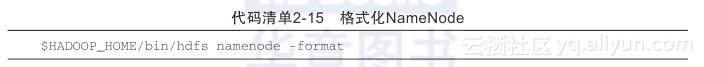

5.格式化NameNode

做完Hadoop的所有配置后,即可执行格式化NameNode操作。该操作会在NameNode所在机器初始化一些HDFS的相关配置,其命令如代码清单2-15所示。

若出现“Storage directory /data/hadoop/hdfs/name has been successsully formatted”的提示,则格式化成功(注意,/data/hadoop/hdfs/name目录就是前面配置的dfs.namenode.name.dir的值)。

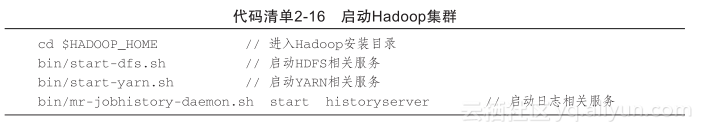

2.2.3 集群启动关闭与监控

启动集群,只需要在master节点(NameNode服务所在节点)直接进入Hadoop安装目录,分别执行如代码清单2-16所示的命令即可。

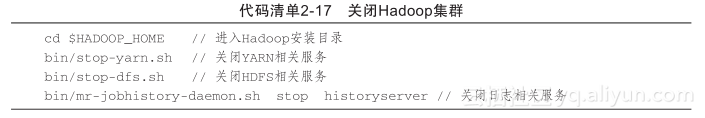

关闭集群,同样只需要在master节点(NameNode服务所在节点)直接进入Hadoop安装目录,分别执行如代码清单2-17所示的命令即可(注意关闭顺序)。

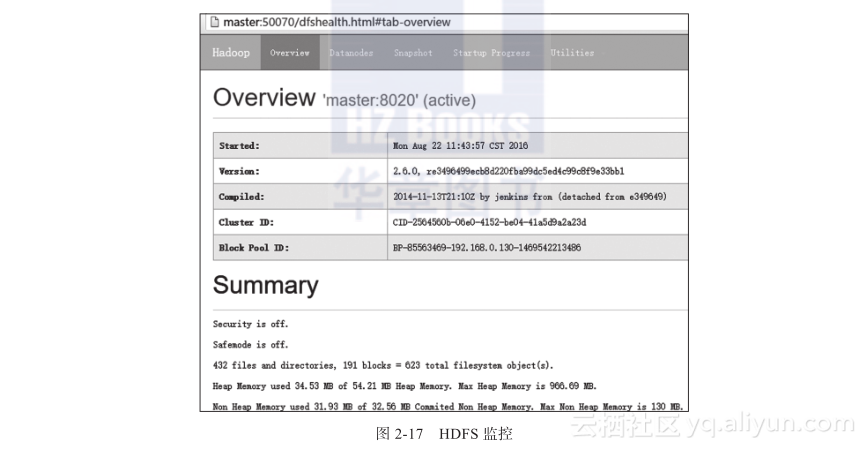

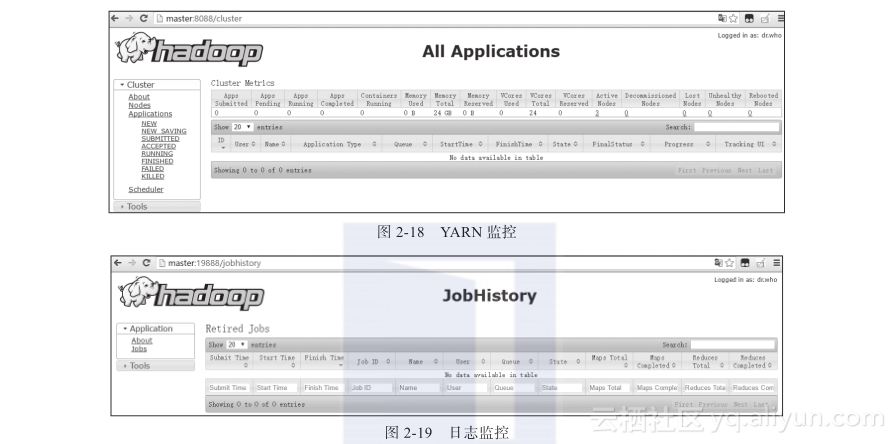

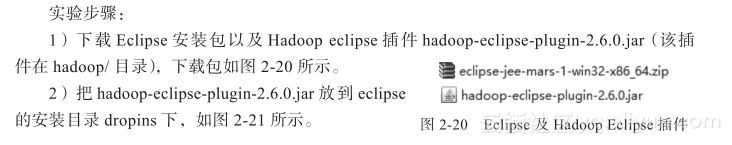

Hadoop集群相关服务监控如表2-2所示,其监控示意分别如图2-17、图2-18、图2-19所示。

2.2.4 动手实践:一键式Hadoop集群启动关闭

在使用Hadoop的过程中,如果每次启动Hadoop集群都需要分别执行3次命令才能启动集群,那么每次集群启动或关闭都将很繁琐。为了减少这种操作,可以编写一个脚本来控制Hadoop集群的启动与关闭,所以本实验就是完成这个功能。

实验步骤:

1)学习Linux shell命令相关代码;

2)了解Hadoop集群启动关闭流程;

3)编写集群启动关闭shell脚本;

4)测试运行。

2.2.5 动手实践:Hadoop IDE配置

在书中的后续内容中,会针对Hadoop相关MapReduce程序进行讲解以及开发,一个好的程序讲解及代码编写环境,将会非常有利于对应的分析,所以本节就对Hadoop代码分析与开发环境配置做讲解。

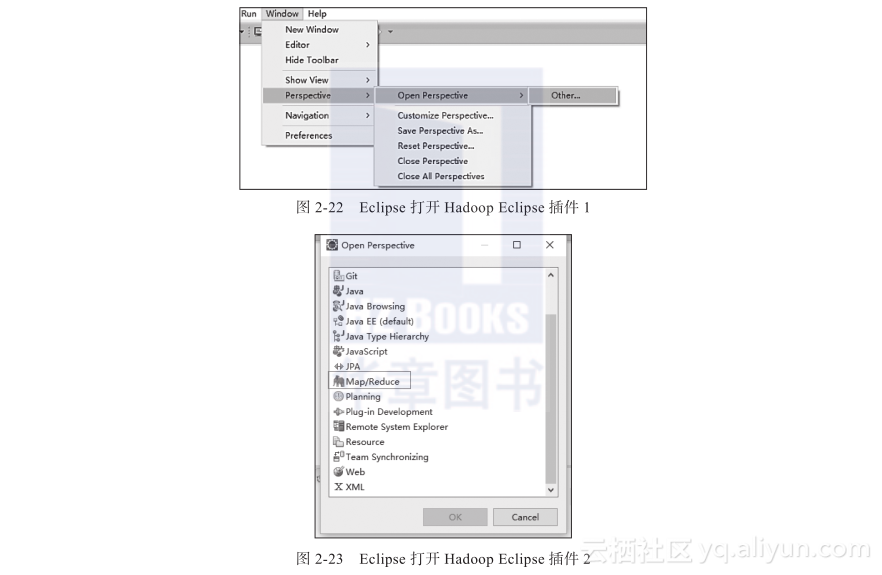

3)打开eclipse,依次选择Window->Perspective->Open Perspective->Other->Map/Reduce,如图2-22、图2-23所示。

选中后,单击OK按钮,重启Eclipse。

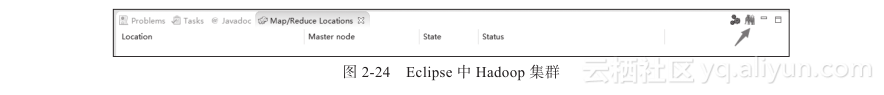

4)单击图2-24中箭头所指小象图标,即可添加集群。

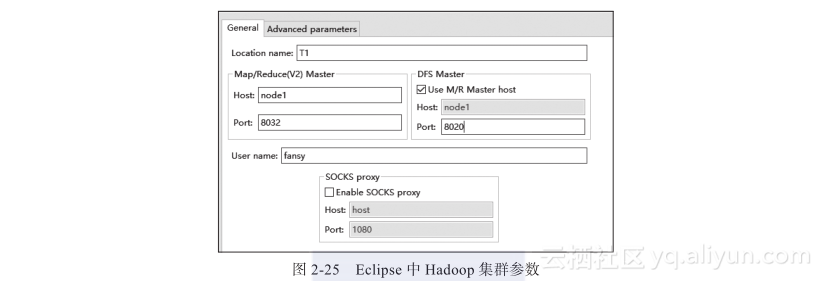

5)配置参数,如图2-25所示。

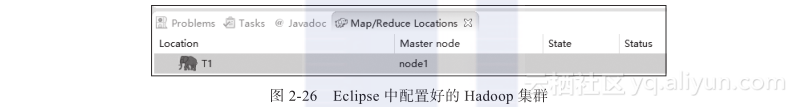

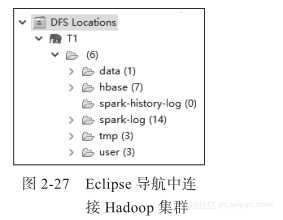

6)查看配置的集群,如图2-26、图2-27所示。

思考:

1)为什么要配置Hadoop IDE,不配置可以吗?还有其他的配置方式吗?

2)如果有其他方式配置Hadoop IDE,会是什么呢?