本节书摘来华章计算机《数据分析实战:基于EXCEL和SPSS系列工具的实践》一书中的第2章 ,第2.1节,纪贺元 著 更多章节内容可以访问云栖社区“华章计算机”公众号查看。

2.1 基本概念和术语

2.1.1 基本概念

有关统计和数据挖掘的概念很多,以下拣选一些常用的基本概念进行说明。

1.统计与挖掘

“统计”,对于读者来说可能并不陌生,在“统计”、“挖掘”这两个概念中,可能大家往往会觉得“挖掘”更难理解。统计和挖掘最大的差别在于:统计是事先设想好的一个动作,然后去验证它。例如先假设销售收入和销售投入之间有关系,公司多投钱给推销人员去拜访客户,就能获得更多的用户和订单,销售收入就能上升,然后我们用统计的模型去验证它。

另外的一个例子是:社会大众都认为吸烟是导致肺癌的重要原因,然后大家找来了一些肺癌患者的相关数据,研究表明,同样是吸烟者,有的人得了肺癌,但是很多人却没事,并且一些从来不吸烟的女性也有得肺癌的。这样,大家慢慢开始怀疑肺癌和吸烟之间的正向关系。或者简单地说,对于这个例子,统计分析的结论是固定的:只有两种可能,一是肺癌和吸烟有关系,二是无关!

那么数据挖掘是怎么样的呢?

曾经有炒股票的大户给了我们很多数据,包括股票是否涨停、是否放量、前几天的各种指标,涉及KDJ、RSI、MACD等,客户希望我们帮他确定:具有什么样特征的股票是比较容易涨停的?这个需求怎么实现后面再说,这里想要说明的是,在分析这个数据之前,是没有“假定”的,我们不知道最后做出来的结果是什么样的。这就是数据挖掘,从大量的数据中通过各种方法找出隐藏于其中的信息。

2.平均值

平均值似乎是一个无须讲的东西,但是实际上在数据量大的情况下,平均值反映的是一个数据“应该”是什么。记得之前曾看过一份报告,说上海成年男性的平均身高是170.5厘米,那份报告的样本量是比较大的,实际上就是说上海男性的身高“应该”是170.5厘米。

3.标准差

如果说平均值反映了数据的“中轴线”,那么标准差就反映了数据的波动情况,也就是说数据是波澜不惊还是起伏不定。

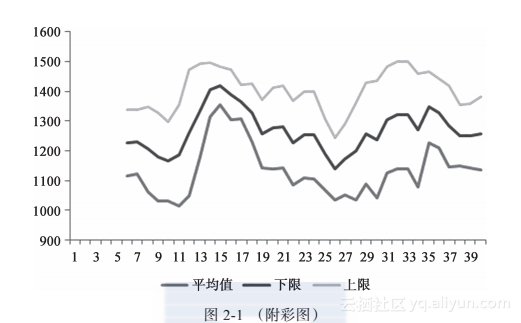

“平均值+标准差”仿佛就是一对结义兄弟,焦不离孟、孟不离焦,我们经常用这个组合来衡量数据的变动范围,如图2-1(数据的平均值和标准差分布图)所示。

4.正态分布

说起正态分布,我自己都有点犯难,因为正态分布是理论性比较强的,这本书的初衷是侧重应用而不是理论。不过正态分布实在是重要,它贯穿了统计分析的全过程,几乎无处不在,正态分布如同统计分析中绕不过去的一堵墙,因此还是需要解释一下。

理解正态分布,就从这个例子开始:90年代末的时候,移民还比较容易,那时很多人都选择了移民,那么,我们现在来看看当时移民到美国、加拿大的人过得怎么样吧!大致梳理了一下,得到如下结论:

混得好的:很少,应该说是极少数。在当地大企业里面做得不错,没几个;自主创业成功的,好像没有。当然这里说的自主创业是正儿八经的创业,开中国餐馆个人认为不算创业。

混得一般的:大多数,就是在企业里面有一个普通的职位,算不上有钱,但是温饱不愁。

混得差的:也是少数,有一些人回来了,或者在那边就是干司机、导游或体力活,这里丝毫没有瞧不起这些职业的意思,但是对于在国内受过良好高等教育的人来说,算是专业不对口吧。

简单地讲,就是混得好的和混得很差的都很少,大多数都是普普通通。

其实这种规律在工作和生活中大量存在,如果跟踪统计一下大学毕业生的发展情况,大致也是这样;老百姓的体重、身高、血压、血糖等的分布都是如此。这种规律就是我们经常提到的正态分布。

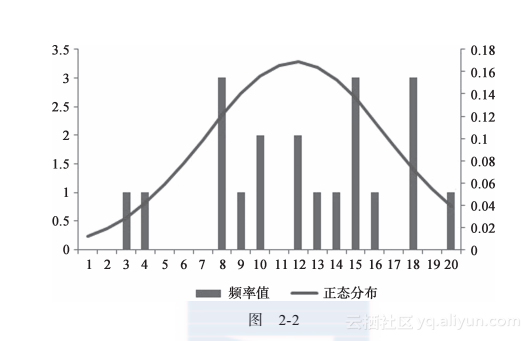

如果把这个规律稍微讲得形象一点,就是“两头小,中间大”,请见图2-2(数据的频率和正态分布图)。

让我们简单地看一下正态分布的规律:

1)两边基本是对称的。

2)形状像一个倒扣的“钟”。

3)高峰在中间,越到中间,数据分布的概率越大,越到两边,概率就越小。

这个看上去很简单的正态分布,其实就是统计分析的重要基础,实际上很多统计规律都是建立在数据正态分布的基础上的。或者说,如果数据不是正态分布的,那么很多统计规律则是不成立的。

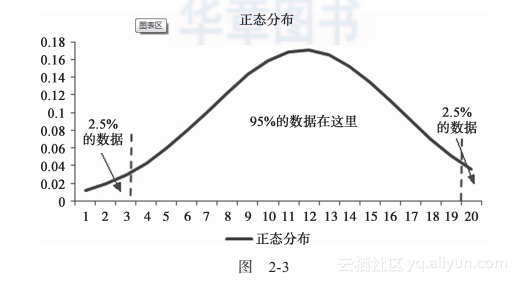

根据正态分布的规律可以得到,绝大部分(95%)的数据,是分布在居中的位置上的,只有很小概率的事件分布在正态曲线两侧,这个就是假设检验中的单侧和双侧,如图2-3所示。

5.峰度和偏度

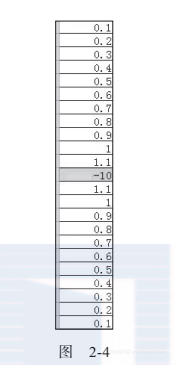

峰度和偏度算是数据分析中比较专业的概念了,峰度反映的是数据中极值的情况,请看图2-4峰度的数据。

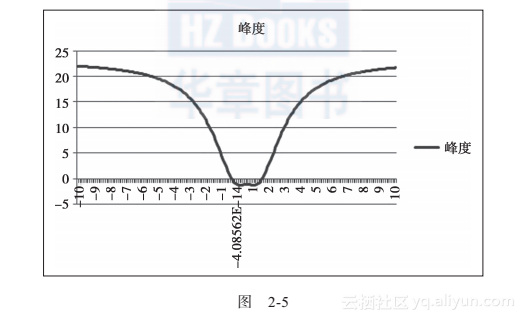

在图2-4中,极值是-10的时候,KURT函数结果为21.86,下面观察一下当极值范围在-10和10之间时,KURT函数的取值结果,如图2-5所示。

从图2-5可以看出,当极值与原值的取值范围比较接近的时候,峰值会接近于0,而极值与原值的范围差距比较大时,峰度值会变大,但是无论是正极值还是负极值,峰度的最大值都是23左右。

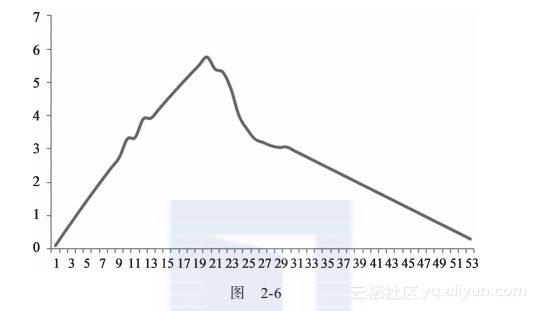

偏度是衡量数据对称性的一个重要指标,EXCEL中对应的函数是SKEW,它用于比较对象正态分布曲线,如图2-6所示,这是一个左偏的数据图。

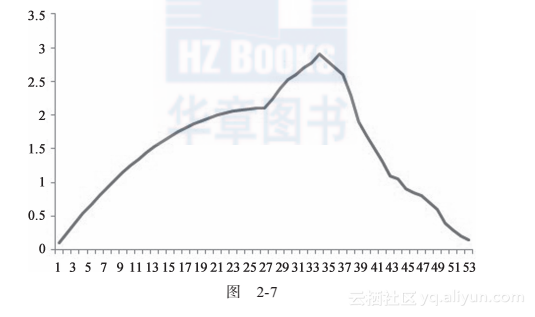

在图2-6中,数据明显左偏,其偏度值为0.346,再来看看图2-7,这是一个右偏的数据图。

在图2-7中,数据的偏度为-0.098,此时数据明显右偏。因此根据偏度值判断数据对称性的规则如下:

数据服从正态分布,偏度为0。

数据左偏,偏度>0。

数据右偏,偏度<0。

6.连续和离散

连续变量和离散变量是数据分析中经常碰到的概念,所谓连续变量就是一个区间里可以任意变化的量,例如国民收入在0~100万之间波动时,每一个值都是可以取到的;离散变量就是只能取很少数的几个值,例如性别,就是男和女;大气雾霾的等级是优、良、中、轻度污染、重度污染、爆表。

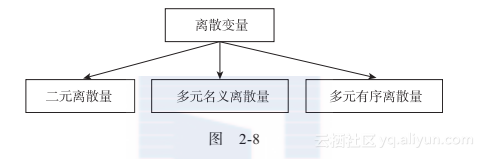

离散变量内部也有区分,图2-8所示为离散型变量的分类。

二元离散量的例子很多,例如医生关心患者是否得病,“得病”和“不得病”就是二元离散的;企业关心客户的购买行为,“买”和“不买”也是二元离散的。

只要离散变量超过两个,就是多元的,在“多元名义离散量”这个概念中,“名义”这两个字其实挺难理解的,它的英文是nominal,意思是有多个变量,但是变量之间并没有明确的排序关系,例如企业品牌之间的关系,宝洁有飘柔、伊卡璐、潘婷、海飞丝等品牌,我们很难说这些品牌之间有明确的排序关系。再例如,在研究城市的经济发展时,北京、上海、南京、武汉、南宁这些城市之间,也很难说有明确的排序关系。

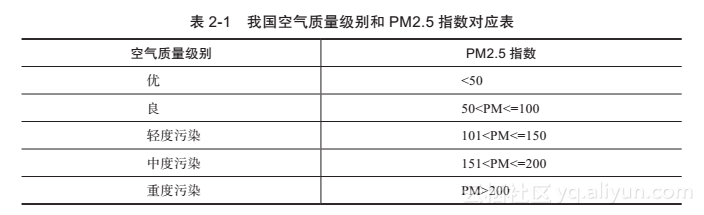

多元有序则不然,现在国内空气质量不好,考虑PM2.5指数,有“严重污染”、“中度污染”、“轻度污染”、“良”、“优”这五个档次,见表2-1。

类似于表2-1这种有多个并且之间可以明确排序的变量就是多元有序。

7.因变量和自变量

因变量,一般指的是我们研究和关心的变量,自变量一般就是其发生变化后会引起其他变量变化的变量。

因变量和自变量说起来很容易,但是在实际的数据分析中,学员往往会容易混淆。

我在上课的时候,经常举到一个“销售收入和销售费用”的例子,并且提出了一个判断因变量和自变量比较简单有效的原则,即:时间上靠前的就是自变量,时间上靠后的就是因变量。在实际销售工作中,通常是先有销售费用,然后去推销,然后再有销售收入,因此销售费用是自变量,销售收入是因变量。