一、 概述

阿里云发布了很多产品,今天让我们一起来了解下数据传输(Data Transmission) 吧。

什么是数据传输呢?

阿里云数据传输支持以数据库为核心的结构化存储产品之间的数据传输。 它是一种集数据迁移、数据订阅及数据实时同步于一体的数据传输服务。 数据传输的底层数据流基础设施为阿里双11异地双活基础架构, 为数千下游应用提供实时数据流,已在线上稳定运行3年之久。 您可以使用数据传输轻松构建安全、可扩展、高可用的数据架构。

那么,数据传输有什么优势呢?接下来让我来说说吧。

- 数据传输支持同异构数据源之间的迁移同步,支持迁移订阅同步等多种传输方式,增量迁移可以实现应用无缝切换。

- 数据传输服务使用高规格服务器来保证每条迁移同步链路都能拥有良好的传输性能。相对于传统的数据同步工具,数据传输服务的实时同步功能能够将并发粒度缩小到事务级别,甚至能够并发同步同张表内的数据,从而极大得提升同步性能。

- 数据传输服务底层为服务集群,集群内任何一个节点宕机或发生故障,控制中心都能够将这个节点上的所有任务秒级切换到其他节点上,链路稳定性高达99.95%。数据传输服务内部对迁移同步链路提供7*24小时的数据准确性校验,快速发现并纠正传输数据,保证传输数据可靠性。数据传输服务各模块间采用安全传输协议及安全token认证,有效得保证数据传输可靠性。

- 数据传输服务提供可视化管理界面,提供向导式的链路创建流程,用户可以在其控制台简单轻松得创建自己的传输链路。数据传输服务控制台展示了链路的传输状态及进度,传输性能等信息,用户可以方便管理自己的传输链路。

可能您会问到,“我处在什么样的应用或服务场景时,可以选择数据传输呢?”这里介绍下数据传输的常见应用场景:

- 上云迁移

- 数据库拆分

- 本地灾备、异地灾备

- 数据分析

- 解决跨地区读延迟

通过我的介绍,希望大家能有所收获。

数据传输典型特性介绍:

https://www.aliyun.com/product/dts/?spm=5176.2066478.3.13.VnKETC

二、 技术点(数据传输五大热点技术问题分析)

在上一篇文章中,我们为大家介绍数据传输的概况,数据传输(Data Transmission)是阿里云提供的一种支持以数据库为核心的结构化存储产品之间的数据传输服务,它提供了数据迁移、数据订阅及实时同步等多种数据传输功能。使用数据传输服务实现数据一键上云的同时,您还可以轻松得构建安全、可扩展、高可用的数据架构。那在使用过程中,经常遇到的热门技术问题有哪些呢?

创建数据迁移任务:

创建实时同步作业:

创建订阅通道:

库名不同的数据库之间的数据迁移:

利用数据订阅实现本地灾备:

希望上面的内容,能够对大家有所帮助。

三、 体验(跨阿里云账号的ECS自建数据库迁移至RDS)

下面我为大家来介绍下应用数据传输的相关体验。

DTS数据迁移任务,如果配置连接方式时,源实例选择ECS上的自建数据库,那么要求这个ECS实例跟目标RDS必须属于同一个阿里云账号。如果要实现某一个阿里云账号下的源ECS实例上的自建数据库迁移到另外一个阿里云账号下的RDS实例。那么源实例类型必须选择有公网IP的自建数据库。

本小节介绍如何利用DTS试下跨阿里云账号的ECS自建数据库迁移至RDS。

RDS实例数据库创建

在配置DTS迁移任务之前,待迁入数据库在目标RDS实例中必须已经存在。如果未创建,需要在RDS控制台创建。

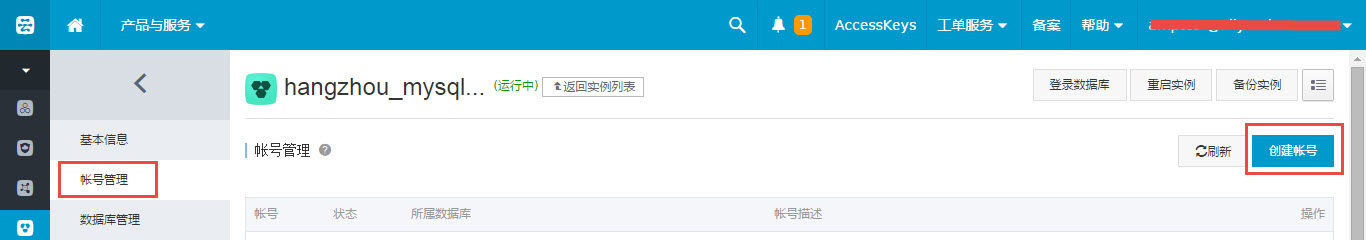

迁移账号创建

在配置迁移任务时,需要配置目标RDS实例的迁移账号,如果未创建迁移账号,那么在配置迁移任务之前,需要先在目标RDS实例中创建迁移帐号,并将要迁移的库的读写权限授权给上面创建的帐号。

配置迁移任务

下面以将阿里云账号A下面的ECS实例上的自建数据库的库amptest1的数据迁移到另外一个阿里云账号B的RDS实例为例,介绍如何在DTS任务配置时实现跨阿里云账号的ECS自建数据库迁移至RDS。

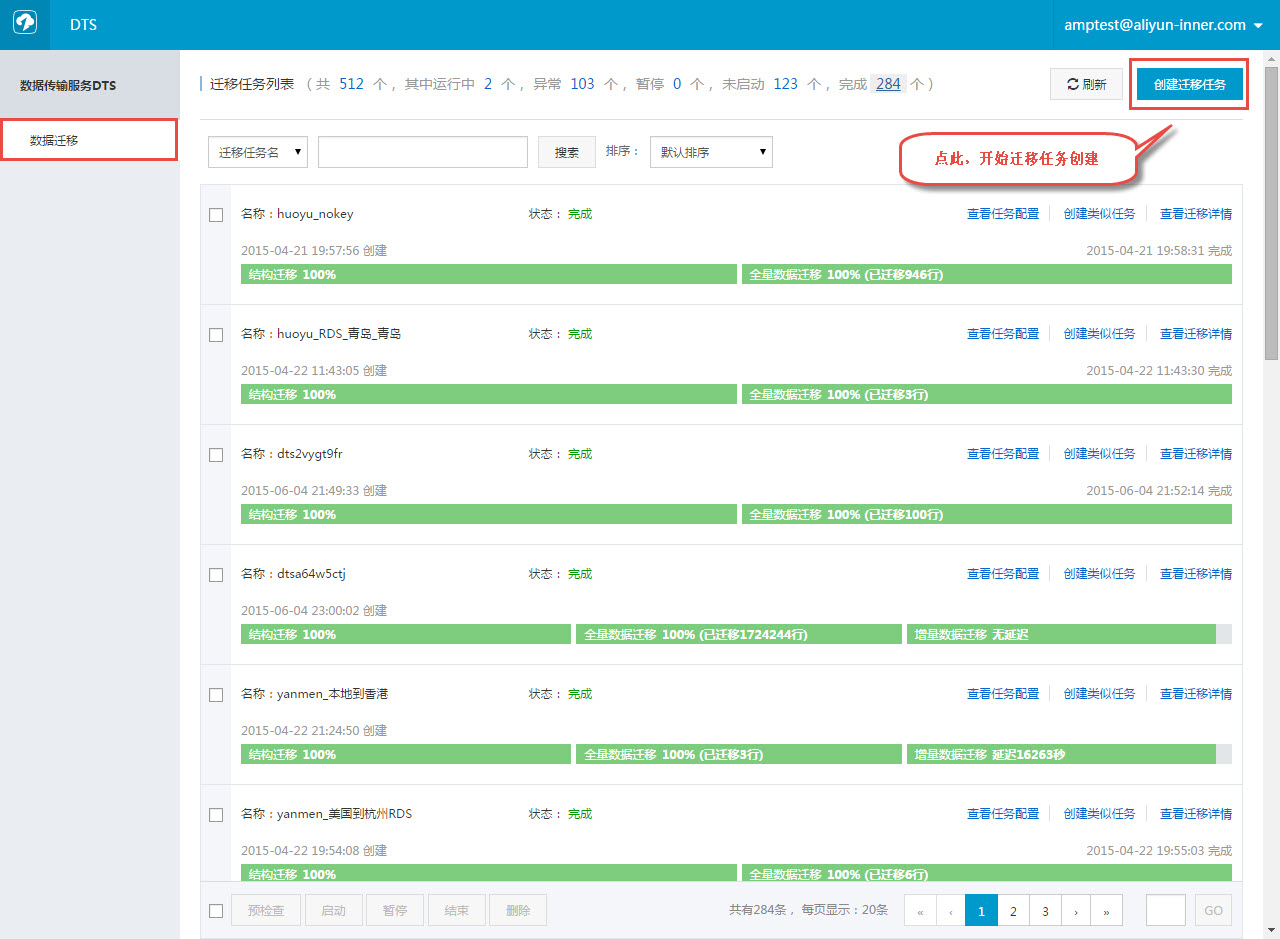

1) 进入DTS控制台,点击创建迁移任务,正式开始任务创建。

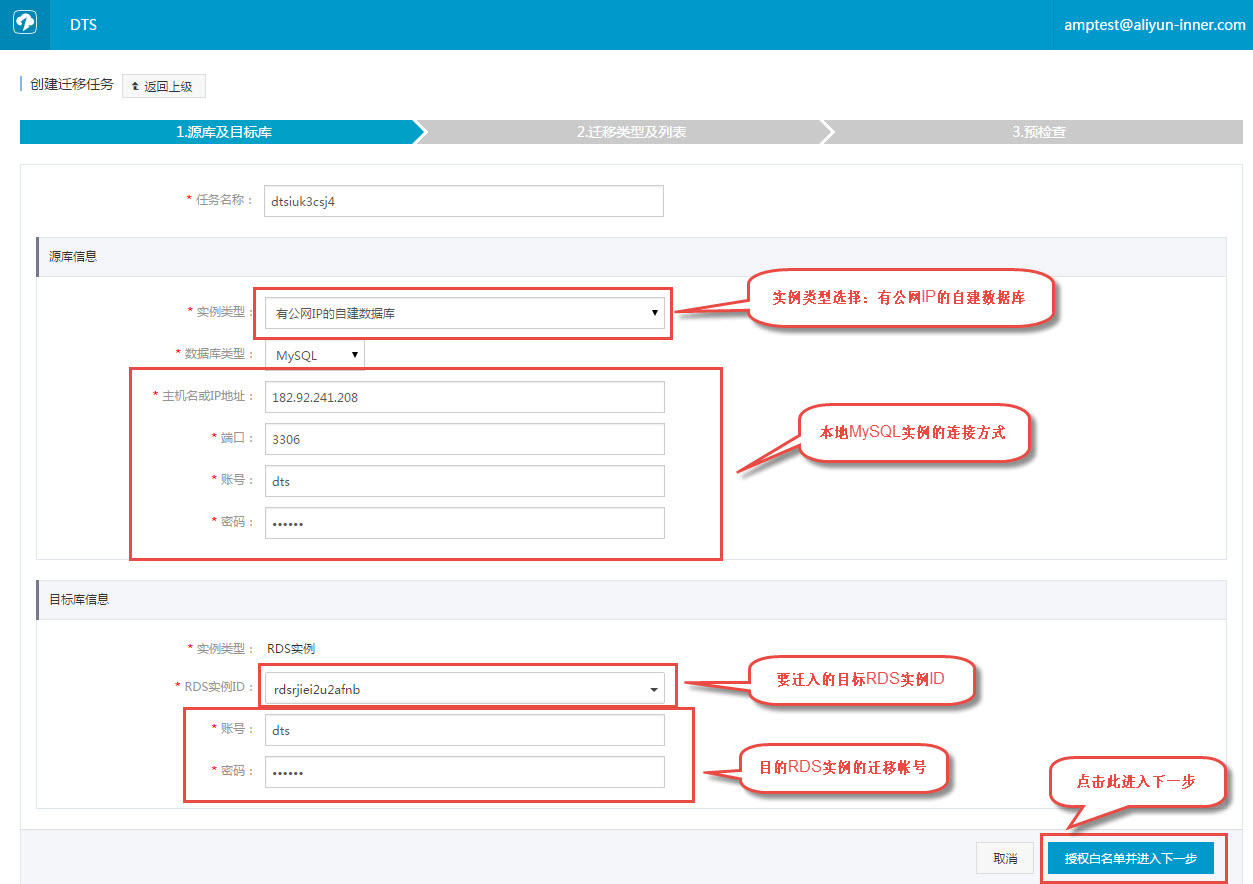

2) 填写配置源及目标RDS实例的连接信息

这里面源实例的实例类型需要选择“有公网IP的自建数据库”,源实例的主机名或IP地址填写ECS实例的公网IP

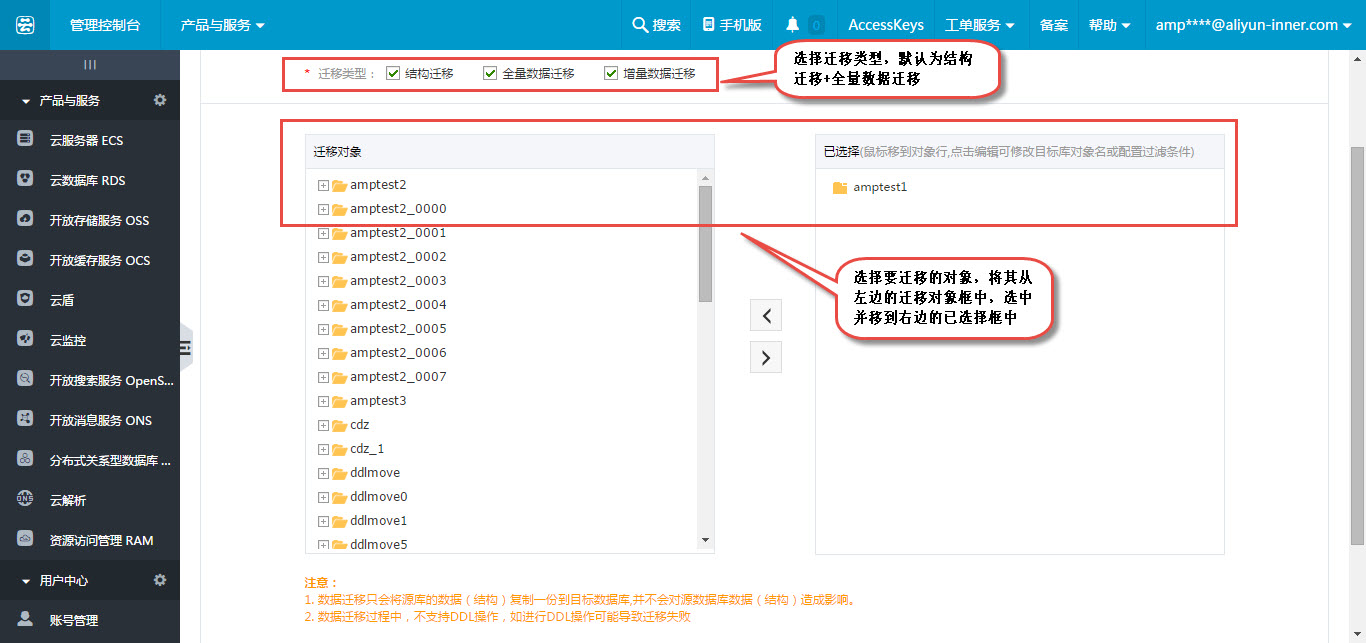

3) 选择迁移类型及迁移对象

在这个步骤需要配置要迁移的对象列表。 配置完后,进入迁移预检查

4) 预检查

当预检查通过后,可以启动迁移任务

5) 启动迁移任务

至此,完成跨阿里云账号的ECS自建数据库迁移至RDS的迁移任务配置。

如果您想详细了解数据传输,请访问:

触发器存在情况下如何配置同步作业:

https://help.aliyun.com/document_detail/dts/Best-Practice/Config-Synchronous-Database-Trigger-Exists.html?spm=5176.docdts/Best-Practice/SDK-Failover.6.136.sRnnXI