今天的头条文章是Nature关于“论文零引用”的研究。2017年,各路AI会议颇多、论文频出,有哪些论文值得关注?它们给这个世界带来了什么样的影响?我们希望这个小栏目的存在,能让论文重新“发声”,得到更多关注。

如果你也有印象深刻的论文,本栏目欢迎你带着对论文的解读投稿,也希望更多论文作者主动联系我们。联系邮箱:zz@bigdatadigest.cn

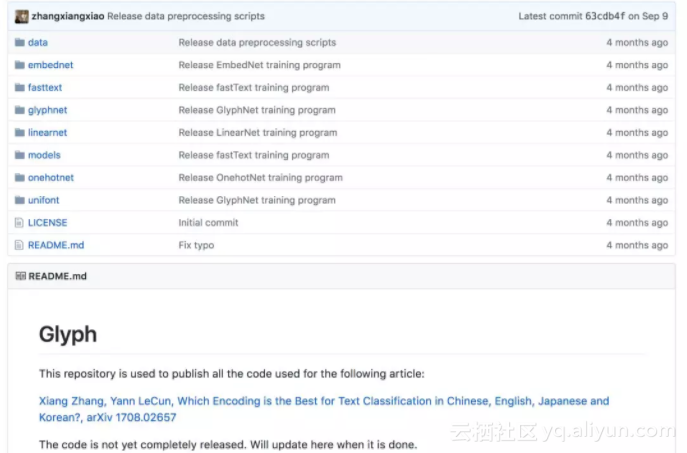

今年8月,纽约大学教授、Facebook人工智能实验室主任Yann LeCun及其博士生Xiang Zhang在Arxiv上发表了论文“何种编码机制最适合中文、英语、日语、韩语的文本分类?”

他们首次对37种现有编码方法进行了系统性研究,使用到14个多语言数据库(共473个模型),数据集来自中国在线餐饮评论网站dianping.com,日本在线购物网站rakuten.co.jp,韩国在线购物网站11st.co.kr和“纽约时报”等网站,样本量超过1000万。

最终,性能最佳的是字符级5-gram fastText模型。fastText是Facebook AI实验室开发的一种开源方法。

他们的研究让多语言文本处理更加高效,对中文、日语和韩语的文本处理也在提醒我们AI研究的全球性。

他们也将开源他们的代码,代码地址:

https://github.com/zhangxiangxiao/glyph

论文第一作者Xiang Zhang的个人主页:

http://xzh.me/

信息来源:Twitter, Medium

论文地址:

https://arxiv.org/abs/1708.02657

原文发布时间为:2017-12-27

本文作者:龙牧雪